ai cybersecurity: hoe ai-assistenten bedreigingen in realtime detecteren

AI helpt SECURITY TEAMS anomalieën en bedreigingen op schaal te detecteren, en doet dat continu. Bijvoorbeeld kan een AI-assistent logs monitoren, telemetrie correleren en een realtime waarschuwing geven wanneer patronen overeenkomen met een bekende handtekening of een ongebruikelijk gedragsvingerafdruk. Deze mogelijkheid is belangrijk omdat 77% van de bedrijven AI in operatie gebruikt of onderzoekt, wat de sterke AI-adoptie in bedrijfsomgevingen verklaart 77% adoptiecijfer. In de praktijk draaien AI-gestuurde telemetrie-ingestie, feature-extractie en scoring vele malen sneller dan handmatige beoordeling. De stroom begint meestal met telemetrie → een AI-model → waarschuwingtriage → respons. Een eenvoudige lus kan er zo uitzien: sensoren voeden endpoint- en netwerkgegevens, het AI-model scoort anomalieën, het systeem genereert een waarschuwing en vervolgens activeert containment een playbook. Dit is vooral handig voor realtime dreigingsdetectie waarbij minuten van belang zijn.

AI-cybersecuritytools voeden al veel detectie- en respons-pijplijnen. A Review of Agentic AI merkt op dat agentische AI zich kan aanpassen aan opkomende bedreigingen en met cognitieve autonomie kan handelen wanneer dit is geconfigureerd agentische AI in cybersecurity. Platforms die gedragsbaselines combineren met streaminganalyse verminderen daardoor de dwell-tijd en belichten onbekend gedrag. In een kort praktijkvoorbeeld detecteert het systeem een patroon van laterale beweging, geeft het een waarschuwing, isoleert het endpoint en escaleert het incident naar het SOC voor beoordeling. Die geautomatiseerde containment-lus bespaart tijd en vermindert menselijke fouten.

Beveiligingsarchitecten moeten beslissen wat te automatiseren en wat voor analisten blijft. Voor realtime monitoring kan AI ruis filteren en bedreigingen prioriteren op een manier die beveiligingsteams helpt zich op hoogrisico-incidenten te concentreren. Tegelijkertijd moeten teams provenance en confidence scores eisen voor elke aanbeveling, omdat studies tonen dat AI-uitvoer onnauwkeurigheden en bronfouten kan bevatten die van belang zijn in een beveiligingscontext bronfoutenstudie. Ook bieden leveranciers nu AI-gestuurde cybersecurityplatforms die integreren met SIEM, EDR en cloudfeeds, wat een snelle detectie- en responsworkflow mogelijk maakt en mensen in de lus houdt voor kritieke beslissingen.

Voor organisaties met een hoge e-mailbelasting zijn er ook operationele AI-toepassingen. Bijvoorbeeld gebruikt virtualworkforce.ai AI-agents om e-maillifecycles voor operatieteams te automatiseren, berichten te routeren en context aan escalaties toe te voegen. Dat vermindert tijdverlies bij triage en helpt teams een sterkere beveiligingshouding te behouden in communicatie. Kortom, ai cybersecurity in actie detecteert zowel bedreigingen in realtime als stroomlijnt het operationele werk dat SOC-personeel anders kan afleiden.

security operations: using ai assistant to speed detection and remediation

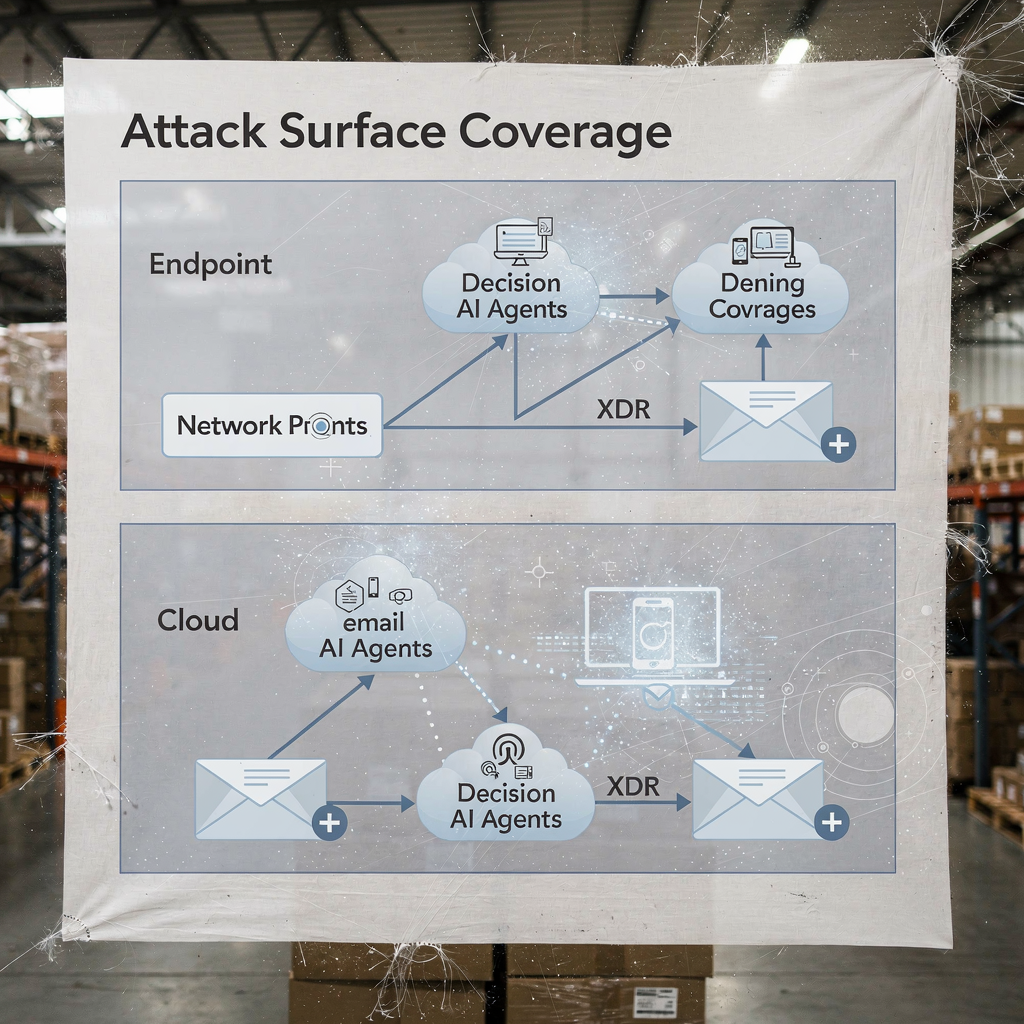

Security operations vertrouwen op snelle, herhaalbare workflows. AI kan forensische tijdlijnen automatiseren, playbooks uitvoeren en het herstel versnellen terwijl het SOC de controle behoudt. Bijvoorbeeld maken integraties tussen XDR en SOAR het mogelijk dat een AI-gestuurde suggestiemotor containment-stappen voorstelt, waarna een engineer ze kan goedkeuren of overschrijven. Deze mix van automatisering en menselijke supervisie verkort de mean time to detect en mean time to remediate. Automatisering verlaagt daadwerkelijk de werklast van analisten en kan false positives verminderen wanneer XDR-correlaties luidruchtige signalen filteren.

Use-cases tonen praktische voordelen. Een AI-model kan duizenden waarschuwingen parsen, vergelijkbare incidenten groeperen en een korte samenvatting voor een analist genereren. Dan beslist de analist of er geëscaleerd moet worden. Voor routinematige phishing-gevallen kan het systeem berichten in quarantaine plaatsen en aangetaste endpoints markeren, waarna het SOC de geautomatiseerde actie bekijkt. Deze aanpak helpt SOC-teams zich te richten op onderzoeken die menselijk oordeel vereisen. Ook versnelt automatisering van bewijsverzameling en tijdlijnconstructie onderzoeken en vermindert het risico dat indicatoren worden gemist.

Teams moeten een change-management checklist volgen voordat automatische acties worden ingeschakeld. Eerst, definieer drempels en confidence scores. Ten tweede, koppel playbooks aan rollen en goedkeuringen. Ten derde, implementeer monitoring en rollbacks. Ten vierde, log elke geautomatiseerde stap voor auditbaarheid. Deze stappen helpen de omgeving te beschermen en compliance te handhaven. Een praktisch dashboard toont AI-voorstellen met duidelijke overrides; dit stroomlijnt de workflow en behoudt verantwoording.

Metrieken om te volgen zijn onder andere waarschuwingen getriageerd per uur, false positive rate en time to containment. Deze KPI’s tonen verbetering aan terwijl teams verantwoordelijk blijven. Ook zou het SOC periodieke red-team checks en gesimuleerde incidenten moeten draaien om het AI-model te valideren en automatiseringsbias onder analisten te verminderen. Onderzoek geeft aan dat automatiseringsbias een groot deel van beveiligingsprofessionals beïnvloedt, daarom zijn verplichte verificatiestappen van belang menselijke factoren en automatiseringsbias. Tot slot moeten teams documenteren wanneer het systeem AI gebruikt om automatisch te escaleren en wanneer het op menselijke goedkeuring wacht. Dit duidelijke beleid helpt zowel CISO’s als frontlinie-responders.

Wanneer uw operaties veel e-mailverkeer omvatten, overweeg dan beveiligingsautomatisering te combineren met e-mailautomatiseringsplatforms. virtualworkforce.ai helpt teams operationele e-mails te routeren en op te lossen, waardoor luidruchtige contexten die anders SOC-tijd verspillen worden verminderd. Voor meer over het automatiseren van logistieke e-mail en het opschalen van operationele workflows, zie deze bron over geautomatiseerde logistieke correspondentie geautomatiseerde logistieke correspondentie.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

xdr and darktrace: agentic ai examples in extended detection

Extended detection and response-platforms verenigen signalen van endpoint, netwerk, cloud en e-mail. XDR correleert deze telemetriebronnen en past modellen toe om complexe aanvalsbanen te onthullen. Darktrace biedt gedragsmodellering en agentische AI-functies die zich aanpassen aan veranderende baselines. In recente productupdates benadrukte Darktrace autonome forensics en adaptieve responsen, waarbij het platform containment-acties kan ondernemen en mensleesbare onderbouwing voor die stappen kan genereren. Deze aanpak biedt teams een snellere route naar detectie en respons voor zowel bekende als nieuwe bedreigingen.

Een typisch scenario begint met afwijkend endpoint-gedrag dat niet overeenkomt met een bekende signatuur. XDR correlereert die actie met ongebruikelijke netwerkstromen, en het platform flagt laterale beweging. Dan isoleert een containment-actie het endpoint, terwijl geautomatiseerde forensics artifacts vastlegt. Darktrace AI-voorbeelden tonen hoe machine learning de acties van een aanvaller over apparaten kan in kaart brengen en vervolgens een respons kan voorstellen die het aanvalsoppervlak isoleert. Die reeks helpt te verdedigen tegen ransomware en laterale propagatie.

Praktische integratie vereist een checklist. Eerst, zorg dat uw XDR aan SIEM en SOAR is gekoppeld voor event enrichment. Ten tweede, map response-playbooks voor automatische versus handmatige acties. Ten derde, configureer het platform om context naar ticketing en e-mail te exporteren, zodat SOC-teams end-to-end traceerbaarheid behouden. Ten vierde, test EDR-naar-XDR overdrachten en bevestig telemetrie-fideliteit. Een gelaagd diagram van XDR-dekking en AI-besluitpunten verduidelijkt wie wanneer handelt.

XDR-voordelen strekken zich uit tot cloudbeveiliging en e-mailbeveiligingspaden. Het platform combineert endpoint-telemetrie, netwerkstromen en threat intelligence om een breder beeld van de enterprise security posture te creëren. In implementaties die Darktrace betrekken, kunnen beveiligingsteams inzichten zien in aanvallersgedrag en snelle containment-opties. Toch moeten teams agentische AI-beslissingen door audits valideren en een log bijhouden van elke autonoom uitgevoerde stap voor governance. Voor organisaties in logistiek en operatie helpt het integreren van XDR-inzichten met e-mailautomatisering continuïteit te behouden terwijl bedreigingen via phishing of gecompromitteerde accounts worden getriageerd. Zie hoe AI expeditiecommunicatie kan opschalen en context in operationele berichten behoudt AI voor expediteurcommunicatie.

analyst: automation bias, accuracy limits and ai is used as decision aid

Menselijke factoren bepalen hoe teams AI adopteren. Automatiseringsbias en confirmation bias kunnen ertoe leiden dat security-analisten te veel op AI-uitvoer vertrouwen. Studies tonen aan dat automatiseringsbias een groot deel van de beoefenaars beïnvloedt, en analisten moeten leren AI te behandelen als besluitondersteuning in plaats van als orakel menselijke factoren in AI-gestuurde cybersecurity. Ook bleek uit onderzoek dat veel AI-gegenereerde antwoorden onnauwkeurigheden en bronproblemen bevatten, wat cruciaal is voor incidentrespons waar vertrouwen in feiten telt AI-assistent bronfouten. Daarom moeten SOC-leiders verplichte verificatiestappen en confidence-drempels toevoegen aan elke geautomatiseerde aanbeveling.

Training speelt een grote rol. Teams moeten scenario-oefeningen draaien, red-team oefeningen uitvoeren en analisten verplichten bewijs te valideren voordat een incident wordt gesloten. Een praktisch controlemiddel is het tonen van provenance voor elke aanbeveling zodat analisten waarschuwingen kunnen herleiden naar ruwe logs en de staat van het AI-model. Voer ook foutafhandelingsprocedures in die specificeren wat te doen wanneer het systeem lage confidence of inconsistente uitvoer toont. Dit proces vermindert risico’s en houdt mensen betrokken bij kritisch denken.

Transparantie helpt ook. Het presenteren van een samenvatting waarom een suggestie is ontstaan, de signalen die het ondersteunden en de modelversie die het genereerde, bouwt vertrouwen op. Voor analytisch werk dat natuurlijke-taal-samenvattingen gebruikt, label ze duidelijk om overbetrouw te vermijden. Omdat AI nu veel gebruikt wordt, moeten teams snelheid en zorgvuldigheid balanceren. Het gebruik van confidence scores en het vereisen van handtekening van een analist voor escalaties reduceert blinde automatisering.

Tot slot, waak tegen shadow AI in teams. Shadow AI ontstaat wanneer individuen niet-goedgekeurde genai-tools of gen ai-diensten gebruiken voor snelle antwoorden. Deze praktijk kan gevoelige gegevens lekken en inconsistente logica in onderzoeken introduceren. Stel goedgekeurde genai-tools op en een veilige workflow voor externe queries of model-aanroepen. Geef analisten een duidelijk pad om complexe zaken te escaleren. Kort gezegd, AI moet de analist versterken, niet het oordeel vervangen.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

vulnerability and sensitive data: ai to monitor, defend and create new risks

AI helpt kwetsbaarheden te vinden en gevoelige data te beschermen, en toch brengt het nieuwe risico’s met zich mee. Aan de verdedigende kant kan AI logs en webverkeer monitoren om patronen te detecteren die op CVE-exploitatiepogingen wijzen, en vervolgens remediatie triggeren om getroffen workloads te patchen of te isoleren. Tegelijkertijd kunnen kwaadwillenden AI-agents inzetten om reconnaissance te automatiseren, gerichte phishing te maken en zelfs malwarevarianten te genereren. Artikelen over opkomende bedreigingen noteren de opkomst van geautomatiseerde of kwaadaardige AI-medewerkers die insider-achtige social engineering kunnen uitvoeren kwaadaardige AI-medewerkerbedreiging. Die dualiteit verhoogt de inzet voor hoe u de toegang tot gevoelige data beheert.

Privacyzorgen ontstaan wanneer AI toegang krijgt tot logs met PII of operationele geheimen. Om lekken te voorkomen, handhaaf strikte datapolicy’s, gebruik input/output-filtering en geef de voorkeur aan on-premises of private-modelimplementaties voor workloads met hoge sensitiviteit. Log ook alle AI-acties en queries zodat u beslissingen kunt reconstrueren en anomalieën in data-egress kunt identificeren. Voor teams die operationele e-mails afhandelen, zorgt het dat e-mailautomatiseringsplatforms data-gronding en governance over ERP- en documentbronnen toepassen om accidentele openbaarmaking te voorkomen. Ontdek hoe e-mailautomatisering context behoudt en handmatige opzoekacties vermindert in logistieke workflows ERP e-mailautomatisering voor logistiek.

Ontwerp controles om kwaadaardige AI-activiteit te detecteren. Monitor naar afwijkende queryvolumes en ongebruikelijke patroonvorming die kunnen wijzen op een geautomatiseerd discovery-tool of een exfiltratiepipeline. Implementeer throttles en quota op queries die grote datasets benaderen. Voer threat hunting uit die aanneemt dat aanvallers generatieve AI kunnen gebruiken om polymorfe phishing te maken en geloofwaardige social engineering-berichten op schaal samen te stellen. Controleer ook modeluitvoer op hallucinaties of ongefundeerde beweringen, omdat bronfouten analisten kunnen misleiden en systemen kunnen blootstellen aan onjuiste remediasteps.

Bescherm tenslotte de modellen zelf. Model-poisoning en datapoisoning-aanvallen kunnen leermodellen vertekenen en detectie-accuratesse verminderen. Periodieke modelvalidatie en dataprovenance-controles helpen poisoning-pogingen vroegtijdig te detecteren. Houd ondertekende modelversies bij en een rollback-plan voor gecompromitteerde of gedegradeerde modellen. Gecombineerd helpen deze stappen gevoelige data te verdedigen terwijl AI systemen effectief monitoren en beschermen.

ai security and proactive cybersecurity: governance, validation and ai at every stage

Governance blijft de basis voor veilige AI-adoptie. Implementeer modelvalidatie, continue testing, explainability en lifecycle-beleid voordat u grootschalig uitrolt. Vereis provenance- en sourcingchecks, voer periodieke nauwkeurigheidsaudits uit en gebruik gefaseerde uitrol met rollback-criteria. Deze controles stemmen overeen met regelgevende verplichtingen zoals GDPR en EU-richtlijnen rond dataprotectie en transparantie. Betrek ook CISOs bij governance-beoordelingen en eis duidelijke incidentplaybooks die modelleringen dekken.

Praktische stappen omvatten pre-deployment testing, runtime monitoring, incidentplaybooks en gedefinieerde rollback-criteria. Houd bijvoorbeeld een pre-deployment dry run waarin het AI-model tegen een testcorpus wordt gecontroleerd dat bekende kwaadaardige voorbeelden, noisy traffic en privacygevoelige items bevat. Monitor vervolgens drift en nauwkeurigheid in productie en plan maandelijkse audits. Gebruik explainability-tools om analisten een rationale achter belangrijke beslissingen te bieden. Zulke stappen maken AI-gestuurde cybersecurityoplossingen auditeerbaar en betrouwbaar.

Neem een checklist aan voor productiegebruik: bevestig toegangscontroles, implementeer input-sanitatie, stel retentiebeleid in en vereis ondertekende logs van elke geautomatiseerde actie. Volg KPI’s zoals false positive rate, time to containment en percentage waarschuwingen opgelost met menselijke supervisie. Bereid ook een roadmap voor de eerste 90 dagen voor elke AI-implementatie: baselinemetingen, sandbox-tests, gefaseerde inschakeling, training en governance-goedkeuring. Deze aanpak helpt proactieve cybersecurity te leveren die zowel bekende als onbekende bedreigingen kan detecteren.

Tot slot, balanceer innovatie met voorzichtigheid. Geavanceerde AI en deep learning brengen nieuwe mogelijkheden voor verdedigers, maar governance houdt die mogelijkheden in lijn met uw security-houding. Als u operaties wilt opschalen zonder extra personeel, verken het automatiseren van repetitieve stromen zoals operationele e-mailafhandeling; virtualworkforce.ai toont hoe AI-agents afhandelingstijd kunnen verminderen en context aan escalaties kunnen koppelen, wat zowel productiviteit als beveiligingsdoelen ondersteunt hoe logistieke operaties zonder personeel op te schalen. Begin klein, meet impact en iterpeer met duidelijke guardrails.

FAQ

What is an AI assistant in cybersecurity?

Een AI-assistent in cybersecurity is een geautomatiseerde agent die helpt bij het monitoren, analyseren en prioriteren van beveiligingsevenementen. Het biedt besluitondersteuning, automatiseert routinetaken van onderzoek en signaleert waarschuwingen met hoge confidence voor menselijke beoordeling.

How do AI systems detect threats in real time?

AI-systemen nemen telemetrie binnen van endpoints, netwerk en cloud en passen vervolgens modellen toe om anomalieën te detecteren die op compromittering wijzen. Ze scoren events, groeperen gerelateerde activiteit en genereren realtime waarschuwingen zodat teams snel kunnen handelen.

Can AI reduce mean time to detect (MTTD)?

Ja. AI versnelt triage door waarschuwingen te groeperen, bewijs samen te vatten en playbook-stappen voor te stellen, wat de MTTD verlaagt. Teams moeten echter outputs valideren om automatiseringsbias en false positives te vermijden.

What is XDR and how does it use AI?

XDR staat voor extended detection and response en verenigt signalen van endpoint, netwerk, cloud en e-mail. XDR-platforms gebruiken AI-agents en gedragsmodellen om events te correleren en containment-acties voor te stellen.

Are AI recommendations always accurate?

Nee. Studies tonen aan dat AI-uitvoer onnauwkeurigheden en bronfouten kan bevatten, dus organisaties moeten provenance, confidence scores en menselijke verificatie eisen. Regelmatige audits en validatie verminderen het risico op foutieve acties.

How do you prevent AI from leaking sensitive data?

Beperk modeltoegang, gebruik input/output-filtering, geef de voorkeur aan on-premises of private-modelopties voor gevoelige workloads en log elke AI-actie. Datatoegangsbeleid en retentieregels verminderen ook het risico op datalekken.

What is automation bias and how does it affect security analysts?

Automatiseringsbias ontstaat wanneer analisten AI-uitvoer te veel vertrouwen en onafhankelijke verificatie nalaten. Het kan leiden tot gemiste anomalieën; training, confidence-drempels en verplichte verificatiestappen helpen dit te mitigeren.

How should organisations govern AI in security?

Governance moet pre-deployment testing, continue monitoring, explainability, provenance-checks en gefaseerde uitrols omvatten. Stem deze controles af op regelgevingen zoals GDPR en interne compliancekaders.

Can AI help with email-related security and operations?

Ja. AI kan e-mailtriage automatiseren, intentie classificeren, context toevoegen en antwoorden opstellen terwijl auditsporen behouden blijven. Tools die antwoorden baseren op ERP- en documentensystemen kunnen handmatige zoekacties verminderen en beveiligingsexposures verkleinen. Voor voorbeelden in logistieke e-mailautomatisering, zie deze bron over AI in vrachtlogistieke communicatie AI in vrachtlogistieke communicatie.

What are the first steps to deploy an AI assistant safely?

Begin met een kleine pilot, definieer KPI’s, voer modelvalidatie uit en vereis human-in-the-loop goedkeuringen voor ingrijpende acties. Bereid ook rollback-plannen voor en train analisten in foutafhandeling en verificatieprocedures.

Ready to revolutionize your workplace?

Achieve more with your existing team with Virtual Workforce.