ai cybersecurity: wie KI-Assistenten Bedrohungen in Echtzeit erkennen

KI hilft SICHERHEITSTEAMS, Anomalien und Bedrohungen in großem Umfang zu erkennen, und das kontinuierlich. Beispielsweise kann ein KI‑Assistent Logs überwachen, Telemetrie korrelieren und eine Echtzeit‑Warnung auslösen, wenn Muster einer bekannten Signatur oder einem ungewöhnlichen Verhaltens‑Fingerprint entsprechen. Diese Fähigkeit ist wichtig, weil 77% der Unternehmen KI entweder bereits in Betrieb nutzen oder deren Einsatz prüfen, was die starke KI‑Adoption in Unternehmensumgebungen erklärt 77% Adoptionsstatistik. In der Praxis laufen KI‑gestützte Telemetrie‑Ingestion, Feature‑Extraktion und Scoring vielfach schneller als manuelle Prüfungen. Der Ablauf beginnt typischerweise mit Telemetrie → ein KI‑Modell → Alarm‑Triage → Reaktion. Eine einfache Schleife könnte so aussehen: Sensoren liefern Endpoint‑ und Netzwerkdaten, das KI‑Modell bewertet Anomalien, das System erzeugt eine Warnung und dann löst die Eindämmung ein Playbook aus. Das ist besonders nützlich für die Erkennung von Bedrohungen in Echtzeit, bei denen Minuten entscheidend sind.

KI‑Cybersicherheits‑Tools treiben bereits viele Erkennungs‑ und Reaktions‑Pipelines an. Ein Review zu agentischer KI stellt fest, dass agentische KI sich an aufkommende Bedrohungen anpassen und mit kognitiver Autonomie handeln kann, wenn sie entsprechend konfiguriert ist Agentische KI in der Cybersicherheit. Daher reduzieren Plattformen, die Verhaltens‑Baselines mit Streaming‑Analysen kombinieren, die Verweildauer und heben unbekannte Verhaltensweisen hervor. In einem kurzen Anwendungsfall erkennt das System ein seitliches Bewegungsmuster, meldet einen Alarm, isoliert den Endpoint und eskaliert den Vorfall an das SOC zur Prüfung. Diese automatisierte Eindämmungsschleife spart Zeit und reduziert menschliche Fehler.

Sicherheitsarchitekten müssen entscheiden, was automatisiert und was den Analysten überlassen wird. Für die Echtzeitüberwachung kann KI Rauschen filtern und Bedrohungen priorisieren, sodass Sicherheitsteams sich auf Vorfälle mit hohem Risiko konzentrieren können. Gleichzeitig sollten Teams für jede Empfehlung Herkunftsangaben und Vertrauens‑Scores verlangen, da Studien zeigen, dass KI‑Outputs Ungenauigkeiten und Quellenfehler enthalten können, die im Sicherheitskontext relevant sind Studie zu Sourcing-Fehlern. Außerdem bieten Anbieter inzwischen KI‑gestützte Cybersicherheitsplattformen an, die sich in SIEM, EDR und Cloud‑Feeds integrieren lassen und einen schnellen Erkennungs‑ und Reaktionsworkflow ermöglichen, während Menschen für kritische Entscheidungen in der Schleife bleiben.

Für Organisationen mit hohem E‑Mail‑Aufkommen gibt es auch operative KI‑Anwendungen. Zum Beispiel nutzt virtualworkforce.ai KI‑Agenten, um E‑Mail‑Lebenszyklen für Ops‑Teams zu automatisieren, Nachrichten zu routen und Kontext an Eskalationen anzuhängen. Das reduziert Zeitverluste bei der Triage und hilft den Teams, eine stärkere Sicherheitslage in der Kommunikation aufrechtzuerhalten. Kurz gesagt: AI Cybersecurity in der Praxis erkennt Bedrohungen in Echtzeit und hilft zugleich, den operativen Overhead zu straffen, der SOC‑Personal sonst ablenken könnte.

security operations: Einsatz von KI‑Assistenten zur Beschleunigung von Erkennung und Behebung

Security Operations stützen sich auf schnelle, wiederholbare Workflows. KI kann forensische Zeitlinien automatisieren, Playbooks ausführen und die Behebung beschleunigen, während das SOC die Kontrolle behält. Beispielsweise ermöglichen Integrationen zwischen XDR und SOAR einer KI‑gestützten Vorschlagsengine, Eindämmungsschritte vorzuschlagen, die dann ein Ingenieur genehmigen oder überschreiben kann. Diese Mischung aus Automatisierung und menschlicher Aufsicht verkürzt die mittlere Zeit bis zur Erkennung und die mittlere Zeit bis zur Behebung. Tatsächlich reduziert Automatisierung die Arbeitsbelastung der Analysten und kann False Positives verringern, wenn XDR‑Korrelationen laute Signale filtern.

Anwendungsfälle zeigen praktische Vorteile. Ein KI‑Modell kann Tausende von Alarmen parsen, ähnliche Vorfälle gruppieren und eine kurze Zusammenfassung für einen Analysten erzeugen. Dann entscheidet der Analyst, ob eskaliert wird. Bei Routine‑Phishing‑Fällen kann das System Nachrichten isolieren und betroffene Endpoints markieren; anschließend prüft das SOC die automatische Maßnahme. Dieser Ansatz hilft SOC‑Teams, sich auf Untersuchungen zu konzentrieren, die menschliches Urteilsvermögen erfordern. Außerdem beschleunigt die Automatisierung der Beweissammlung und der Erstellung von Zeitlinien Untersuchungen und reduziert das Risiko übersehener Indikatoren.

Teams sollten vor dem Aktivieren automatischer Aktionen eine Change‑Management‑Checkliste befolgen. Zuerst Schwellenwerte und Vertrauens‑Scores definieren. Zweitens Playbooks auf Rollen und Genehmigungen abbilden. Drittens Monitoring und Rollbacks implementieren. Viertens jeden automatisierten Schritt protokollieren, um Prüf‑ und Revisionsfähigkeit sicherzustellen. Diese Schritte helfen, die Umgebung zu schützen und Compliance zu wahren. Ein praxisorientiertes Dashboard zeigt KI‑Vorschläge mit klaren Überschreibungsoptionen; das strafft den Workflow und bewahrt Verantwortlichkeit.

Metriken, die zu verfolgen sind, umfassen pro Stunde triagierte Alarme, False‑Positive‑Rate und Zeit bis zur Eindämmung. Diese KPIs zeigen Verbesserungen und halten Teams verantwortlich. Zudem sollte das SOC periodische Red‑Team‑Checks und simulierte Vorfälle durchführen, um das KI‑Modell zu validieren und Automationsbias unter Analysten zu reduzieren. Forschungsergebnisse weisen darauf hin, dass Automationsbias einen großen Anteil der Sicherheitsfachleute betrifft, weshalb verpflichtende Verifikationsschritte wichtig sind Menschliche Faktoren und Automationsbias. Schließlich sollten Teams dokumentieren, wann das System KI zur automatischen Eskalation nutzt und wann es auf menschliche Genehmigung wartet. Diese klare Richtlinie hilft sowohl CISOs als auch Ersthelfern.

Wenn Ihre Abläufe umfangreiche E‑Mail‑Workflows umfassen, sollten Sie die Sicherheitsautomatisierung mit E‑Mail‑Automatisierungsplattformen kombinieren. virtualworkforce.ai hilft Teams, operative E‑Mails zu routen und zu bearbeiten, wodurch rauschender Kontext reduziert wird, der sonst SOC‑Zeit verschwendet. Für mehr zur Automatisierung logistischer E‑Mails und zur Skalierung operativer Workflows siehe diese Ressource zur automatisierten Logistikkorrespondenz Automatisierte Logistikkorrespondenz.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

xdr and darktrace: agentische KI‑Beispiele in Extended Detection

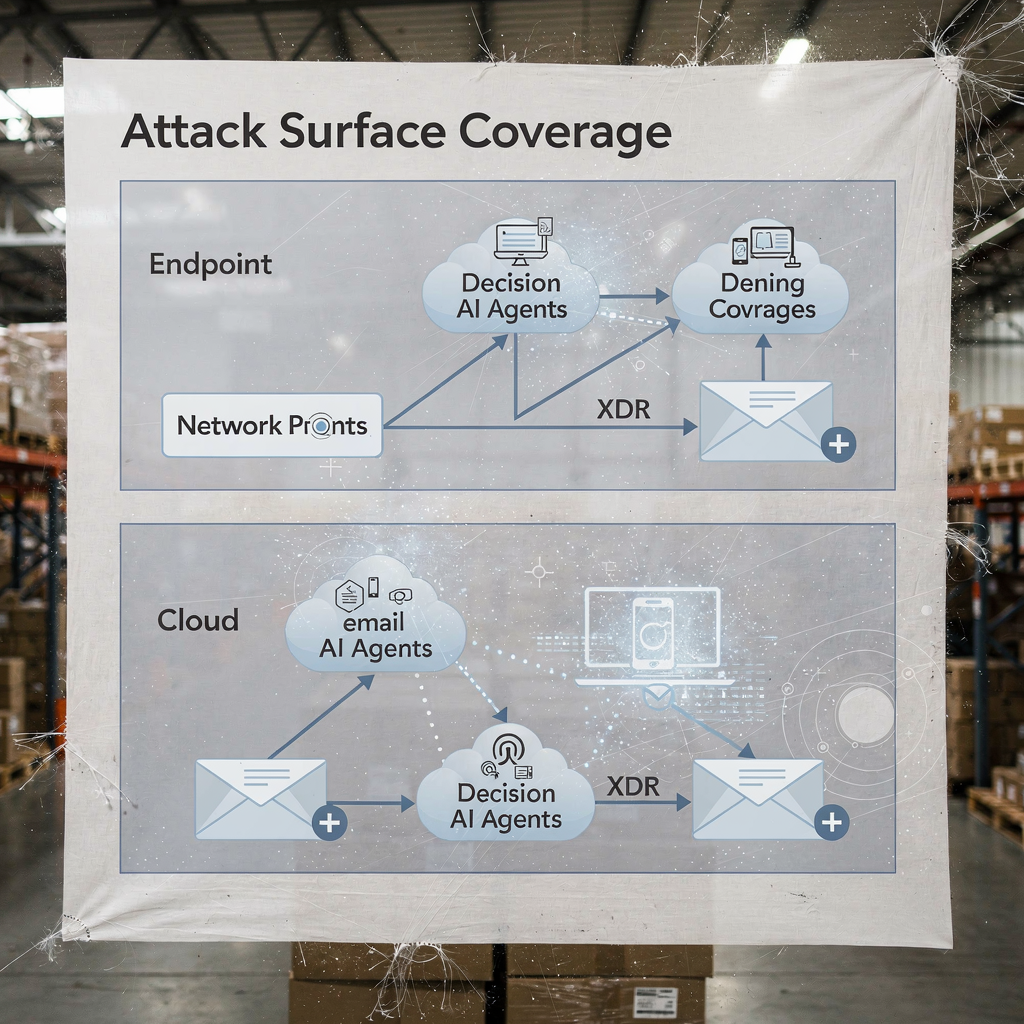

Extended Detection and Response‑Plattformen vereinheitlichen Signale über Endpoint, Netzwerk, Cloud und E‑Mail. XDR korreliert diese Telemetriequellen und wendet Modelle an, um komplexe Angriffswege offenzulegen. Darktrace bietet Verhaltensmodellierung und agentische KI‑Funktionen, die sich an veränderte Baselines anpassen. In jüngsten Produkt‑Updates betonte Darktrace autonome Forensik und adaptive Reaktionen, bei denen die Plattform Eindämmungsmaßnahmen ergreifen und eine für Menschen lesbare Begründung für diese Schritte generieren kann. Dieser Ansatz gibt Teams einen schnelleren Weg zur Erkennung und Reaktion auf sowohl bekannte als auch neuartige Bedrohungen.

Ein typisches Szenario beginnt mit anomalem Verhalten auf einem Endpoint, das keiner bekannten Signatur entspricht. XDR korreliert diese Aktion mit ungewöhnlichen Netzwerkflüssen, und die Plattform markiert laterale Bewegung. Dann isoliert eine Eindämmungsmaßnahme den Endpoint, während automatisierte Forensik Artefakte erfasst. Darktrace‑KI‑Beispiele zeigen, wie maschinelles Lernen die Aktionen eines Angreifers über Geräte hinweg abbilden und dann eine Antwort vorschlagen kann, die die Angriffsfläche isoliert. Diese Sequenz hilft, gegen Ransomware und laterale Ausbreitung zu verteidigen.

Praktische Integration erfordert eine Checkliste. Erstens sicherstellen, dass Ihr XDR in SIEM und SOAR eingebunden ist für Event‑Enrichment. Zweitens Response‑Playbooks für automatische versus manuelle Aktionen abbilden. Drittens die Plattform so konfigurieren, dass Kontext an Ticketing und E‑Mail exportiert wird, damit SOC‑Teams End‑to‑End‑Nachvollziehbarkeit behalten. Viertens EDR‑zu‑XDR‑Übergaben testen und Telemetrie‑Fidelity bestätigen. Ein geschichtetes Diagramm der XDR‑Abdeckung und der KI‑Entscheidungspunkte macht klar, wer wann handelt.

XDR‑Vorteile erstrecken sich auf Cloud‑Sicherheit und E‑Mail‑Sicherheitswege. Die Plattform kombiniert Endpoint‑Telemetrie, Netzwerkflüsse und Threat‑Intelligence, um ein umfassenderes Bild der unternehmensweiten Sicherheitslage zu erstellen. In Implementierungen, die Darktrace einbeziehen, können Sicherheitsteams Einblicke in das Angreiferverhalten und schnelle Eindämmungsoptionen sehen. Dennoch sollten Teams agentische KI‑Entscheidungen durch Audits validieren und ein Protokoll jeder autonom ausgeführten Aktion zur Governance führen. Für Organisationen in Logistik und Betrieb hilft die Integration von XDR‑Erkenntnissen mit E‑Mail‑Automatisierung, Kontinuität zu wahren, während Bedrohungen über Phishing oder kompromittierte Konten triagiert werden. Sehen Sie, wie KI Frachtkommunikation skalieren und Kontext in operativen Nachrichten bewahren kann KI für Spediteur‑Kommunikation.

analyst: Automationsbias, Genauigkeitsgrenzen und KI als Entscheidungsunterstützung

Menschliche Faktoren prägen, wie Teams KI übernehmen. Automationsbias und Bestätigungsbias können dazu führen, dass Sicherheitsanalysten KI‑Outputs zu sehr vertrauen. Studien zeigen, dass Automationsbias einen großen Anteil der Praktiker betrifft, und Analysten müssen lernen, KI als Entscheidungsunterstützung und nicht als Orakel zu behandeln Menschliche Faktoren in KI‑getriebener Cybersicherheit. Außerdem fand die Forschung heraus, dass viele KI‑generierte Antworten Ungenauigkeiten und Quellenprobleme enthalten, was für die Incident‑Response kritisch ist, da Vertrauen in Fakten entscheidend ist AI‑Assistenten‑Sourcing‑Fehler. Daher sollten SOC‑Leiter verpflichtende Verifikationsschritte und Vertrauensschwellen für jede automatisierte Empfehlung hinzufügen.

Schulung spielt eine große Rolle. Teams sollten Szenario‑Drills durchführen, Red‑Team‑Übungen abhalten und Analysten verpflichten, Beweise zu validieren, bevor ein Vorfall geschlossen wird. Eine praktische Kontrolle ist, für jede Empfehlung die Provenienz darzustellen, damit Analysten Alarme bis zu den Roh‑Logs und den KI‑Modellzuständen zurückverfolgen können. Außerdem Fehlerbehandlungsverfahren einführen, die angeben, was zu tun ist, wenn das System geringe Vertrauenswerte oder inkonsistente Outputs zeigt. Dieser Prozess reduziert Risiko und hält Menschen im kritischen Denkprozess engagiert.

Transparenz hilft ebenfalls. Eine Zusammenfassung zu präsentieren, warum ein Vorschlag zustande kam, welche Signale ihn stützten und welche Modellversion ihn erzeugte, schafft Vertrauen. Für analytische Arbeiten, die natürliche Sprach‑Zusammenfassungen verwenden, sollten diese klar gekennzeichnet werden, um Übervertrauen zu vermeiden. Da KI inzwischen weit verbreitet ist, müssen Teams Geschwindigkeit und Prüfung ausbalancieren. Der Einsatz von Vertrauens‑Scores und die Verpflichtung zu Analysten‑Sign‑offs bei Eskalationen reduzieren blinde Automatisierung.

Zuletzt: Schützen Sie sich vor Shadow‑AI im Team. Shadow‑AI entsteht, wenn Einzelne nicht autorisierte GenAI‑Tools oder GenAI‑Dienste für schnelle Antworten nutzen. Dieses Verhalten kann sensible Daten leaken und inkonsistente Logik in Untersuchungen einführen. Etablieren Sie genehmigte GenAI‑Tools und einen sicheren Workflow für externe Abfragen oder Modellaufrufe. Geben Sie Analysten einen klaren Weg, komplexe Fälle zu eskalieren. Kurz gesagt: KI sollte den Analysten befähigen, nicht das Urteil ersetzen.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

vulnerabilities and sensitive data: KI zur Überwachung, Verteidigung und als neues Risiko

KI hilft, Schwachstellen zu finden und sensible Daten zu verteidigen, bringt aber zugleich Dual‑Use‑Risiken mit sich. Auf der defensiven Seite kann KI Logs und Webverkehr überwachen, Muster erkennen, die auf CVE‑Ausnutzungsversuche hinweisen, und dann Remediation‑Schritte zum Patchen oder Isolieren betroffener Workloads auslösen. Gleichzeitig können bösartige Akteure KI‑Agenten einsetzen, um Reconnaissance zu automatisieren, gezielte Phishing‑Mails zu erstellen und sogar Malware‑Varianten zu generieren. Artikel zu aufkommenden Bedrohungen verweisen auf den Anstieg automatisierter oder bösartiger KI‑Angestellter, die insider‑ähnliche Social‑Engineering‑Angriffe durchführen können Bedrohung durch bösartige KI‑Mitarbeiter. Diese Dualität erhöht die Anforderungen daran, wie Sie den Zugriff auf sensible Daten verwalten.

Privatsphäre‑Bedenken treten auf, wenn KI auf Logs zugreift, die personenbezogene Daten oder operative Geheimnisse enthalten. Um Leaks vorzubeugen, setzen Sie strikte Datenzugriffsrichtlinien durch, verwenden Input/Output‑Filterung und bevorzugen On‑Premises‑ oder Private‑Model‑Deployments für hochsensible Workloads. Protokollieren Sie außerdem alle KI‑Aktionen und Abfragen, sodass Sie Entscheidungen rekonstruieren und anomalienhaften Datenaustritt identifizieren können. Für Teams, die operative E‑Mails bearbeiten, sorgt die Anwendung von Data‑Grounding und Governance durch E‑Mail‑Automatisierungsplattformen über ERP‑ und Dokumentenquellen hinweg dafür, dass versehentliche Offenlegungen verhindert werden. Erforschen Sie, wie E‑Mail‑Automatisierung Kontext bewahrt und manuelle Nachschläge in Logistik‑Workflows reduziert ERP‑E‑Mail‑Automatisierung für die Logistik.

Designen Sie Kontrollen, um bösartige KI‑Aktivität zu erkennen. Überwachen Sie anomale Abfragevolumina und ungewöhnliche Muster, die auf ein automatisiertes Discovery‑Tool oder eine Exfiltrations‑Pipeline hinweisen könnten. Implementieren Sie Drosselungen und Quotierungen für Abfragen, die große Datensätze betreffen. Führen Sie Threat‑Hunting durch, das davon ausgeht, dass Angreifer generative KI nutzen könnten, um polymorphe Phishing‑Kampagnen zu erstellen und plausibles Social Engineering im großen Stil durchzuführen. Prüfen Sie auch Modelloutputs auf Halluzinationen oder unbelegte Aussagen, denn Sourcing‑Fehler können Analysten in die Irre führen und Systeme zu falschen Remediation‑Schritten verleiten.

Schützen Sie schließlich die Modelle selbst. Model‑Poisoning und Data‑Poisoning‑Angriffe können Lernmodelle verfälschen und die Erkennungsgenauigkeit reduzieren. Periodische Modellvalidierung und Daten‑Provenance‑Checks helfen, Poisoning‑Versuche früh zu erkennen. Halten Sie signierte Modellversionen und einen Rollback‑Plan für kompromittierte oder degradierte Modelle bereit. Zusammengenommen helfen diese Maßnahmen, sensible Daten zu verteidigen und gleichzeitig KI zur Überwachung und zum Schutz von Systemen effektiv einzusetzen.

ai security and proactive cybersecurity: Governance, Validierung und KI in jeder Phase

Governance bleibt die Grundlage für eine sichere KI‑Adoption. Implementieren Sie Modellvalidierung, kontinuierliche Tests, Erklärbarkeit und Lifecycle‑Richtlinien, bevor Sie breit ausrollen. Fordern Sie Provenienz‑ und Quellenchecks, führen Sie regelmäßige Genauigkeits‑Audits durch und nutzen Sie gestaffelte Rollouts mit Rollback‑Kriterien. Diese Kontrollen stimmen mit regulatorischen Vorgaben wie der DSGVO und EU‑Leitlinien zu Datenminimierung und Transparenz überein. Beziehen Sie außerdem CISOs in Governance‑Reviews ein und verlangen Sie klare Incident‑Playbooks, die Modellfehler abdecken.

Praktische Schritte umfassen Pre‑Deployment‑Tests, Runtime‑Monitoring, Incident‑Playbooks und definierte Rollback‑Kriterien. Führen Sie beispielsweise einen Pre‑Deployment‑Dry‑Run durch, der das KI‑Modell gegen ein Testkorpus prüft, das bekannte bösartige Samples, verrauschten Traffic und datenschutzkritische Einträge enthält. Überwachen Sie dann Drift und Genauigkeit in der Produktion und planen Sie monatliche Audits. Nutzen Sie Explainability‑Tools, um Analysten die Entscheidungsgründe hinter Schlüsselentscheidungen zu liefern. Solche Schritte machen KI‑gestützte Cybersicherheitslösungen auditierbar und vertrauenswürdig.

Übernehmen Sie eine Checkliste für den Produktionseinsatz: Zugangskontrollen bestätigen, Input‑Sanitisierung implementieren, Aufbewahrungsrichtlinien setzen und signierte Logs jeder automatisierten Aktion verlangen. Verfolgen Sie KPIs wie False‑Positive‑Rate, Zeit bis zur Eindämmung und Prozentsatz der Alarme, die mit menschlicher Aufsicht gelöst wurden. Bereiten Sie außerdem einen 90‑Tage‑Startplan für jede KI‑Bereitstellung vor: Basislinienmetrik, Sandbox‑Tests, gestaffelte Aktivierung, Schulung und Governance‑Freigabe. Dieser Ansatz hilft, eine proaktive Cybersicherheit zu liefern, die sowohl bekannte als auch unbekannte Bedrohungen erkennen kann.

Schließlich: Balancieren Sie Innovation und Vorsicht. Fortschrittliche KI und Deep Learning bringen neue Fähigkeiten in das Werkzeugkasten der Verteidiger, doch Governance sorgt dafür, dass diese Fähigkeiten mit Ihrer Sicherheitsstrategie in Einklang stehen. Wenn Sie Abläufe ohne zusätzliches Personal skalieren müssen, prüfen Sie die Automatisierung repetitiver Abläufe wie operative E‑Mail‑Bearbeitung; virtualworkforce.ai zeigt, wie KI‑Agenten die Bearbeitungszeit reduzieren und Kontext an Eskalationen anhängen können, was sowohl Produktivität als auch Sicherheitsziele unterstützt Wie man Logistikprozesse ohne Neueinstellungen skaliert. Beginnen Sie klein, messen Sie den Effekt und iterieren Sie mit klaren Leitplanken.

FAQ

What is an AI assistant in cybersecurity?

Ein KI‑Assistent in der Cybersicherheit ist ein automatisierter Agent, der beim Überwachen, Analysieren und Priorisieren von Sicherheitsereignissen hilft. Er liefert Entscheidungsunterstützung, automatisiert Routineuntersuchungen und präsentiert hoch‑vertrauenswürdige Alarme zur menschlichen Prüfung.

How do AI systems detect threats in real time?

KI‑Systeme nehmen Telemetrie von Endpoints, Netzwerk und Cloud auf und wenden Modelle an, um Anomalien zu erkennen, die auf Kompromittierung hinweisen. Sie bewerten Ereignisse, gruppieren zusammenhängende Aktivitäten und lösen Echtzeit‑Alarme aus, damit Teams schnell reagieren können.

Can AI reduce mean time to detect (MTTD)?

Ja. KI beschleunigt die Triage, indem sie Alarme gruppiert, Beweise zusammenfasst und Playbook‑Schritte vorschlägt, was das MTTD senkt. Teams müssen jedoch Outputs validieren, um Automationsbias und False Positives zu vermeiden.

What is XDR and how does it use AI?

XDR steht für Extended Detection and Response und vereinheitlicht Signale über Endpoint, Netzwerk, Cloud und E‑Mail. XDR‑Plattformen nutzen KI‑Agenten und Verhaltensmodelle, um Ereignisse zu korrelieren und Eindämmungsmaßnahmen vorzuschlagen.

Are AI recommendations always accurate?

Nein. Studien zeigen, dass KI‑Outputs Ungenauigkeiten und Sourcing‑Fehler enthalten können, daher müssen Organisationen Provenienz, Vertrauens‑Scores und menschliche Verifikation verlangen. Regelmäßige Audits und Validierung reduzieren das Risiko falscher Maßnahmen.

How do you prevent AI from leaking sensitive data?

Begrenzen Sie den Modellzugang, verwenden Sie Input/Output‑Filterung, bevorzugen Sie On‑Premises‑ oder Private‑Model‑Optionen für sensible Workloads und protokollieren Sie jede KI‑Aktion. Datenzugriffsrichtlinien und Aufbewahrungsregeln reduzieren ebenfalls das Leckrisiko.

What is automation bias and how does it affect security analysts?

Automationsbias tritt auf, wenn Analysten KI‑Outputs zu sehr vertrauen und unabhängige Verifikation vernachlässigen. Er kann dazu führen, dass Anomalien übersehen werden; Schulung, Vertrauensschwellen und verpflichtende Verifikationsschritte helfen, dem entgegenzuwirken.

How should organisations govern AI in security?

Governance sollte Pre‑Deployment‑Tests, kontinuierliches Monitoring, Erklärbarkeit, Provenienz‑Checks und gestaffelte Rollouts umfassen. Stimmen Sie diese Kontrollen mit regulatorischen Anforderungen wie der DSGVO und internen Compliance‑Frameworks ab.

Can AI help with email-related security and operations?

Ja. KI kann E‑Mail‑Triage automatisieren, Absicht klassifizieren, Kontext anhängen und Antworten entwerfen, während Prüfpfade erhalten bleiben. Tools, die Antworten in ERP‑ und Dokumentsysteme einbetten, können manuelle Nachschläge und Sicherheitsrisiken reduzieren. Für Beispiele zur E‑Mail‑Automatisierung in der Logistik siehe diese Ressource zur KI in der Frachtlogistikkommunikation KI in der Frachtlogistikkommunikation.

What are the first steps to deploy an AI assistant safely?

Starten Sie mit einem kleinen Pilotprojekt, definieren Sie KPIs, führen Sie Modellvalidierung durch und verlangen Sie Human‑in‑the‑Loop‑Genehmigungen für Maßnahmen mit hoher Wirkung. Bereiten Sie auch Rollback‑Pläne vor und schulen Sie Analysten in Fehlerbehandlung und Verifikationsverfahren.

Ready to revolutionize your workplace?

Achieve more with your existing team with Virtual Workforce.