ciberseguridad con IA: cómo los asistentes de IA detectan amenazas en tiempo real

La IA ayuda a los EQUIPOS DE SEGURIDAD a detectar anomalías y amenazas a escala, y lo hace de forma continua. Por ejemplo, un asistente de IA puede supervisar registros, correlacionar telemetría y mostrar una alerta en tiempo real cuando los patrones coinciden con una firma conocida o una huella de comportamiento inusual. Esta capacidad importa porque el 77 % de las empresas están utilizando o explorando la IA en operaciones, lo que explica la fuerte adopción de IA en entornos empresariales estadística del 77 % de adopción. En la práctica, la ingestión de telemetría impulsada por IA, la extracción de características y la puntuación se ejecutan muchas veces más rápido que la revisión manual. El flujo típicamente comienza con telemetría → un modelo de IA → clasificación de alertas → respuesta. Un bucle simple podría verse así: los sensores alimentan datos de endpoints y de red, el modelo de IA puntúa las anomalías, el sistema genera una alerta y luego la contención activa un playbook. Esto es especialmente útil para la detección de amenazas en tiempo real, donde los minutos importan.

Las herramientas de ciberseguridad con IA ya impulsan muchas canalizaciones de detección y respuesta. Una revisión sobre la IA agentiva señala que la IA agentiva puede adaptarse a amenazas emergentes y actuar con autonomía cognitiva cuando está configurada para hacerlo IA agentiva en ciberseguridad. Por lo tanto, las plataformas que combinan líneas base de comportamiento con análisis en streaming reducen el tiempo de permanencia y destacan comportamientos desconocidos. En un caso de uso breve, el sistema detecta un patrón de movimiento lateral, emite una alerta, aísla el endpoint y escala el incidente al SOC para su revisión. Ese bucle de contención automatizada ahorra tiempo y reduce el error humano.

Los arquitectos de seguridad deben decidir qué automatizar y qué dejar para los analistas. Para la monitorización en tiempo real, la IA puede filtrar el ruido y priorizar las amenazas de manera que ayude a los equipos de seguridad a centrarse en incidentes de alto riesgo. Al mismo tiempo, los equipos deben exigir procedencia y puntuaciones de confianza para cada recomendación, porque los estudios muestran que las salidas de la IA pueden incluir inexactitudes y fallos de origen que importan en un contexto de seguridad estudio sobre fallos de origen. Además, los proveedores ahora ofrecen plataformas de ciberseguridad potenciadas por IA que se integran con SIEM, EDR y flujos en la nube, permitiendo un flujo rápido de detección y respuesta mientras mantienen a los humanos en el bucle para decisiones críticas.

Para las organizaciones que manejan una gran carga de correos electrónicos, también existen aplicaciones operativas de IA. Por ejemplo, virtualworkforce.ai utiliza agentes de IA para automatizar los ciclos de vida del correo electrónico para los equipos de operaciones, enrutar mensajes y adjuntar contexto a las escalaciones. Eso reduce el tiempo perdido en la triaje y ayuda a los equipos a mantener una postura de seguridad más sólida en las comunicaciones. En resumen, la ciberseguridad con IA en acción tanto detecta amenazas en tiempo real como ayuda a optimizar la sobrecarga operativa que de otro modo podría distraer al personal del SOC.

operaciones de seguridad: uso de asistentes de IA para acelerar la detección y la remediación

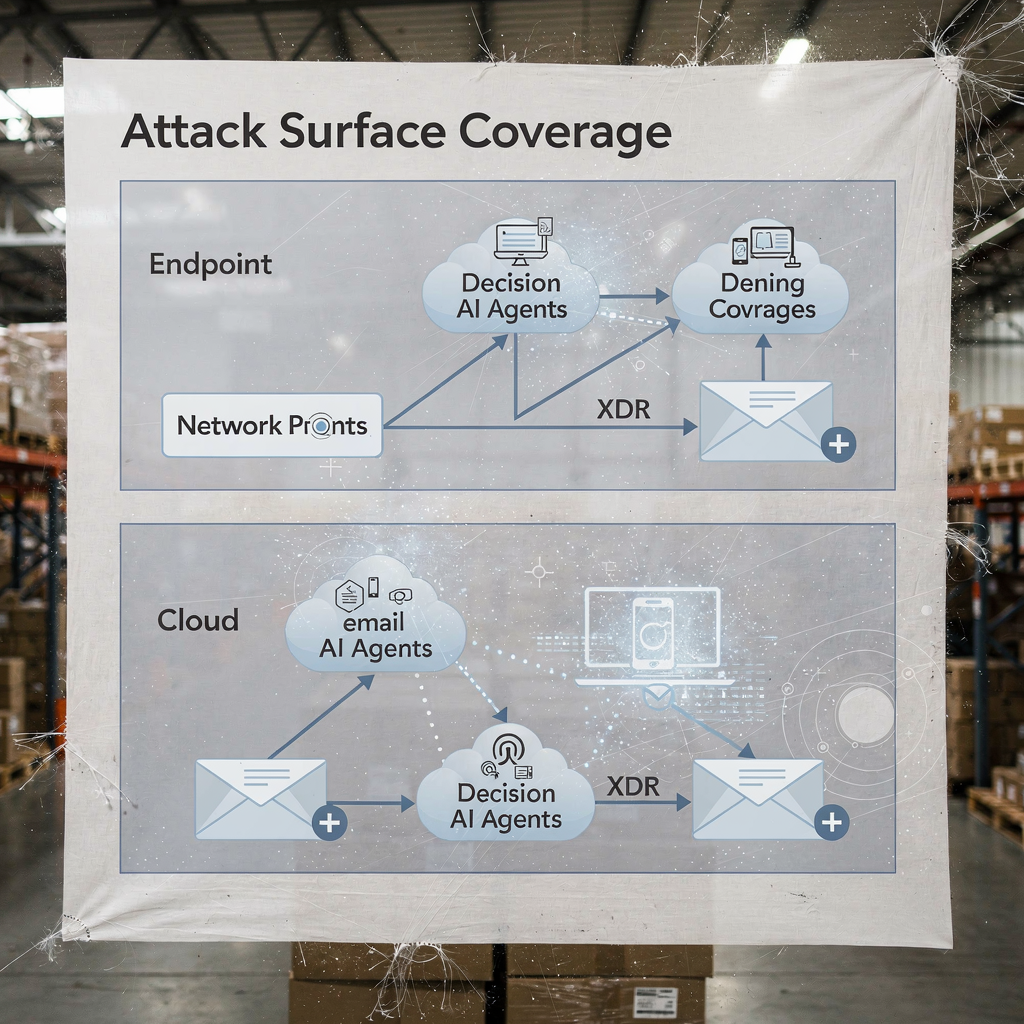

Las operaciones de seguridad dependen de flujos de trabajo rápidos y repetibles. La IA puede automatizar líneas de tiempo forenses, ejecutar playbooks y acelerar la remediación mientras el SOC mantiene el control. Por ejemplo, las integraciones entre XDR y SOAR permiten que un motor de sugerencias impulsado por IA proponga pasos de contención, y luego un ingeniero puede aprobarlos o anularlos. Esta mezcla de automatización y supervisión humana reduce el tiempo medio de detección y el tiempo medio de remediación. De hecho, la automatización reduce la carga de los analistas y puede disminuir los falsos positivos cuando las correlaciones XDR filtran señales ruidosas.

Los casos de uso muestran beneficios prácticos. Un modelo de IA puede analizar miles de alertas, agrupar incidentes similares y generar un breve resumen para un analista. Luego el analista decide si escalar. Para casos rutinarios de phishing, el sistema puede poner en cuarentena mensajes y marcar endpoints afectados, y luego el SOC revisa la acción automatizada. Este enfoque ayuda a los equipos SOC a centrarse en investigaciones que requieren juicio humano. Además, la automatización de la recopilación de pruebas y la construcción de líneas de tiempo acelera las investigaciones y reduce el riesgo de indicadores perdidos.

Los equipos deben seguir una lista de verificación de gestión del cambio antes de habilitar acciones automáticas. Primero, defina umbrales y puntuaciones de confianza. Segundo, mapee los playbooks a roles y aprobaciones. Tercero, implemente monitorización y retrocesos. Cuarto, registre cada paso automatizado para auditoría. Estos pasos ayudan a salvaguardar el entorno y mantener el cumplimiento. Un panel práctico muestra sugerencias de IA con anulaciones claras; esto agiliza el flujo de trabajo y preserva la responsabilidad.

Las métricas a rastrear incluyen alertas triajeadas por hora, tasa de falsos positivos y tiempo hasta la contención. Estos KPI demuestran mejoras mientras mantienen a los equipos responsables. Además, el SOC debería ejecutar comprobaciones periódicas de red-team y simulacros de incidentes para validar el modelo de IA y reducir el sesgo de automatización entre los analistas. La investigación indica que el sesgo de automatización afecta a una gran parte de los profesionales de seguridad, por lo que los pasos de verificación obligatorios son importantes factores humanos y sesgo de automatización. Finalmente, los equipos deben documentar cuándo el sistema usa IA para escalar automáticamente y cuándo espera la aprobación humana. Esta política clara ayuda tanto a los CISOs como a los respondedores en primera línea.

Cuando sus operaciones incluyen cargas de correo electrónico intensas, considere combinar la automatización de seguridad con plataformas de automatización de correo. virtualworkforce.ai ayuda a los equipos a enrutar y resolver correos operativos, reduciendo contextos ruidosos que de otro modo desperdician tiempo del SOC. Para obtener más información sobre la automatización de correos logísticos y la escala de flujos operativos, vea este recurso sobre correspondencia logística automatizada correspondencia logística automatizada.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

xdr y darktrace: ejemplos de IA agentiva en detección ampliada

Las plataformas de detección y respuesta ampliadas unifican señales entre endpoint, red, nube y correo electrónico. XDR correlaciona estas fuentes de telemetría y aplica modelos para revelar rutas de ataque complejas. Darktrace ofrece modelado de comportamiento y funciones de IA agentiva que se adaptan a líneas base cambiantes. En actualizaciones recientes de producto, Darktrace enfatizó la forense autónoma y las respuestas adaptativas, donde la plataforma puede tomar acciones de contención y generar razonamientos legibles por humanos para esos pasos. Este enfoque brinda a los equipos un camino más rápido para la detección y respuesta tanto a amenazas conocidas como novedosas.

Un escenario típico comienza con un comportamiento anómalo en un endpoint que no coincide con una firma conocida. XDR correlaciona esa acción con flujos de red inusuales, y la plataforma señala movimiento lateral. Luego, una acción de contención aísla el endpoint, mientras la forense automatizada captura artefactos. Los ejemplos de IA de Darktrace muestran cómo el aprendizaje automático puede mapear las acciones de un atacante a través de dispositivos y luego sugerir una respuesta que aísle la superficie de ataque. Esa secuencia ayuda a defender contra ransomware y propagación lateral.

La integración práctica requiere una lista de verificación. Primero, asegúrese de que su XDR se conecte con SIEM y SOAR para el enriquecimiento de eventos. Segundo, mapee playbooks de respuesta para acciones automáticas frente a manuales. Tercero, configure la plataforma para exportar contexto a sistemas de ticketing y correo, de modo que los equipos SOC conserven la trazabilidad de extremo a extremo. Cuarto, pruebe las transferencias EDR-a-XDR y confirme la fidelidad de la telemetría. Un diagrama por capas de la cobertura de XDR y los puntos de decisión de IA aclara quién actúa y cuándo.

Los beneficios de XDR se extienden a la seguridad de la nube y al correo electrónico. La plataforma combina telemetría de endpoints, flujos de red e inteligencia de amenazas para crear una visión más amplia de la postura de seguridad empresarial. En implementaciones que involucran Darktrace, los equipos de seguridad pueden ver información sobre el comportamiento del atacante y opciones de contención rápidas. Aun así, los equipos deben validar las decisiones de la IA agentiva mediante auditorías y mantener un registro de cada paso ejecutado de forma autónoma para la gobernanza. Para organizaciones en logística y operaciones, integrar los conocimientos de XDR con la automatización de correo ayuda a mantener la continuidad mientras se trian las amenazas que llegan vía phishing o cuentas comprometidas. Vea cómo la IA puede escalar la comunicación de carga y preservar el contexto en mensajes operativos IA para la comunicación de agentes de carga.

analista: sesgo de automatización, límites de precisión y la IA como ayuda para la decisión

Los factores humanos moldean cómo los equipos adoptan la IA. El sesgo de automatización y el sesgo de confirmación pueden llevar a los analistas de seguridad a confiar en exceso en las salidas de la IA. Los estudios muestran que el sesgo de automatización afecta a una gran fracción de los profesionales, y los analistas deben aprender a tratar la IA como una ayuda para la decisión en lugar de un oráculo factores humanos en la ciberseguridad impulsada por IA. Además, la investigación encontró que muchas respuestas generadas por IA contienen inexactitudes y problemas de origen, lo cual es crítico para la respuesta a incidentes donde la confianza en los hechos importa fallos de origen de asistentes de IA. Por lo tanto, los líderes del SOC deben añadir pasos de verificación obligatorios y umbrales de confianza a cada recomendación automatizada.

La formación juega un papel importante. Los equipos deberían ejecutar simulacros de escenarios, realizar ejercicios de red-team y exigir a los analistas que validen las pruebas antes de cerrar un incidente. Un control práctico es presentar la procedencia de cada recomendación para que los analistas puedan rastrear las alertas hasta los registros sin procesar y los estados del modelo de IA. Además, introduzca procedimientos de manejo de errores que especifiquen qué hacer cuando el sistema muestra baja confianza u salidas inconsistentes. Este proceso reduce el riesgo y mantiene a los humanos implicados en el pensamiento crítico.

La transparencia también ayuda. Presentar un resumen de por qué surgió una sugerencia, las señales que la respaldaron y la versión del modelo que la generó construye confianza. Para trabajo analítico que utiliza resúmenes en lenguaje natural, etiquételos claramente para evitar la sobredependencia. Dado que la IA se usa ampliamente ahora, los equipos deben equilibrar velocidad con escrutinio. El uso de puntuaciones de confianza y la exigencia de la firma de un analista para las escalaciones reducen la automatización ciega.

Finalmente, protéjase contra la IA en la sombra en los equipos. La IA en la sombra ocurre cuando individuos usan herramientas genéricas de IA no autorizadas o servicios de genAI para obtener respuestas rápidas. Esta práctica puede filtrar datos sensibles e introducir lógica inconsistente en las investigaciones. Establezca herramientas genAI aprobadas y un flujo de trabajo seguro para cualquier consulta o llamada a modelos externos. Proporcione a los analistas una vía clara para escalar casos complejos. En resumen, la IA debe potenciar al analista, no reemplazar el juicio.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

vulnerabilidades y datos sensibles: la IA para monitorizar, defender y crear nuevos riesgos

La IA ayuda a encontrar vulnerabilidades y a defender datos sensibles, y sin embargo introduce riesgos de uso dual. En el lado defensivo, la IA para monitorizar registros y tráfico web puede detectar patrones que indican intentos de explotación de CVE y luego desencadenar la remediación para parchear o aislar cargas de trabajo afectadas. Al mismo tiempo, actores maliciosos pueden desplegar agentes de IA para automatizar el reconocimiento, crear phishing dirigido e incluso generar variantes de malware. Artículos sobre amenazas emergentes señalan el aumento de empleados de IA automatizados o maliciosos que pueden realizar ingeniería social interna amenaza de empleados de IA maliciosos. Esa dualidad eleva la importancia de cómo gestiona el acceso a datos sensibles.

Las preocupaciones de privacidad aparecen cuando la IA accede a registros que contienen PII o secretos operativos. Para protegerse contra filtraciones, haga cumplir políticas estrictas de acceso a datos, use filtrado de entrada/salida y prefiera implementaciones locales u opciones de modelo privado para cargas de trabajo de alta sensibilidad. Además, registre todas las acciones y consultas de la IA para poder reconstruir decisiones e identificar cualquier salida anómala de datos. Para los equipos que gestionan correos operativos, asegurar que las plataformas de automatización de correo apliquen anclaje de datos y gobernanza en ERP y fuentes documentales evita divulgaciones accidentales. Explore cómo la automatización de correos preserva el contexto y reduce búsquedas manuales en flujos logísticos automatización ERP de correos para logística.

Diseñe controles para detectar actividad maliciosa de IA. Monitorice volúmenes de consulta anómalos y patrones inusuales que puedan indicar una herramienta de descubrimiento automatizada o una canalización de exfiltración. Implemente limitadores y cuotas en consultas que acceden a grandes conjuntos de datos. Realice threat hunting asumiendo que los atacantes pueden aprovechar la IA generativa para crear phishing polimórfico y mensajes de ingeniería social plausibles a gran escala. Además, revise las salidas del modelo en busca de alucinaciones o afirmaciones no soportadas, porque los fallos de origen pueden engañar a los analistas y exponer sistemas a pasos de remediación incorrectos.

Finalmente, proteja los propios modelos. Los ataques de envenenamiento de modelos y envenenamiento de datos pueden sesgar los modelos de aprendizaje y reducir la precisión de la detección. La validación periódica del modelo y las verificaciones de procedencia de datos ayudan a detectar intentos de envenenamiento tempranamente. Mantenga versiones firmadas de los modelos y un plan de reversión para modelos comprometidos o degradados. En conjunto, estos pasos ayudan a defender los datos sensibles mientras permiten que la IA monitorice y proteja sistemas de forma eficaz.

seguridad de la IA y ciberseguridad proactiva: gobernanza, validación y IA en cada etapa

La gobernanza sigue siendo la base de una adopción segura de la IA. Implemente validación de modelos, pruebas continuas, explicabilidad y políticas de ciclo de vida antes de despliegues amplios. Exija comprobaciones de procedencia y origen, realice auditorías periódicas de precisión y utilice despliegues por fases con criterios de reversión. Estos controles se alinean con obligaciones regulatorias como el RGPD y la orientación de la UE sobre minimización de datos y transparencia. Además, incluya a los CISOs en las revisiones de gobernanza y exija playbooks de incidentes claros que cubran fallos del modelo.

Los pasos prácticos incluyen pruebas previas al despliegue, monitorización en tiempo de ejecución, playbooks de incidentes y criterios de reversión definidos. Por ejemplo, realice una simulación previa al despliegue que evalúe el modelo de IA frente a un corpus de prueba que incluya muestras maliciosas conocidas, tráfico ruidoso y entradas sensibles a la privacidad. Luego monitorice la deriva y la precisión en producción y programe auditorías mensuales. Use herramientas de explicabilidad para proporcionar a los analistas la razón detrás de decisiones clave. Tales pasos hacen que las soluciones de ciberseguridad potenciadas por IA sean auditables y confiables.

Adopte una lista de verificación para el uso en producción: confirme controles de acceso, implemente saneamiento de entradas, establezca políticas de retención y exija registros firmados de cada acción automatizada. Rastree KPIs como tasa de falsos positivos, tiempo hasta la contención y porcentaje de alertas resueltas con supervisión humana. Además, prepare una hoja de ruta para los primeros 90 días de cualquier despliegue de IA: métricas de referencia, pruebas en sandbox, habilitación por fases, formación y aprobación de gobernanza. Este enfoque ayuda a ofrecer una ciberseguridad proactiva que puede detectar amenazas conocidas y desconocidas.

Finalmente, equilibre la innovación con la precaución. La IA avanzada y el deep learning aportan nuevas capacidades de IA a las herramientas defensivas, pero la gobernanza mantiene esas capacidades alineadas con su postura de seguridad. Si necesita escalar operaciones sin añadir plantilla, explore la automatización de flujos repetitivos como la gestión operativa de correos; virtualworkforce.ai muestra cómo los agentes de IA pueden reducir el tiempo de gestión y mantener el contexto adjunto a las escalaciones, lo que apoya tanto la productividad como los objetivos de seguridad cómo escalar operaciones logísticas sin contratar personal. Empiece pequeño, mida el impacto e itere con salvaguardas claras.

FAQ

¿Qué es un asistente de IA en ciberseguridad?

Un asistente de IA en ciberseguridad es un agente automatizado que ayuda a monitorizar, analizar y priorizar eventos de seguridad. Proporciona soporte para la toma de decisiones, automatiza tareas investigativas rutinarias y muestra alertas de alta confianza para la revisión humana.

¿Cómo detectan las IA las amenazas en tiempo real?

Los sistemas de IA ingieren telemetría de endpoints, red y nube, luego aplican modelos para detectar anomalías que indican compromiso. Puntuán eventos, agrupan actividad relacionada y generan alertas en tiempo real para que los equipos puedan actuar rápidamente.

¿Puede la IA reducir el tiempo medio de detección (MTTD)?

Sí. La IA acelera la triaje agrupando alertas, resumiendo pruebas y sugiriendo pasos de playbook, lo que reduce el MTTD. Sin embargo, los equipos deben validar las salidas para evitar sesgo de automatización y falsos positivos.

¿Qué es XDR y cómo usa la IA?

XDR significa detección y respuesta ampliadas y unifica señales entre endpoint, red, nube y correo electrónico. Las plataformas XDR usan agentes de IA y modelos de comportamiento para correlacionar eventos y sugerir acciones de contención.

¿Son siempre precisas las recomendaciones de la IA?

No. Los estudios muestran que las salidas de la IA pueden incluir inexactitudes y fallos de origen, por lo que las organizaciones deben exigir procedencia, puntuaciones de confianza y verificación humana. Auditorías y validaciones regulares reducen el riesgo de acciones equivocadas.

¿Cómo se evita que la IA filtre datos sensibles?

Limite el acceso al modelo, use filtrado de entrada/salida, prefiera opciones locales o modelos privados para cargas de trabajo sensibles y registre cada acción de la IA. Las políticas de acceso a datos y las reglas de retención también reducen el riesgo de filtración.

¿Qué es el sesgo de automatización y cómo afecta a los analistas de seguridad?

El sesgo de automatización ocurre cuando los analistas confían en exceso en las salidas de la IA y descuidan la verificación independiente. Puede causar anomalías perdidas; la formación, los umbrales de confianza y los pasos de verificación obligatorios ayudan a mitigarlo.

¿Cómo deben gobernar las organizaciones la IA en seguridad?

La gobernanza debe incluir pruebas previas al despliegue, monitorización continua, explicabilidad, comprobaciones de procedencia y despliegues por fases. Alinee estos controles con requisitos regulatorios como el RGPD y marcos internos de cumplimiento.

¿Puede la IA ayudar con la seguridad y las operaciones relacionadas con el correo?

Sí. La IA puede automatizar la triaje de correos, clasificar la intención, adjuntar contexto y redactar respuestas mientras preserva registros de auditoría. Las herramientas que anclan respuestas en ERP y sistemas documentales pueden reducir búsquedas manuales y exposiciones de seguridad. Para ejemplos en automatización de correos logísticos, vea este recurso sobre IA en la comunicación de logística IA en la comunicación logística de carga.

¿Cuáles son los primeros pasos para desplegar un asistente de IA de forma segura?

Comience con un piloto pequeño, defina KPIs, realice validación de modelos y exija aprobaciones humanos-en-el-bucle para acciones de alto impacto. Además, prepare planes de reversión y forme a los analistas en manejo de errores y procedimientos de verificación.

Ready to revolutionize your workplace?

Achieve more with your existing team with Virtual Workforce.