ai cybersecurity: jak asystenci AI wykrywają zagrożenia w czasie rzeczywistym

AI pomaga ZESPOŁOM BEZPIECZEŃSTWA wykrywać anomalie i zagrożenia na dużą skalę, i robi to ciągle. Na przykład asystent AI może monitorować logi, korelować telemetrię i wygenerować alert w czasie rzeczywistym, gdy wzorce pasują do znanej sygnatury lub nietypowego odcisku zachowania. Ta zdolność ma znaczenie, ponieważ 77% firm albo korzysta z AI, albo ją bada w operacjach, co tłumaczy szerokie przyjęcie AI w środowiskach korporacyjnych statystyka przyjęcia 77%. W praktyce wczytywanie telemetrii napędzane przez AI, ekstrakcja cech i ocenianie działają wielokrotnie szybciej niż ręczny przegląd. Przepływ zwykle zaczyna się od telemetry → model AI → triage alertu → reakcja. Prosta pętla może wyglądać tak: sensory dostarczają dane endpointów i sieci, model AI ocenia anomalie, system podnosi alert, a następnie izolacja wyzwala playbook. To jest szczególnie przydatne przy wykrywaniu zagrożeń w czasie rzeczywistym, gdzie liczą się minuty.

Narzędzia AI w cyberbezpieczeństwie już napędzają wiele pipeline’ów wykrywania i reagowania. Przegląd agentowej AI zauważa, że agentowa AI może dostosowywać się do pojawiających się zagrożeń i działać z kognitywną autonomią, gdy jest tak skonfigurowana agentowa AI w cyberbezpieczeństwie. Dlatego platformy, które łączą behawioralne bazy odniesienia z analizą strumieniową, skracają czas pozostawania atakującego w systemie i uwidaczniają nieznane zachowania. W krótkim studium przypadku system wykrywa wzorzec ruchu bocznego, zgłasza alert, izoluje punkt końcowy i eskaluje incydent do SOC do przeglądu. Ta zautomatyzowana pętla izolacji oszczędza czas i redukuje błędy ludzkie.

Architekci bezpieczeństwa muszą zdecydować, co automatyzować, a co pozostawić analitykom. W monitoringu w czasie rzeczywistym AI potrafi odfiltrowywać szum i priorytetyzować zagrożenia w sposób, który pomaga zespołom bezpieczeństwa skupić się na incydentach wysokiego ryzyka. Równocześnie zespoły powinny wymagać pochodzenia (provenance) i ocen pewności dla każdej rekomendacji, ponieważ badania pokazują, że wyniki AI mogą zawierać nieścisłości i błędy sourcingu, które mają znaczenie w kontekście bezpieczeństwa badanie błędów sourcingu. Ponadto dostawcy oferują teraz platformy cyberbezpieczeństwa zasilane AI, które integrują się z SIEM, EDR i źródłami chmurowymi, umożliwiając szybki przepływ wykrywania i reakcji przy jednoczesnym utrzymaniu ludzi w pętli dla decyzji krytycznych.

Dla organizacji obsługujących dużą liczbę wiadomości e-mail istnieją też operacyjne zastosowania AI. Na przykład virtualworkforce.ai używa agentów AI do automatyzacji cykli życia wiadomości e-mail dla zespołów operacyjnych, kierowania wiadomości i dołączania kontekstu do eskalacji. To zmniejsza czas tracony na triage i pomaga zespołom utrzymać silniejszą postawę bezpieczeństwa w komunikacji. Krótko mówiąc, ai cybersecurity w praktyce zarówno wykrywa zagrożenia w czasie rzeczywistym, jak i upraszcza obciążenie operacyjne, które w przeciwnym razie mogłoby rozpraszać personel SOC.

security operations: using ai assistant to speed detection and remediation

Operacje bezpieczeństwa opierają się na szybkich, powtarzalnych przepływach pracy. AI może automatyzować linie czasu dochodzeń, uruchamiać playbooki i przyspieszać remediację, przy jednoczesnym zachowaniu kontroli przez SOC. Na przykład integracje między XDR i SOAR pozwalają silnikowi sugestii zasilanemu AI proponować kroki izolacji, a inżynier może je zatwierdzić lub nadpisać. To połączenie automatyzacji i nadzoru ludzkiego skraca średni czas wykrycia i średni czas remediacji. W rzeczywistości automatyzacja zmniejsza obciążenie analityków i może obniżać liczbę fałszywych pozytywów, gdy korelacje XDR filtrują głośne sygnały.

Przypadki użycia pokazują praktyczne korzyści. Model AI może przeanalizować tysiące alertów, pogrupować podobne incydenty i wygenerować krótkie podsumowanie dla analityka. Następnie analityk decyduje, czy eskalować. W rutynowych przypadkach phishingowych system może poddać kwarantannie wiadomości i oznaczyć dotknięte endpointy, po czym SOC przegląda zautomatyzowane działanie. Takie podejście pozwala zespołom SOC skupić się na śledztwach wymagających ludzkiego osądu. Również automatyzacja zbierania dowodów i budowy linii czasu przyspiesza dochodzenia i zmniejsza ryzyko przeoczenia wskaźników.

Zespoły powinny stosować checklistę zarządzania zmianą przed włączeniem automatycznych działań. Po pierwsze, zdefiniuj progi i oceny pewności. Po drugie, odwzoruj playbooki na role i zatwierdzenia. Po trzecie, wdroż monitorowanie i mechanizmy cofania. Po czwarte, loguj każdy zautomatyzowany krok dla audytowalności. Te kroki pomagają zabezpieczyć środowisko i utrzymać zgodność. Praktyczny dashboard pokazuje sugestie AI z wyraźnymi możliwością nadpisania; to upraszcza przepływ pracy i zachowuje rozliczalność.

Metryki do śledzenia obejmują alerty poddane triage na godzinę, wskaźnik fałszywych pozytywów oraz czas do izolacji. Te KPI pokazują poprawę przy jednoczesnym utrzymaniu odpowiedzialności zespołów. Ponadto SOC powinien przeprowadzać okresowe testy red-team i symulowane incydenty, aby walidować model AI i zmniejszać uprzedzenia automatyzacji wśród analityków. Badania wskazują, że uprzedzenie automatyzacji wpływa na dużą część profesjonalistów ds. bezpieczeństwa, dlatego obowiązkowe kroki weryfikacyjne mają znaczenie czynniki ludzkie i uprzedzenie automatyzacji. W końcu zespoły powinny dokumentować, kiedy system używa AI do automatycznej eskalacji, a kiedy czeka na zatwierdzenie człowieka. Jasna polityka pomaga zarówno CISO, jak i osobom na pierwszej linii.

Gdy Twoje operacje obejmują intensywny ruch e-mailowy, rozważ połączenie automatyzacji bezpieczeństwa z platformami automatyzacji e-maili. virtualworkforce.ai pomaga zespołom kierować i rozwiązywać wiadomości operacyjne, redukując hałaśliwe konteksty, które w przeciwnym razie marnują czas SOC. Aby dowiedzieć się więcej o automatyzacji e-maili logistycznych i skalowaniu przepływów operacyjnych, zobacz to źródło o zautomatyzowanej korespondencji logistycznej.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

xdr and darktrace: agentic ai examples in extended detection

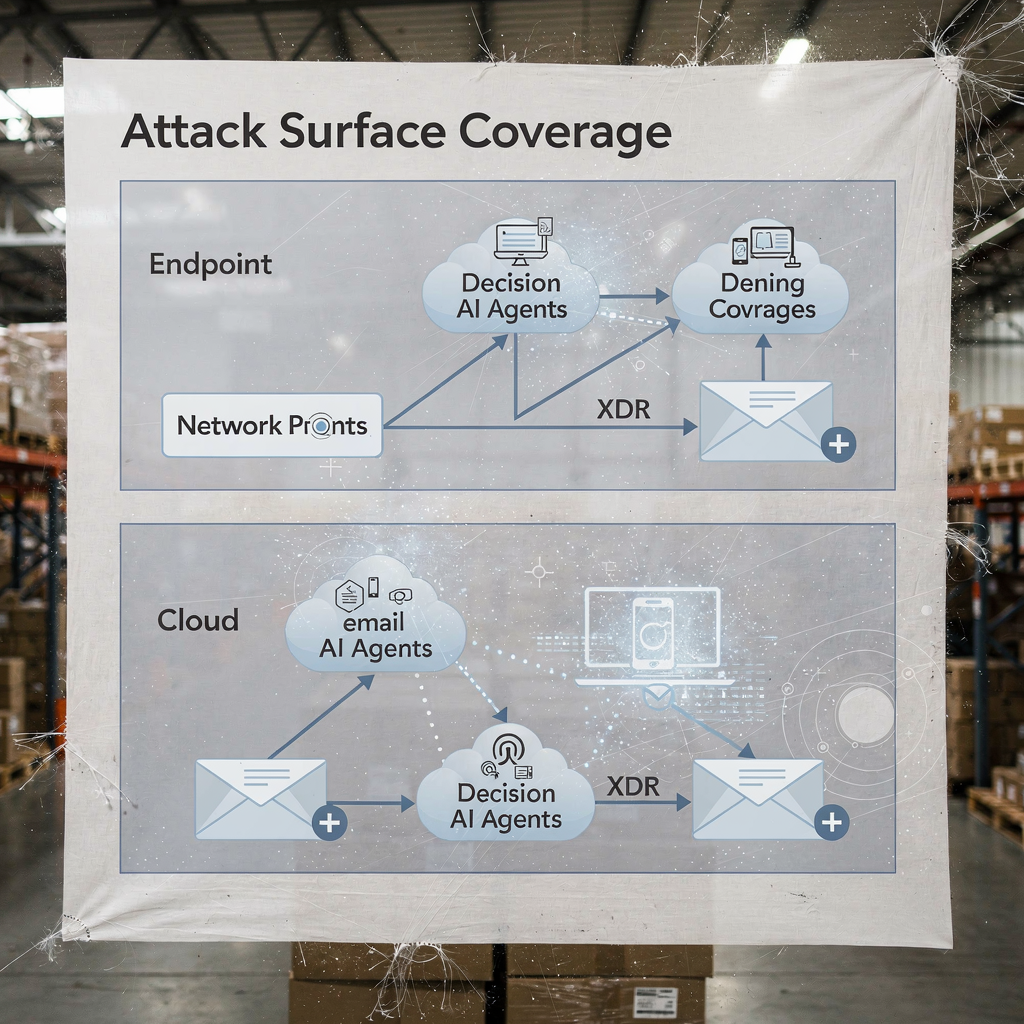

Platformy Extended Detection and Response jednoczą sygnały z endpointów, sieci, chmury i e-maili. XDR koreluje te źródła telemetrii i stosuje modele, aby ujawnić złożone ścieżki ataku. Darktrace oferuje modelowanie behawioralne i funkcje agentowej AI, które dostosowują się do zmieniających się baz odniesienia. W ostatnich aktualizacjach produktu Darktrace podkreślał autonomiczne dochodzenia i adaptacyjne reakcje, gdzie platforma może podjąć działania izolacyjne i wygenerować czytelne dla człowieka uzasadnienie tych kroków. Takie podejście daje zespołom szybszą ścieżkę do wykrywania i reagowania zarówno na znane, jak i nowe zagrożenia.

Typowy scenariusz zaczyna się od anomalnego zachowania endpointu, które nie pasuje do znanej sygnatury. XDR koreluje tę akcję z nietypowymi przepływami sieciowymi, a platforma flaguje ruch boczny. Następnie działanie izolacyjne odcina endpoint, podczas gdy zautomatyzowane dochodzenia przechwytują artefakty. Przykłady AI Darktrace pokazują, jak uczenie maszynowe może mapować działania atakującego na urządzeniach, a potem sugerować odpowiedź, która izoluje powierzchnię ataku. Ta sekwencja pomaga bronić przed ransomware i propagacją boczną.

Praktyczna integracja wymaga checklisty. Po pierwsze, upewnij się, że Twój XDR łączy się z SIEM i SOAR dla wzbogacania zdarzeń. Po drugie, odwzoruj playbooki reakcji dla działań automatycznych i manualnych. Po trzecie, skonfiguruj platformę do eksportowania kontekstu do systemu ticketowego i e-maili, aby zespoły SOC zachowały pełną śledzialność. Po czwarte, testuj przekazania EDR do XDR i potwierdź wierność telemetrii. Warstwowy diagram pokrycia XDR i punktów decyzyjnych AI wyjaśnia, kto działa i kiedy.

Korzyści XDR rozszerzają się na bezpieczeństwo chmury i ścieżki bezpieczeństwa e-maili. Platforma łączy telemetrię endpointów, przepływy sieciowe i wywiad o zagrożeniach, aby stworzyć szerszy obraz postawy bezpieczeństwa przedsiębiorstwa. W wdrożeniach z udziałem Darktrace zespoły bezpieczeństwa mogą zobaczyć wnikliwe informacje o zachowaniu atakującego i szybkie opcje izolacji. Mimo to zespoły powinny walidować decyzje agentowej AI poprzez audyty i prowadzić rejestr każdego autonomicznie wykonanego kroku dla celów zarządzania. Dla organizacji w logistyce i operacjach integracja wglądów XDR z automatyzacją e-maili pomaga utrzymać ciągłość, jednocześnie triagingując zagrożenia, które przychodzą poprzez phishing lub przejęte konta. Zobacz, jak AI może skalować komunikację frachtową i zachować kontekst w wiadomościach operacyjnych AI dla komunikacji ze spedytorami.

analyst: automation bias, accuracy limits and ai is used as decision aid

Czynniki ludzkie kształtują sposób, w jaki zespoły przyjmują AI. Uprzedzenie automatyzacji i uprzedzenie potwierdzenia mogą prowadzić analityków bezpieczeństwa do nadmiernego zaufania wyjściom AI. Badania pokazują, że uprzedzenie automatyzacji wpływa na dużą część praktyków, i analitycy muszą nauczyć się traktować AI jako narzędzie wspomagające decyzje, a nie jako wyrocznię czynniki ludzkie w AI-driven cybersecurity. Ponadto badania wykazały, że wiele odpowiedzi generowanych przez AI zawiera nieścisłości i problemy z sourcingiem, co jest krytyczne dla reagowania na incydenty, gdzie zaufanie do faktów ma znaczenie błędy sourcingu asystentów AI. Dlatego liderzy SOC powinni dodać obowiązkowe kroki weryfikacji i progi pewności do każdej zautomatyzowanej rekomendacji.

Szkolenie odgrywa dużą rolę. Zespoły powinny przeprowadzać ćwiczenia scenariuszowe, testy red-team i wymagać od analityków weryfikacji dowodów przed zamknięciem incydentu. Praktycznym kontrolnym rozwiązaniem jest przedstawienie pochodzenia dla każdej rekomendacji, aby analitycy mogli odtworzyć alerty z surowych logów i stanów modelu AI. Ponadto wprowadź procedury obsługi błędów, które określają, co robić, gdy system pokazuje niską pewność lub niespójne wyjścia. Ten proces zmniejsza ryzyko i utrzymuje ludzi aktywnych w krytycznym myśleniu.

Przejrzystość także pomaga. Prezentowanie podsumowania, dlaczego pojawiła się sugestia, sygnałów, które ją wspierały, oraz wersji modelu, który ją wygenerował, buduje zaufanie. Dla pracy analitycznej używającej tekstowych podsumowań, oznaczaj je wyraźnie, aby uniknąć nadmiernego polegania. Ponieważ AI jest dziś powszechnie stosowane, zespoły muszą równoważyć szybkość z weryfikacją. Użycie ocen pewności i wymóg podpisu analityka dla eskalacji zmniejsza ślepą automatyzację.

Wreszcie, chroń przed shadow AI w zespołach. Shadow AI występuje, gdy osoby używają nieautoryzowanych narzędzi genAI lub usług gen AI w celu szybkich odpowiedzi. Ta praktyka może wyciekać dane wrażliwe i wprowadzać niespójną logikę do dochodzeń. Ustanów zatwierdzone narzędzia genAI i bezpieczny przepływ pracy dla każdego zewnętrznego zapytania lub wywołania modelu. Zapewnij analitykom jasną ścieżkę eskalacji dla skomplikowanych spraw. Krótko mówiąc, AI powinno wzmacniać analityka, a nie zastępować osąd.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

vulnerability and sensitive data: ai to monitor, defend and create new risks

AI pomaga znajdować luki i bronić danych wrażliwych, a równocześnie wprowadza ryzyka podwójnego zastosowania. Po stronie defensywnej AI monitorująca logi i ruch sieciowy może wykrywać wzorce wskazujące na próby wykorzystania CVE, a następnie wyzwalać remediację w celu załatania lub izolacji dotkniętych obciążeń. Jednocześnie złośliwi aktorzy mogą wdrażać agentów AI do automatyzacji rozpoznania, tworzenia celowanych phishingów, a nawet generowania wariantów złośliwego oprogramowania. Artykuły o pojawiających się zagrożeniach odnotowują wzrost zautomatyzowanych lub złośliwych „pracowników AI”, którzy mogą wykonywać działania socjotechniczne przypominające insiderów zagrożenie złośliwego pracownika AI. Ta dualność podnosi stawkę dla zarządzania dostępem do danych wrażliwych.

Obawy dotyczące prywatności pojawiają się, gdy AI uzyskuje dostęp do logów zawierających dane osobowe (PII) lub tajemnice operacyjne. Aby zabezpieczyć się przed wyciekami, egzekwuj ścisłe polityki dostępu do danych, stosuj filtrowanie wejścia/wyjścia i preferuj wdrożenia on-premises lub prywatne modele dla obciążeń o wysokiej wrażliwości. Również loguj wszystkie działania i zapytania AI, aby móc odtworzyć decyzje i wykryć anomalne wycieki danych. Dla zespołów obsługujących e-maile operacyjne upewnienie się, że platformy automatyzacji e-maili stosują ugruntowanie danych i zarządzanie w ERP i źródłach dokumentów, zapobiega przypadkowemu ujawnieniu. Zbadaj, jak automatyzacja e-maili zachowuje kontekst i redukuje ręczne wyszukiwania w przepływach logistycznych automatyzacja e-maili ERP dla logistyki.

Zaprojektuj kontrole wykrywające złośliwą aktywność AI. Monitoruj anormalne wolumeny zapytań i nietypowe wzorce, które mogą wskazywać na zautomatyzowane narzędzie rozpoznawcze lub pipeline eksfiltracji. Wprowadź ograniczenia i limity zapytań, które uzyskują dostęp do dużych zbiorów danych. Prowadź threat hunting zakładając, że atakujący mogą wykorzystywać generatywną AI do tworzenia polimorficznych phishingów i wiarygodnych wiadomości socjotechnicznych na skalę. Również przeglądaj wyjścia modeli pod kątem halucynacji lub niepotwierdzonych twierdzeń, ponieważ błędy sourcingu mogą wprowadzić analityków w błąd i narazić systemy na niewłaściwe działania naprawcze.

Wreszcie, chroń same modele. Ataki typu model poisoning i data poisoning mogą wypaczyć modele uczące się i obniżyć dokładność wykrywania. Regularna walidacja modeli i kontrole pochodzenia danych pomagają wykryć próby zatruwania wcześnie. Utrzymuj podpisane wersje modeli i plan rollbacku dla skompromitowanych lub zdegradowanych modeli. Razem te kroki pomagają bronić danych wrażliwych, jednocześnie umożliwiając AI monitorowanie i ochronę systemów skutecznie.

ai security and proactive cybersecurity: governance, validation and ai at every stage

Governance pozostaje fundamentem bezpiecznego przyjęcia AI. Wdroż modelowe walidacje, ciągłe testy, wyjaśnialność i polityki cyklu życia przed szerokimi rolloutami. Wymagaj sprawdzeń pochodzenia i źródeł, przeprowadzaj okresowe audyty dokładności i stosuj stopniowe wdrożenia z kryteriami cofania. Te kontrole zgodne są z obowiązkami regulacyjnymi, takimi jak RODO i wytyczne UE dotyczące minimalizacji danych i przejrzystości. Również włącz CISO w przeglądy governance i wymagaj jasnych playbooków incydentowych obejmujących awarie modeli.

Praktyczne kroki obejmują testy przedwdrożeniowe, monitoring w czasie działania, playbooki incydentowe i zdefiniowane kryteria rollbacku. Na przykład przeprowadź suchy bieg przed uruchomieniem, który sprawdza model AI na korpusie testowym obejmującym znane złośliwe próbki, hałaśliwy ruch i wpisy wrażliwe prywatności. Następnie monitoruj dryft i dokładność w produkcji oraz planuj comiesięczne audyty. Używaj narzędzi wyjaśnialności, aby dostarczyć analitykom racjonalizację kluczowych decyzji. Takie kroki sprawiają, że rozwiązania cyberbezpieczeństwa zasilane AI są audytowalne i godne zaufania.

Przyjmij checklistę do użycia w produkcji: potwierdź kontrolę dostępu, wdroż sanitizację wejścia, ustaw zasady retencji i wymagaj podpisanych logów każdego zautomatyzowanego działania. Śledź KPI takie jak wskaźnik fałszywych pozytywów, czas do izolacji i procent alertów rozwiązanych z nadzorem człowieka. Przygotuj też plan na pierwsze 90 dni każdej implementacji AI: metryki bazowe, testy w piaskownicy, stopniowe włączanie, szkolenia i podpisanie governance. Takie podejście pomaga dostarczać proaktywne cyberbezpieczeństwo, które może wykrywać zarówno znane, jak i nieznane zagrożenia.

Wreszcie, wyważ innowację z ostrożnością. Zaawansowane AI i deep learning przynoszą nowe możliwości obrońcom, ale governance utrzymuje te możliwości zgodne z Twoją postawą bezpieczeństwa. Jeśli musisz skalować operacje bez zwiększania zatrudnienia, rozważ automatyzację powtarzalnych przepływów, takich jak obsługa e-maili operacyjnych; virtualworkforce.ai pokazuje, jak agenci AI mogą skrócić czas obsługi i zachować kontekst przy eskalacjach, co wspiera zarówno produktywność, jak i cele bezpieczeństwa jak skalować operacje logistyczne bez zatrudniania. Zacznij od małych kroków, mierz wpływ i iteruj z jasnymi zabezpieczeniami.

FAQ

What is an AI assistant in cybersecurity?

Asystent AI w cyberbezpieczeństwie to zautomatyzowany agent, który pomaga monitorować, analizować i priorytetyzować zdarzenia bezpieczeństwa. Dostarcza wsparcia decyzyjnego, automatyzuje rutynowe zadania dochodzeniowe i uwidacznia alerty o wysokiej pewności do przeglądu przez człowieka.

How do AI systems detect threats in real time?

Systemy AI pobierają telemetrię z endpointów, sieci i chmury, a następnie stosują modele do wykrywania anomalii wskazujących na kompromitację. Ocenią zdarzenia, grupują powiązaną aktywność i generują alerty w czasie rzeczywistym, aby zespoły mogły szybko zareagować.

Can AI reduce mean time to detect (MTTD)?

Tak. AI przyspiesza triage, grupując alerty, podsumowując dowody i sugerując kroki z playbooka, co obniża MTTD. Jednak zespoły muszą weryfikować wyniki, aby uniknąć uprzedzenia automatyzacji i fałszywych pozytywów.

What is XDR and how does it use AI?

XDR oznacza extended detection and response i jednoczy sygnały z endpointów, sieci, chmury i e-maili. Platformy XDR używają agentów AI i modeli behawioralnych do korelowania zdarzeń i sugerowania działań izolacyjnych.

Are AI recommendations always accurate?

Nie. Badania pokazują, że wyjścia AI mogą zawierać nieścisłości i błędy sourcingu, dlatego organizacje muszą wymagać pochodzenia, ocen pewności i weryfikacji ludzkiej. Regularne audyty i walidacja zmniejszają ryzyko błędnych działań.

How do you prevent AI from leaking sensitive data?

Ogranicz dostęp do modeli, stosuj filtrowanie wejścia/wyjścia, preferuj opcje on-premises lub prywatne modele dla wrażliwych obciążeń i loguj każde działanie AI. Polityki dostępu do danych i zasady retencji również zmniejszają ryzyko wycieku.

What is automation bias and how does it affect security analysts?

Uprzedzenie automatyzacji występuje, gdy analitycy nadmiernie ufają wyjściom AI i pomijają niezależną weryfikację. Może to powodować przeoczenie anomalii; szkolenia, progi pewności i obowiązkowe kroki weryfikacji pomagają to złagodzić.

How should organisations govern AI in security?

Governance powinno obejmować testy przedwdrożeniowe, ciągłe monitorowanie, wyjaśnialność, kontrole pochodzenia i stopniowe wdrożenia. Dopasuj te kontrole do wymagań regulacyjnych, takich jak RODO, i wewnętrznych ram zgodności.

Can AI help with email-related security and operations?

Tak. AI może automatyzować triage e-maili, klasyfikować intencję, dołączać kontekst i tworzyć szkice odpowiedzi, jednocześnie zachowując ślady audytu. Narzędzia, które opierają odpowiedzi na systemach ERP i dokumentach, mogą zmniejszyć ręczne wyszukiwania i ryzyko bezpieczeństwa. Dla przykładów w automatyzacji e-maili logistycznych zobacz to źródło o AI w komunikacji frachtowej.

What are the first steps to deploy an AI assistant safely?

Zacznij od małego pilota, zdefiniuj KPI, przeprowadź walidację modelu i wymagaj zatwierdzeń człowieka dla działań o wysokim wpływie. Przygotuj też plany rollbacku i przeszkól analityków w procedurach obsługi błędów i weryfikacji.

Ready to revolutionize your workplace?

Achieve more with your existing team with Virtual Workforce.