ai cybersecurity: how ai assistants detect threats in real time

AI ajuda EQUIPES DE SEGURANÇA a detectar anomalias e ameaças em larga escala, e faz isso continuamente. Por exemplo, um assistente de IA pode monitorar logs, correlacionar telemetria e exibir um alerta em tempo real quando padrões correspondem a uma assinatura conhecida ou a uma impressão comportamental incomum. Essa capacidade é importante porque 77% das empresas estão usando ou explorando IA nas operações, o que explica a forte adoção de IA em ambientes empresariais estatística de adoção de 77%. Na prática, a ingestão de telemetria orientada por IA, extração de recursos e pontuação rodam muitas vezes mais rápido do que a revisão manual. O fluxo normalmente começa com telemetria → um modelo de IA → triagem de alertas → resposta. Um loop simples pode ser assim: sensores alimentam dados de endpoint e rede, o modelo de IA pontua anomalias, o sistema levanta um alerta e então a contenção aciona um playbook. Isso é especialmente útil para detecção de ameaças em tempo real, onde minutos fazem a diferença.

Ferramentas de cibersegurança com IA já alimentam muitos pipelines de detecção e resposta. Uma revisão sobre Agentic AI observa que a IA agentiva pode se adaptar a ameaças emergentes e agir com autonomia cognitiva quando configurada para isso IA agentiva em cibersegurança. Portanto, plataformas que combinam linhas de base comportamentais com análise em streaming reduzem o tempo de permanência e destacam comportamentos desconhecidos. Em um caso de uso curto, o sistema detecta um padrão de movimento lateral, emite um alerta, isola o endpoint e escala o incidente para o SOC para revisão. Esse loop de contenção automatizado economiza tempo e reduz o erro humano.

Arquitetos de segurança devem decidir o que automatizar e o que deixar para os analistas. Para monitoramento em tempo real, a IA pode filtrar ruído e priorizar ameaças de uma forma que ajuda as equipes de segurança a se concentrarem em incidentes de alto risco. Ao mesmo tempo, as equipes devem exigir proveniência e pontuações de confiança para cada recomendação, porque estudos mostram que saídas de IA podem incluir imprecisões e falhas de origem que importam em um contexto de segurança estudo sobre falhas de origem. Além disso, fornecedores agora oferecem plataformas de cibersegurança potenciadas por IA que se integram com SIEM, EDR e feeds de nuvem, permitindo um fluxo rápido de detecção e resposta enquanto mantêm humanos no ciclo para decisões críticas.

Para organizações que lidam com um alto volume de emails, existem aplicações operacionais de IA também. Por exemplo, virtualworkforce.ai usa agentes de IA para automatizar ciclos de vida de email para equipes de operações, direcionar mensagens e anexar contexto às escaladas. Isso reduz o tempo perdido na triagem e ajuda as equipes a manter uma postura de segurança mais forte nas comunicações. Em resumo, ai cybersecurity em ação tanto detecta ameaças em tempo real quanto ajuda a simplificar a sobrecarga operacional que poderia distrair o pessoal do SOC.

security operations: using ai assistant to speed detection and remediation

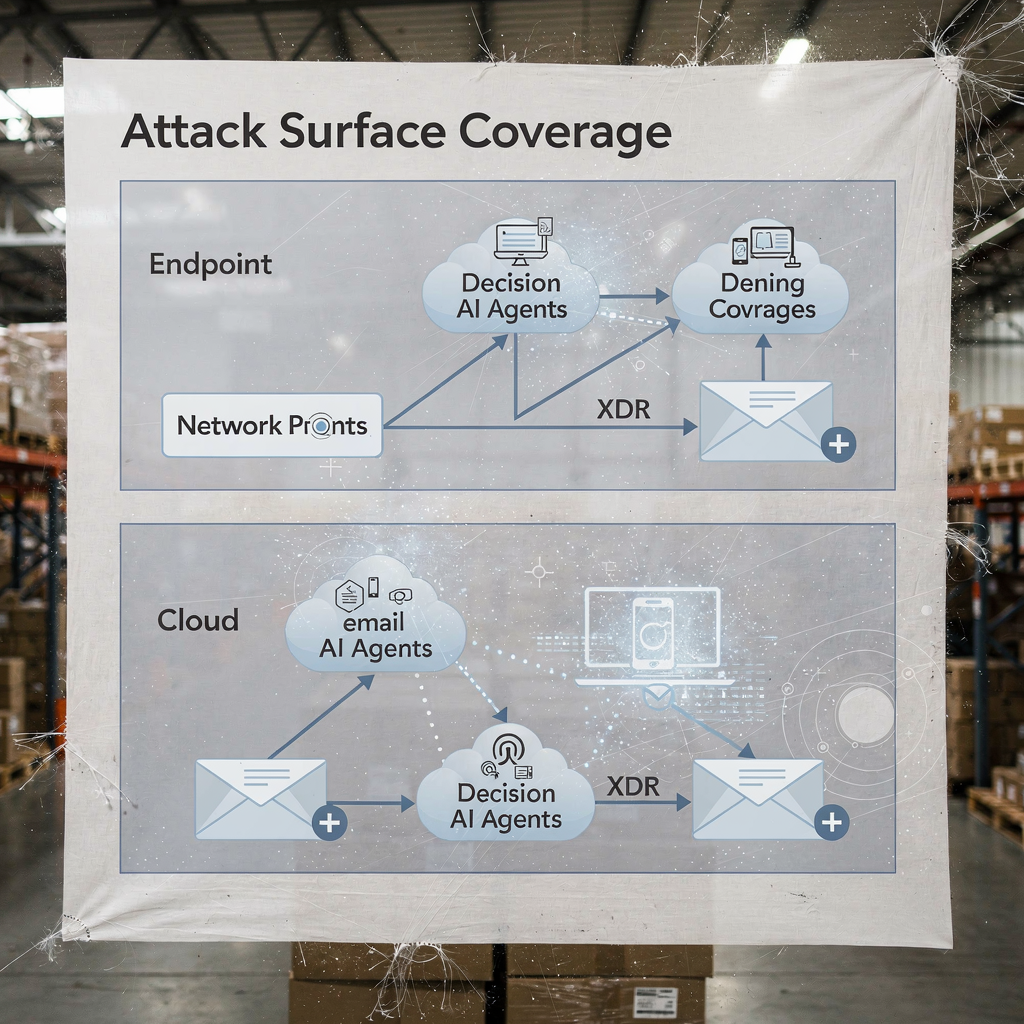

Operações de segurança dependem de fluxos de trabalho rápidos e repetíveis. A IA pode automatizar cronologias forenses, executar playbooks e acelerar a remediação enquanto o SOC mantém o controle. Por exemplo, integrações entre XDR e SOAR permitem que um mecanismo de sugestões com IA proponha passos de contenção, e então um engenheiro pode aprová-los ou substituí-los. Essa mistura de automação e supervisão humana reduz o tempo médio para detectar e o tempo médio para remediar. De fato, a automação reduz a carga de trabalho do analista e pode cortar falsos positivos quando correlações XDR filtram sinais ruidosos.

Casos de uso mostram benefícios práticos. Um modelo de IA pode analisar milhares de alertas, agrupar incidentes semelhantes e gerar um resumo curto para um analista. Em seguida, o analista decide se deve escalar. Para casos rotineiros de phishing, o sistema pode colocar mensagens em quarentena e marcar endpoints afetados, e então o SOC revisa a ação automatizada. Essa abordagem ajuda as equipes do SOC a se concentrarem em investigações que exigem julgamento humano. Além disso, a automação da coleta de evidências e da construção de cronologias acelera as investigações e reduz o risco de indicadores perdidos.

As equipes devem seguir uma lista de verificação de gerenciamento de mudanças antes de ativar ações automáticas. Primeiro, defina limites e pontuações de confiança. Segundo, mapeie playbooks para funções e aprovações. Terceiro, implemente monitoramento e rollback. Quarto, registre cada etapa automatizada para auditabilidade. Esses passos ajudam a proteger o ambiente e manter a conformidade. Um painel prático mostra sugestões de IA com substituições claras; isso simplifica o fluxo de trabalho e preserva a responsabilidade.

Métricas a acompanhar incluem alertas triados por hora, taxa de falsos positivos e tempo para contenção. Esses KPIs demonstram melhoria enquanto mantêm equipes responsáveis. Além disso, o SOC deve realizar verificações periódicas de red-team e incidentes simulados para validar o modelo de IA e reduzir o viés de automação entre os analistas. Pesquisas indicam que o viés de automação afeta uma grande parcela de profissionais de segurança, por isso etapas de verificação obrigatórias importam fatores humanos e viés de automação. Finalmente, as equipes devem documentar quando o sistema usa IA para escalar automaticamente e quando espera pela aprovação humana. Essa política clara ajuda tanto CISOs quanto respondentes de linha de frente.

Quando suas operações incluem fluxos pesados de email, considere combinar automação de segurança com plataformas de automação de email. virtualworkforce.ai ajuda equipes a direcionar e resolver emails operacionais, reduzindo contextos ruidosos que de outra forma desperdiçam tempo do SOC. Para mais sobre automatizar emails de logística e escalar fluxos operacionais, veja este recurso sobre correspondência logística automatizada correspondência logística automatizada.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

xdr and darktrace: agentic ai examples in extended detection

Plataformas de extended detection and response unificam sinais de endpoint, rede, nuvem e email. O XDR correlaciona essas fontes de telemetria e aplica modelos para revelar caminhos de ataque complexos. A Darktrace oferece modelagem comportamental e recursos de IA agentiva que se adaptam a linhas de base em mudança. Em atualizações recentes de produto, a Darktrace enfatizou forense autônoma e respostas adaptativas, onde a plataforma pode tomar ações de contenção e gerar justificativas legíveis por humanos para esses passos. Essa abordagem dá às equipes um caminho mais rápido para detecção e resposta tanto para ameaças conhecidas quanto para as novas.

Um cenário típico começa com um comportamento anômalo no endpoint que não corresponde a uma assinatura conhecida. O XDR correlaciona essa ação com fluxos de rede incomuns, e a plataforma sinaliza movimento lateral. Então, uma ação de contenção isola o endpoint, enquanto a forense automatizada captura artefatos. Exemplos de IA da Darktrace mostram como o aprendizado de máquina pode mapear as ações de um atacante entre dispositivos e então sugerir uma resposta que isola a superfície de ataque. Essa sequência ajuda a defender contra ransomware e propagação lateral.

A integração prática exige uma lista de verificação. Primeiro, assegure que seu XDR se conecte ao SIEM e SOAR para enriquecimento de eventos. Segundo, mapeie playbooks de resposta para ações automáticas versus manuais. Terceiro, configure a plataforma para exportar contexto para sistemas de ticket e email, de modo que as equipes do SOC mantenham rastreabilidade de ponta a ponta. Quarto, teste as transferências de EDR para XDR e confirme a fidelidade da telemetria. Um diagrama em camadas da cobertura do XDR e dos pontos de decisão da IA esclarece quem age e quando.

Os benefícios do XDR se estendem à segurança na nuvem e aos caminhos de segurança por email. A plataforma combina telemetria de endpoint, fluxos de rede e inteligência sobre ameaças para criar uma visão mais ampla da postura de segurança empresarial. Em implantações que envolvem a Darktrace, as equipes de segurança podem ver insights sobre o comportamento do atacante e opções rápidas de contenção. Ainda assim, as equipes devem validar decisões de IA agentiva por meio de auditorias e manter um registro de cada etapa executada autonomamente para governança. Para organizações em logística e operações, integrar insights do XDR com automação de email ajuda a manter a continuidade enquanto triagem ameaças que chegam via phishing ou contas comprometidas. Veja como a IA pode escalonar a comunicação de frete e preservar contexto em mensagens operacionais IA para comunicação com agentes de carga.

analyst: automation bias, accuracy limits and ai is used as decision aid

Fatores humanos moldam como as equipes adotam IA. Viés de automação e viés de confirmação podem levar analistas de segurança a confiar excessivamente nas saídas da IA. Estudos mostram que o viés de automação afeta uma grande parcela de profissionais, e os analistas devem aprender a tratar a IA como um auxílio à decisão em vez de um oráculo fatores humanos na cibersegurança orientada por IA. Além disso, pesquisas descobriram que muitas respostas geradas por IA contêm imprecisões e problemas de origem, o que é crítico para resposta a incidentes onde a confiança em fatos importa falhas de origem do assistente de IA. Portanto, líderes do SOC devem adicionar etapas obrigatórias de verificação e limites de confiança a cada recomendação automatizada.

Treinamento desempenha um papel importante. As equipes devem executar simulações de cenário, realizar exercícios de red-team e exigir que os analistas validem evidências antes de encerrar um incidente. Um controle prático é apresentar proveniência para cada recomendação para que os analistas possam rastrear alertas até os logs brutos e os estados do modelo de IA. Além disso, introduza procedimentos de tratamento de erros que especifiquem o que fazer quando o sistema mostrar baixa confiança ou saídas inconsistentes. Esse processo reduz o risco e mantém os humanos engajados no pensamento crítico.

Transparência ajuda também. Apresentar um resumo do porquê uma sugestão surgiu, os sinais que a suportaram e a versão do modelo que a gerou constrói confiança. Para trabalho analítico que usa resumos em linguagem natural, rotule-os claramente para evitar confiança excessiva. Porque a IA é amplamente utilizada agora, as equipes devem equilibrar velocidade com escrutínio. Uso de pontuações de confiança e exigir a assinatura de um analista para escaladas reduz a automação cega.

Finalmente, proteja-se contra shadow AI nas equipes. Shadow AI ocorre quando indivíduos usam ferramentas genai não autorizadas ou serviços gen ai para respostas rápidas. Essa prática pode vazar dados sensíveis e introduzir lógica inconsistente nas investigações. Estabeleça ferramentas genai aprovadas e um fluxo de trabalho seguro para qualquer consulta externa ou chamada de modelo. Forneça aos analistas um caminho claro para escalar casos complexos. Em suma, a IA deve capacitar o analista, não substituir o julgamento.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

vulnerability and sensitive data: ai to monitor, defend and create new risks

A IA ajuda a encontrar vulnerabilidades e a defender dados sensíveis, e ainda assim introduz riscos de duplo uso. No lado defensivo, a IA para monitorar logs e tráfego web pode detectar padrões que indicam tentativas de exploração de CVE e então acionar remediação para corrigir ou isolar workloads afetados. Ao mesmo tempo, atores maliciosos podem implantar agentes de IA para automatizar reconhecimento, elaborar phishing direcionado e até gerar variantes de malware. Artigos sobre ameaças emergentes notam o aumento de empregados de IA automatizados ou maliciosos que podem realizar engenharia social com perfil de insider ameaça de empregado de IA malicioso. Essa dualidade aumenta a importância de como você gerencia o acesso a dados sensíveis.

Preocupações com privacidade surgem quando a IA acessa logs que contêm PII ou segredos operacionais. Para proteger contra vazamentos, aplique políticas rigorosas de acesso a dados, use filtragem de entrada/saída e prefira implantações on‑premises ou de modelos privados para workloads de alta sensibilidade. Além disso, registre todas as ações e consultas da IA para que você possa reconstruir decisões e identificar qualquer egresso de dados anômalo. Para equipes que lidam com emails operacionais, garantir que plataformas de automação de email apliquem alinhamento de dados e governança entre ERP e fontes de documentos previne divulgações acidentais. Explore como a automação de email preserva contexto e reduz buscas manuais em fluxos de trabalho de logística ERP automação de emails logísticos.

Projete controles para detectar atividade maliciosa de IA. Monitore volumes anômalos de consultas e padrões incomuns que possam indicar uma ferramenta automatizada de descoberta ou um pipeline de exfiltração. Implemente limitadores e cotas em consultas que acessem grandes conjuntos de dados. Conduza threat hunting assumindo que atacantes podem aproveitar IA generativa para criar phishing polimórfico e elaborar mensagens de engenharia social plausíveis em escala. Além disso, revise as saídas do modelo em busca de alucinações ou alegações sem suporte, porque falhas de origem podem enganar analistas e expor sistemas a passos de remediação incorretos.

Finalmente, proteja os próprios modelos. Ataques de envenenamento de modelo e envenenamento de dados podem distorcer modelos de aprendizagem e reduzir a precisão de detecção. Validação periódica de modelos e verificações de proveniência de dados ajudam a detectar tentativas de envenenamento cedo. Mantenha versões assinadas de modelos e um plano de rollback para modelos comprometidos ou degradados. Em conjunto, esses passos ajudam a defender dados sensíveis enquanto permitem que a IA monitore e proteja sistemas de forma eficaz.

ai security and proactive cybersecurity: governance, validation and ai at every stage

A governança continua sendo a base da adoção segura de IA. Implemente validação de modelos, testes contínuos, explicabilidade e políticas de ciclo de vida antes de rollouts amplos. Exija checagens de proveniência e origem, realize auditorias periódicas de precisão e use rollouts em estágios com critérios de rollback. Esses controles alinham-se com obrigações regulatórias como GDPR e orientações da UE sobre minimização de dados e transparência. Além disso, inclua CISOs em revisões de governança e exija playbooks de incidente claros que cubram falhas de modelo.

Passos práticos incluem testes pré-implantação, monitoramento em tempo de execução, playbooks de incidente e critérios de rollback definidos. Por exemplo, realize um dry run pré-implantação que verifique o modelo de IA contra um corpus de teste que inclua amostras maliciosas conhecidas, tráfego ruidoso e entradas sensíveis à privacidade. Depois, monitore drift e precisão em produção e agende auditorias mensais. Use ferramentas de explicabilidade para fornecer aos analistas o raciocínio por trás de decisões-chave. Esses passos tornam soluções de cibersegurança potenciadas por IA auditáveis e confiáveis.

Adote uma lista de verificação para uso em produção: confirme controles de acesso, implemente sanitização de entrada, defina políticas de retenção e exija logs assinados de cada ação automatizada. Acompanhe KPIs como taxa de falsos positivos, tempo para contenção e porcentagem de alertas resolvidos com supervisão humana. Além disso, prepare um roadmap para os primeiros 90 dias de qualquer implantação de IA: métricas de baseline, testes em sandbox, habilitação em estágios, treinamento e aprovação de governança. Essa abordagem ajuda a entregar cibersegurança proativa que pode detectar tanto ameaças conhecidas quanto desconhecidas.

Finalmente, equilibre inovação com cautela. IA avançada e deep learning trazem novas capacidades de IA às ferramentas dos defensores, mas a governança mantém essas capacidades alinhadas com sua postura de segurança. Se você precisa escalar operações sem aumentar o quadro de pessoal, explore automatizar fluxos repetitivos como o manuseio de email operacional; virtualworkforce.ai mostra como agentes de IA podem reduzir o tempo de atendimento e manter o contexto anexado às escaladas, o que apoia tanto produtividade quanto objetivos de segurança. Comece pequeno, meça o impacto e itere com guardrails claros.

FAQ

What is an AI assistant in cybersecurity?

Um assistente de IA em cibersegurança é um agente automatizado que ajuda a monitorar, analisar e priorizar eventos de segurança. Ele fornece suporte à decisão, automatiza tarefas investigativas rotineiras e destaca alertas de alta confiança para revisão humana.

How do AI systems detect threats in real time?

Sistemas de IA ingerem telemetria de endpoints, rede e nuvem, então aplicam modelos para detectar anomalias que indicam comprometimento. Eles pontuam eventos, agrupam atividades relacionadas e levantam alertas em tempo real para que as equipes possam agir rapidamente.

Can AI reduce mean time to detect (MTTD)?

Sim. A IA acelera a triagem agrupando alertas, resumindo evidências e sugerindo passos de playbook, o que reduz o MTTD. Entretanto, as equipes devem validar as saídas para evitar viés de automação e falsos positivos.

What is XDR and how does it use AI?

XDR significa extended detection and response e unifica sinais de endpoint, rede, nuvem e email. Plataformas XDR usam agentes de IA e modelos comportamentais para correlacionar eventos e sugerir ações de contenção.

Are AI recommendations always accurate?

Não. Estudos mostram que as saídas de IA podem incluir imprecisões e falhas de origem, portanto as organizações devem exigir proveniência, pontuações de confiança e verificação humana. Auditorias e validações regulares reduzem o risco de ações equivocadas.

How do you prevent AI from leaking sensitive data?

Limite o acesso ao modelo, use filtragem de entrada/saída, prefira opções on‑premises ou de modelo privado para workloads sensíveis e registre cada ação da IA. Políticas de acesso a dados e regras de retenção também reduzem o risco de vazamento.

What is automation bias and how does it affect security analysts?

Viés de automação ocorre quando analistas confiam excessivamente nas saídas da IA e negligenciam a verificação independente. Isso pode causar anomalias perdidas; treinamento, limites de confiança e etapas obrigatórias de verificação ajudam a mitigar o problema.

How should organisations govern AI in security?

A governança deve incluir testes pré-implantação, monitoramento contínuo, explicabilidade, checagens de proveniência e rollouts em estágios. Alinhe esses controles com requisitos regulatórios como GDPR e estruturas internas de conformidade.

Can AI help with email-related security and operations?

Sim. A IA pode automatizar triagem de email, classificar intenção, anexar contexto e redigir respostas enquanto preserva trilhas de auditoria. Ferramentas que fundamentam respostas em ERP e sistemas de documentos podem reduzir consultas manuais e exposições de segurança. Para exemplos em automação de emails logísticos, veja este recurso sobre IA na comunicação de frete IA na comunicação logística de frete.

What are the first steps to deploy an AI assistant safely?

Comece com um piloto pequeno, defina KPIs, realize validação de modelo e exija aprovações humano‑no‑loop para ações de alto impacto. Além disso, prepare planos de rollback e treine analistas em procedimentos de tratamento de erros e verificação.

Ready to revolutionize your workplace?

Achieve more with your existing team with Virtual Workforce.