ai-cybersikkerhed: hvordan ai-assistenter opdager trusler i realtid

AI hjælper SIKKERHEDSTEAMS med at opdage anomalier og trusler i stor skala, og det gør den kontinuerligt. For eksempel kan en AI-assistent overvåge logs, korrelere telemetri og fremhæve en realtime-alarm, når mønstre matcher en kendt signatur eller et usædvanligt adfærdsfingeraftryk. Denne evne er vigtig, fordi 77% af virksomhederne enten bruger eller undersøger AI i drift, hvilket forklarer den stærke AI-adoption på tværs af virksomhedsmiljøer 77% adoptionsstatistik. I praksis kører AI-drevet telemetriindtag, feature-ekstraktion og scoring mange gange hurtigere end manuel gennemgang. Flowet starter typisk med telemetri → en AI-model → alarmtriage → respons. En simpel loop kan se sådan ud: sensorer leverer endpoint- og netværksdata, AI-modellen scorer anomalier, systemet rejser en alarm, og så udløser containement en playbook. Dette er især nyttigt til realtids trusselsdetektion, hvor minutter tæller.

AI-cybersikkerhedsværktøjer driver allerede mange detektions- og responsrørledninger. En gennemgang af agentisk AI bemærker, at agentisk AI kan tilpasse sig nye trusler og handle med kognitiv autonomi, når den er konfigureret til det agentisk AI i cybersikkerhed. Derfor reducerer platforme, der kombinerer adfærdsbaselines med streaminganalyse, opholdstid og fremhæver ukendte adfærdsmønstre. I et kort brugstilfælde opdager systemet et mønster af lateral bevægelse, udsender en alarm, isolerer endepunktet og eskalerer hændelsen til SOC til gennemgang. Den automatiserede containment-loop sparer tid og reducerer menneskelige fejl.

Sikkerhedsarkitekter må beslutte, hvad der skal automatiseres, og hvad der skal overlades til analytikere. Til realtidsmonitorering kan AI filtrere støj og prioritere trusler på en måde, der hjælper sikkerhedsteams med at fokusere på højrisiko-hændelser. Samtidig bør teams kræve proveniens og tillids-scores for hver anbefaling, fordi undersøgelser viser, at AI-output kan indeholde unøjagtigheder og fejl i kildeangivelser, hvilket har betydning i en sikkerhedskontekst undersøgelse af sourcing-fejl. Derudover tilbyder leverandører nu AI-drevne cybersikkerhedsplatforme, der integrerer med SIEM, EDR og cloud-feeds, hvilket muliggør en hurtig detektions- og responsworkflow, samtidig med at mennesker holdes i loopet for kritiske beslutninger.

For organisationer, der håndterer et stort e-mail-arbejdspres, er der også operationelle AI-applikationer. For eksempel bruger virtualworkforce.ai AI-agenter til at automatisere e-mail-livscyklusser for driftsteams, rute beskeder og knytte kontekst til eskalationer. Det reducerer tid brugt i triage og hjælper teams med at opretholde en stærkere sikkerhedsholdning i kommunikation. Kort sagt opdager ai-cybersikkerhed i praksis både trusler i realtid og hjælper med at strømline det operationelle overhead, der ellers kan distrahere SOC-personale.

sikkerhedsoperationer: brug af ai-assistent til at fremskynde detektion og udbedring

Sikkerhedsoperationer er afhængige af hurtige, gentagelige workflows. AI kan automatisere retsmedicinske tidslinjer, køre playbooks og fremskynde udbedring, mens SOC bevarer kontrollen. For eksempel tillader integrationer mellem XDR og SOAR, at en AI-drevet forslagssmotor foreslår containment-trin, hvorefter en ingeniør kan godkende eller tilsidesætte dem. Denne blanding af automation og menneskelig overvågning reducerer gennemsnitlig tid til påvisning og gennemsnitlig tid til udbedring. Faktisk reducerer automation analytikerarbejdsmængden og kan skære i falske positiver, når XDR-korrelationer filtrerer støjende signaler.

Use cases viser praktiske fordele. En AI-model kan parse tusindvis af alarmer, gruppere lignende hændelser og generere et kort resume for en analytiker. Derefter beslutter analytikeren, om der skal eskaleres. Ved rutinemæssige phishing-sager kan systemet sætte beskeder i karantæne og markere berørte endpoints, hvorefter SOC gennemgår den automatiserede handling. Denne tilgang hjælper SOC-teams med at fokusere på undersøgelser, der kræver menneskelig dømmekraft. Også automatisering af indsamling af beviser og opbygning af tidslinjer fremskynder efterforskninger og reducerer risikoen for mistede indikatorer.

Teams bør følge en change-management tjekliste, før de aktiverer automatiske handlinger. Først definér tærskler og tillids-scores. For det andet kortlæg playbooks til roller og godkendelser. For det tredje implementer overvågning og rollback-mekanismer. For det fjerde log hvert automatiseret skridt for auditabilitet. Disse trin hjælper med at beskytte miljøet og opretholde compliance. Et praktisk dashboard viser AI-forslag med klare tilsidesættelser; dette strømliner workflowet og bevarer ansvarlighed.

Metrier at spore inkluderer alarmer triageret per time, falsk positiv-rate og tid til containment. Disse KPI’er viser forbedring samtidig med, at teams holdes ansvarlige. Desuden bør SOC gennemføre periodiske red-team checks og simulerede hændelser for at validere AI-modellen og mindske automatiseringsbias blandt analytikere. Forskning indikerer, at automatiseringsbias påvirker en stor andel af sikkerhedsprofessionelle, hvilket er grunden til, at obligatoriske verifikationskriterier er vigtige menneskelige faktorer og automatiseringsbias. Endelig bør teams dokumentere, hvornår systemet bruger AI til automatisk eskalering, og hvornår det venter på menneskelig godkendelse. Denne klare politik hjælper både CISOs og frontlinjerespondenter.

Når dine operationer inkluderer tung e-mail-workflow, overvej at kombinere sikkerhedsautomation med e-mail-automationsplatforme. virtualworkforce.ai hjælper teams med at dirigere og løse operationelle e-mails, hvilket reducerer støjende kontekster, der ellers spilder SOC-tid. For mere om automatisering af logistik-e-mails og skalering af operationelle workflows, se denne ressource om automatiseret logistikkorrespondance automatiseret logistikkorrespondance.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

xdr og darktrace: agentisk ai-eksempler i udvidet detektion

Extended detection and response-platforme forener signaler på tværs af endpoint, netværk, cloud og e-mail. XDR korrelerer disse telemetrikilder og anvender modeller til at afsløre komplekse angrebsveje. Darktrace tilbyder adfærdsmodellering og agentisk AI-funktioner, der tilpasser sig ændrede baselines. I nyere produktopdateringer har Darktrace understreget autonom retsmedicin og adaptive responser, hvor platformen kan tage containment-handlinger og generere menneskelæselig begrundelse for disse skridt. Denne tilgang giver teams en hurtigere vej til detektion og respons for både kendte og nye trusler.

Et typisk scenarie starter med anomal adfærd på et endpoint, som ikke matcher en kendt signatur. XDR korrelerer denne handling med usædvanlige netværksflows, og platformen flagger lateral bevægelse. Derefter isolerer en containment-handling endpointet, mens automatiseret retsmedicin indfanger artefakter. Darktrace AI-eksempler viser, hvordan maskinlæring kan kortlægge en angribers handlinger på tværs af enheder og derefter foreslå en respons, der isolerer angrebsoverfladen. Den sekvens hjælper med at beskytte mod ransomware og lateral spredning.

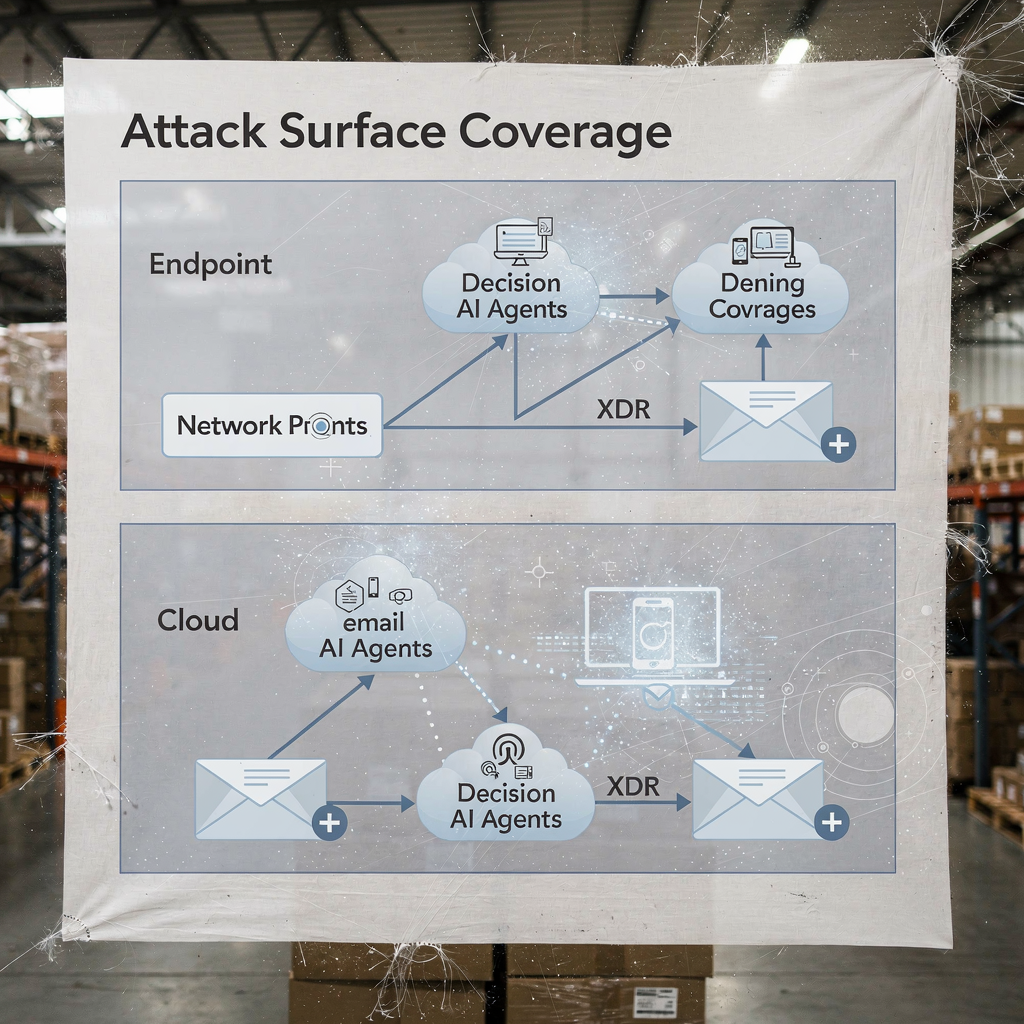

Praktisk integration kræver en tjekliste. Først sørg for, at din XDR binder sig til SIEM og SOAR for event-enrichment. For det andet kortlæg response-playbooks for automatiske versus manuelle handlinger. For det tredje konfigurer platformen til at eksportere kontekst til ticketing og e-mail, så SOC-teams bevarer end-to-end sporbarhed. For det fjerde test EDR-til-XDR handoffs og bekræft telemetri-fidelitet. Et lagdelt diagram over XDR-dækning og AI-beslutningspunkter tydeliggør, hvem der handler og hvornår.

XDR-fordele strækker sig også til cloud-sikkerhed og e-mail-sikkerhed. Platformen kombinerer endpoint-telemetri, netværksflows og trusselsintelligens for at skabe et bredere billede af virksomhedens sikkerhedsholdning. I deployment, der involverer Darktrace, kan sikkerhedsteams se indsigt i angriberadfærd og hurtige containment-muligheder. Alligevel bør teams validere agentiske AI-beslutninger gennem audits og føre log over hvert autonomt udført skridt til governance. For organisationer inden for logistik og drift hjælper integration af XDR-indsigt med e-mail-automatisering med at bevare kontinuiteten, mens trusler, der ankommer via phishing eller kompromitterede konti, triageres. Se, hvordan AI kan skalere fragtkommunikation og bevare kontekst i operationelle beskeder AI i fragtlogistik-kommunikation.

analytiker: automatiseringsbias, nøjagtighedsbegrænsninger og AI som beslutningshjælp

Menneskelige faktorer former, hvordan teams adopterer AI. Automatiseringsbias og confirmation bias kan få sikkerhedsanalytikere til at stole for meget på AI-output. Undersøgelser viser, at automatiseringsbias påvirker en stor del af praktikere, og analytikere må lære at betragte AI som en beslutningshjælp frem for et orakel menneskelige faktorer i AI-drevet cybersikkerhed. Desuden fandt forskning, at mange AI-genererede svar indeholder unøjagtigheder og problemer med kildeangivelser, hvilket er kritisk for incident response, hvor tillid til fakta betyder noget kildefejl i AI-assistenter. Derfor bør SOC-ledere tilføje obligatoriske verifikationstrin og tillidstærskler til hver automatiseret anbefaling.

Træning spiller en væsentlig rolle. Teams bør køre scenariedrills, udføre red-team-øvelser og kræve, at analytikere validerer beviser, før en hændelse lukkes. En praktisk kontrol er at præsentere proveniens for hver anbefaling, så analytikere kan spore alarmer tilbage til rå logs og AI-modeltilstande. Indfør også fejlbehandlingsprocedurer, der specificerer, hvad der skal gøres, når systemet viser lav tillid eller inkonsistente output. Denne proces reducerer risiko og holder mennesker engagerede i kritisk tænkning.

Gennemsigtighed hjælper også. Ved at præsentere et resume af, hvorfor et forslag opstod, de signaler der understøttede det, og modelversionen der genererede det, bygges tillid. Til analytisk arbejde, der bruger naturligt sprog til opsummeringer, skal disse tydeligt mærkes for at undgå overafhængighed. Fordi AI nu anvendes bredt, må teams balancere hastighed med kontrol. Brug af tillidsscores og krav om analytiker-godkendelse for eskalationer reducerer blind automation.

Endelig beskyt mod shadow AI i teams. Shadow AI opstår, når enkeltpersoner bruger uautoriserede genAI-værktøjer eller genAI-tjenester for hurtige svar. Denne praksis kan lække følsomme data og indføre inkonsistent logik i undersøgelser. Etabler godkendte genAI-værktøjer og en sikker workflow for enhver ekstern forespørgsel eller modelkald. Giv analytikere en klar vej til at eskalere komplekse sager. Kort sagt bør AI styrke analytikeren, ikke erstatte dømmekraft.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

sårbarheder og følsomme data: AI til overvågning, forsvar og skabelse af nye risici

AI hjælper med at finde sårbarheder og forsvare følsomme data, men den introducerer også dual-use risici. På den defensive side kan AI til at overvåge logs og webtrafik opdage mønstre, der indikerer forsøg på udnyttelse af CVE’er, og derefter udløse udbedring for at patche eller isolere berørte workloads. Samtidig kan ondsindede aktører deployere AI-agenter til at automatisere rekognoscering, skabe målrettet phishing og endda generere malware-varianter. Artikler om fremvoksende trusler bemærker stigningen i automatiserede eller ondsindede AI‑medarbejdere, der kan udføre insider-lignende social engineering trussel fra ondsindede AI-medarbejdere. Denne dualitet øger betydningen af, hvordan du håndterer adgang til følsomme data.

Privatlivsbekymringer opstår, når AI får adgang til logs, der indeholder PII eller operationelle hemmeligheder. For at beskytte mod lækager, håndhæv strenge dataadgangspolitikker, brug input-/output-filtrering, og foretræk on-premises eller private-model-implementeringer til høj-sensitivitets workloads. Log også alle AI-handlinger og forespørgsler, så du kan rekonstruere beslutninger og identificere eventuel anomal dataeksfiltration. For teams, der håndterer operationelle e-mails, sikrer det, at e-mail-automationsplatforme anvender data-grounding og governance på tværs af ERP og dokumentsystemer, at utilsigtet videregivelse forhindres. Udforsk, hvordan e-mail-automatisering bevarer kontekst og reducerer manuelle opslag i logistikworkflows ERP e-mail-automatisering for logistik.

Design kontroller til at opdage ondsindet AI-aktivitet. Overvåg for anomaløse forespørgselsvolumener og usædvanlige mønstre, der kan indikere et automatiseret opdagelsesværktøj eller en eksfiltrationspipeline. Implementer throttles og kvoter på forespørgsler, der får adgang til store datasæt. Foretag threat hunting, der antager, at angribere kan bruge generativ AI til at udforme polymorfe phishing-kampagner og plausible social engineering-beskeder i stor skala. Gennemgå også modeloutputs for hallucinationer eller ubekræftede påstande, fordi sourcing-fejl kan vildlede analytikere og udsætte systemer for forkerte udbedringstrin.

Endelig beskyt modellerne selv. Model-poisoning og data-poisoning-angreb kan skævvride læringsmodeller og reducere detektionsnøjagtigheden. Periodisk modelvalidering og kontrol af dataproveniens hjælper med at opdage poisoning-forsøg tidligt. Oprethold signerede modelversioner og en rollback-plan for kompromitterede eller degraderede modeller. Tilsammen hjælper disse trin med at forsvare følsomme data, mens AI gør det muligt at overvåge og beskytte systemer effektivt.

AI-sikkerhed og proaktiv cybersikkerhed: styring, validering og AI i alle faser

Governance forbliver fundamentet for sikker AI-adoption. Implementer modelvalidering, kontinuerlig test, forklarbarhed og livscykluspolitikker før brede udrulninger. Kræv proveniens- og kildekontrol, udfør periodiske nøjagtighedsaudits, og brug staged rollouts med rollback-kriterier. Disse kontroller stemmer overens med regulatoriske forpligtelser som GDPR og EU-vejledning omkring data-minimering og gennemsigtighed. Inkludér også CISOs i governance-reviewer og kræv klare incident-playbooks, der dækker modelfejl.

Praktiske skridt inkluderer præ-udrulnings-test, runtime-overvågning, incident-playbooks og definerede rollback-kriterier. For eksempel hold en præ-udrulnings dry run, der tester AI-modellen mod et testkorpus, der inkluderer kendte maligne prøver, støjende trafik og privatlivs-sensitive poster. Overvåg derefter drift og drift i produktion, og planlæg månedlige audits. Brug forklarbarhedsværktøjer til at give analytikere rationale bag nøglebeslutninger. Sådanne tiltag gør AI-drevne cybersikkerhedsløsninger auditerbare og pålidelige.

Adoptér en tjekliste til produktionsbrug: bekræft adgangskontroller, implementer input-sanitisation, sæt opbevaringspolitikker, og kræv signerede logs af hver automatiseret handling. Spor KPI’er som falsk positiv-rate, tid til containment og procentdel af alarmer løst med menneskelig overvågning. Forbered også en 90-dages roadmap for enhver AI-udrulning: baseline-metrikker, sandkasseprøver, staged enablement, træning og governance-godkendelse. Denne tilgang hjælper med at levere proaktiv cybersikkerhed, der kan opdage både kendte og ukendte trusler.

Endelig, balancer innovation med forsigtighed. Avanceret AI og deep learning bringer nye AI-muligheder til forsvarerværktøjskassen, men governance holder disse kapaciteter i tråd med din sikkerhedsholdning. Hvis du har brug for at skalere operationer uden at øge medarbejderstaben, så udforsk automatisering af gentagne flows som håndtering af operationelle e-mails; virtualworkforce.ai viser, hvordan AI-agenter kan reducere behandlingstid og bevare kontekst knyttet til eskalationer, hvilket understøtter både produktivitet og sikkerhedsmål. Start i det små, mål effekten, og iterér med klare sikkerhedsrammer.

FAQ

Hvad er en AI-assistent i cybersikkerhed?

En AI-assistent i cybersikkerhed er en automatiseret agent, der hjælper med at overvåge, analysere og prioritere sikkerhedshændelser. Den leverer beslutningsstøtte, automatiserer rutineundersøgelser og fremhæver høj-sandsynlighedsalamer til menneskelig gennemgang.

Hvordan opdager AI-systemer trusler i realtid?

AI-systemer indtager telemetri fra endpoints, netværk og cloud, og anvender derefter modeller til at opdage anomalier, der indikerer kompromittering. De scorer hændelser, grupperer relateret aktivitet og rejser realtidsalarmer, så teams kan handle hurtigt.

Kan AI reducere mean time to detect (MTTD)?

Ja. AI accelererer triage ved at gruppere alarmer, opsummere beviser og foreslå playbook-trin, hvilket sænker MTTD. Dog skal teams validere output for at undgå automatiseringsbias og falske positiver.

Hvad er XDR, og hvordan bruger det AI?

XDR står for extended detection and response og forener signaler på tværs af endpoint, netværk, cloud og e-mail. XDR-platforme bruger AI-agenter og adfærdsmodeller til at korrelere hændelser og foreslå containment-handlinger.

Er AI-anbefalinger altid nøjagtige?

Nej. Undersøgelser viser, at AI-output kan indeholde unøjagtigheder og fejl i kildeangivelser, så organisationer bør kræve proveniens, tillids-scores og menneskelig verifikation. Regelmæssige audits og validering reducerer risikoen for fejlagtige handlinger.

Hvordan forhindrer man, at AI lækker følsomme data?

Begræns adgang til modeller, brug input-/output-filtrering, foretræk on-premises eller private-model-løsninger for følsomme workloads, og log hver AI-handling. Dataadgangspolitikker og opbevaringsregler reducerer også lækkerisrisikoen.

Hvad er automatiseringsbias, og hvordan påvirker det sikkerhedsanalytikere?

Automatiseringsbias opstår, når analytikere stoler for meget på AI-output og undlader uafhængig verifikation. Det kan medføre oversete anomalier; træning, tillidstærskler og obligatoriske verifikationstrin hjælper med at afbøde det.

Hvordan bør organisationer styre AI i sikkerhed?

Governance bør inkludere præ-udrulnings-test, kontinuerlig overvågning, forklarbarhed, proveniens-kontrol og staged rollouts. Tilpas disse kontroller til regulatoriske krav som GDPR og interne compliance-rammer.

Kan AI hjælpe med e-mail-relateret sikkerhed og drift?

Ja. AI kan automatisere e-mail-triage, klassificere intention, knytte kontekst og udarbejde svar, samtidig med at revisionsspor bevares. Værktøjer, der forankrer svar i ERP og dokumentsystemer, kan reducere manuelle opslag og sikkerhedsrisici. For eksempler i logistik-e-mail-automatisering, se denne ressource om AI i fragtlogistik-kommunikation AI i fragtlogistik-kommunikation.

Hvad er de første skridt til at implementere en AI-assistent sikkert?

Start med et lille pilotprojekt, definer KPI’er, udfør modelvalidering, og kræv menneske-i-loop godkendelser for handlinger med høj påvirkning. Forbered også rollback-planer, og træn analytikere i fejlbehandling og verifikationsprocedurer.

Ready to revolutionize your workplace?

Achieve more with your existing team with Virtual Workforce.