AI-cybersäkerhet: hur AI-assistenter upptäcker hot i realtid

AI hjälper SÄKERHETSTEAM att upptäcka avvikelser och hot i stor skala, och gör det kontinuerligt. Till exempel kan en AI-assistent övervaka loggar, korrelera telemetri och lyfta ett realtidslarm när mönster matchar en känd signatur eller ett ovanligt beteendefingeravtryck. Denna förmåga är viktig eftersom 77% av företag antingen använder eller utforskar AI i drift, vilket förklarar den starka AI-adoptionen i företagsmiljöer 77% adoptionstatistik. I praktiken kör AI-driven telemetriingest, funktionsutdragning och poängsättning många gånger snabbare än manuell granskning. Flödet börjar typiskt med telemetri → en AI-modell → larmtriage → respons. En enkel loop kan se ut så här: sensorer matar endpoint- och nätverksdata, AI-modellen poängsätter avvikelser, systemet höjer ett larm och sedan triggas innehållande åtgärder via ett playbook. Detta är särskilt användbart för hotdetektion i realtid där minuter spelar roll.

AI-cybersäkerhetsverktyg driver redan många detekterings- och responskedjor. En översikt över agentisk AI noterar att agentisk AI kan anpassa sig till nya hot och agera med kognitiv autonomi när den är konfigurerad för det agentisk AI i cybersäkerhet. Därför reducerar plattformar som kombinerar beteendebaserade baslinjer med strömmande analys uppehållstiden och lyfter fram okända beteenden. I ett kort användningsfall upptäcker systemet ett lateralt rörelsemönster, utfärdar ett larm, isolerar endpointen och eskalerar incidenten till SOC för granskning. Denna automatiserade innehållningsloop sparar tid och minskar mänskliga fel.

Säkerhetsarkitekter måste bestämma vad som ska automatiseras och vad som ska lämnas åt analytiker. För övervakning i realtid kan AI filtrera bort brus och prioritera hot på ett sätt som hjälper säkerhetsteamen att fokusera på högriskincidenter. Samtidigt bör team kräva proveniens och konfidenspoäng för varje rekommendation, eftersom studier visar att AI-utdata kan innehålla felaktigheter och källfel som är viktiga i ett säkerhetssammanhang studie om källhänvisningsfel. Dessutom erbjuder leverantörer nu AI-drivna cybersäkerhetsplattformar som integrerar med SIEM, EDR och molnflöden, vilket möjliggör ett snabbt detektions- och responsarbetsflöde samtidigt som människor hålls i loopen för kritiska beslut.

För organisationer som hanterar en stor e-postvolym finns det även operativa AI-applikationer. Till exempel använder virtualworkforce.ai AI-agenter för att automatisera e-postlivscykler för driftteam, dirigera meddelanden och bifoga kontext till eskalationer. Det minskar tid som går förlorad i triage och hjälper team att upprätthålla en starkare säkerhetsposition över kommunikationen. Kort sagt upptäcker AI-cybersäkerhet i praktiken både hot i realtid och hjälper till att effektivisera driftmässig overhead som annars kan distrahera SOC-personal.

säkerhetsoperationer: använda AI-assistent för att snabba på upptäckt och åtgärd

Säkerhetsoperationer förlitar sig på snabba, upprepbara arbetsflöden. AI kan automatisera forensiska tidslinjer, köra playbooks och snabba upp åtgärder medan SOC behåller kontrollen. Till exempel möjliggör integrationer mellan XDR och SOAR att en AI-driven förslagsmotor föreslår innehållningssteg, och sedan kan en ingenjör godkänna eller åsidosätta dem. Denna blandning av automation och mänsklig övervakning minskar genomsnittlig tid till upptäckt och genomsnittlig tid till åtgärd. Faktum är att automation minskar analytikerns arbetsbelastning och kan skära ner falska positiva när XDR-korrelationer filtrerar bort bullriga signaler.

Användningsfall visar praktiska fördelar. En AI-modell kan tolka tusentals larm, gruppera liknande incidenter och generera en kort sammanfattning för en analytiker. Därefter avgör analytikern om ärendet ska eskaleras. För rutinmässiga phishingärenden kan systemet karantänsätta meddelanden och markera påverkade endpoints, och sedan granskar SOC den automatiska åtgärden. Detta tillvägagångssätt hjälper SOC-team att fokusera på undersökningar som kräver mänskligt omdöme. Dessutom snabbar automatisering av bevisinsamling och tidslinjekonstruktion upp undersökningar och minskar risken för missade indikatorer.

Team bör följa en ändringshanterings-checklista innan automatiska åtgärder aktiveras. Först, definiera tröskelvärden och konfidenspoäng. För det andra, kartlägg playbooks till roller och godkännanden. För det tredje, implementera övervakning och rollback-mekanismer. För det fjärde, logga varje automatiskt steg för revisionsbarhet. Dessa steg hjälper till att skydda miljön och upprätthålla efterlevnad. En praktisk instrumentpanel visar AI-förslag med tydliga åsidosättningar; detta förenklar arbetsflödet och bevarar ansvarsskyldighet.

Mått att följa inkluderar antal larm triagerade per timme, andel falska positiva och tid till innehållning. Dessa KPI:er visar förbättringar samtidigt som team hålls ansvariga. Dessutom bör SOC genomföra periodiska red-team-tester och simulerade incidenter för att validera AI-modellen och minska automatiseringsbias bland analytiker. Forskning indikerar att automatiseringsbias påverkar en stor andel säkerhetsproffs, vilket är anledningen till att obligatoriska verifieringssteg är viktiga människofaktorer och automatiseringsbias. Slutligen bör team dokumentera när systemet använder AI för att automatiskt eskalera, och när det väntar på mänskligt godkännande. Denna tydliga policy hjälper både CISOs och förstalinje-respondenter.

När dina operationer inkluderar tunga e-postarbetsflöden, överväg att kombinera säkerhetsautomation med e-postautomationsplattformar. virtualworkforce.ai hjälper team att dirigera och lösa operativa e-postmeddelanden, vilket minskar bullriga kontexter som annars slösar SOC-tid. För mer om att automatisera logistikmejl och skala operativa arbetsflöden, se denna resurs om automatiserad logistikkorrespondens.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

xdr och darktrace: agentiska AI-exempel i extended detection

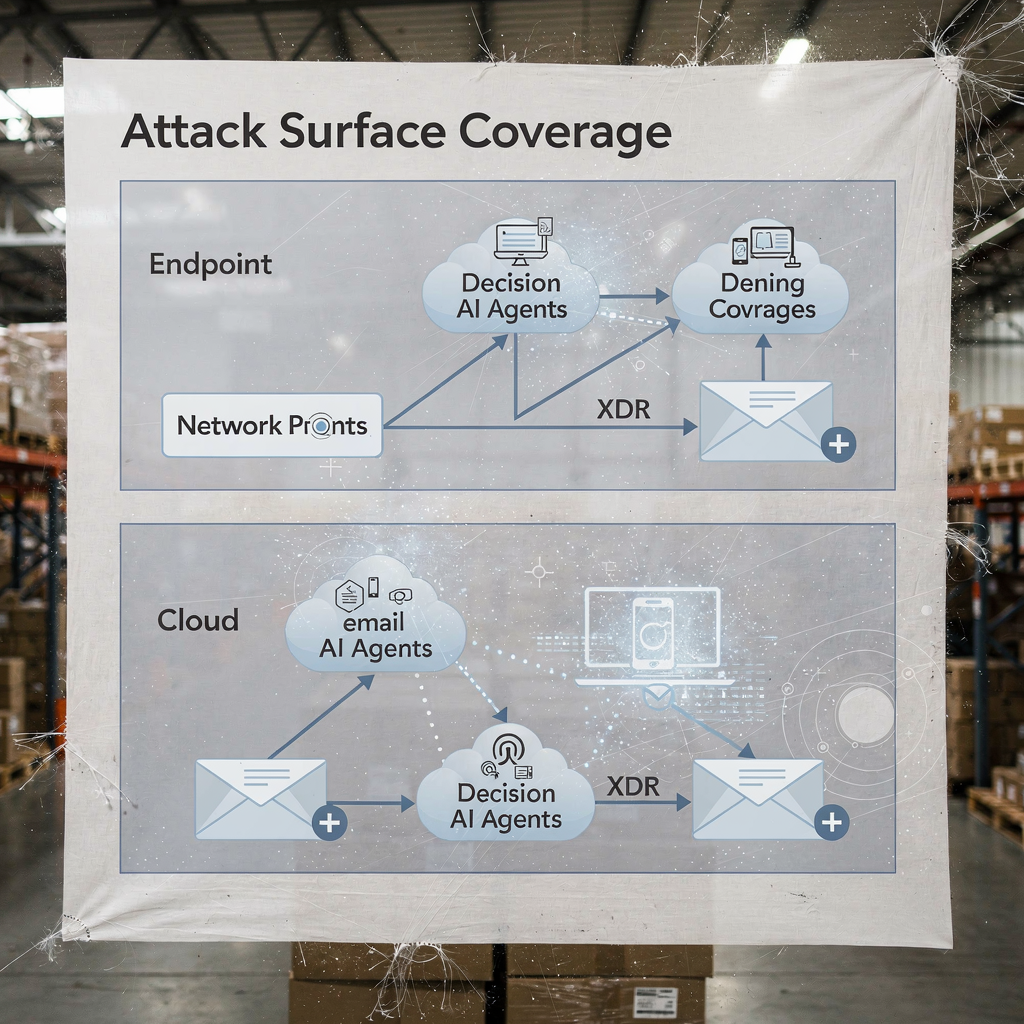

Plattformar för extended detection and response förenar signaler från endpoint, nätverk, moln och e-post. XDR korrelerar dessa telemetrikällor och tillämpar modeller för att avslöja komplexa angreppsvägar. Darktrace erbjuder beteendemodellering och agentiska AI-funktioner som anpassar sig till föränderliga baslinjer. I nyare produktuppdateringar har Darktrace betonat autonom forensik och adaptiva svar, där plattformen kan vidta innehållningsåtgärder och generera mänskligt läsbar motivering för dessa steg. Detta tillvägagångssätt ger team en snabbare väg till detektion och respons för både kända och nya hot.

Ett typiskt scenario börjar med anomalöst beteende på en endpoint som inte matchar en känd signatur. XDR korrelerar den åtgärden med ovanliga nätverksflöden, och plattformen flaggar lateral rörelse. Därefter isolerar en innehållande åtgärd endpointen, medan automatisk forensik fångar artefakter. Darktrace-exempel visar hur maskininlärning kan kartlägga en angripares handlingar över enheter och sedan föreslå ett svar som isolerar angriparens yta. Den sekvensen hjälper till att försvara mot ransomware och lateral spridning.

Praktisk integration kräver en checklista. Först, säkerställ att din XDR knyter in mot SIEM och SOAR för händelseberikning. För det andra, kartlägg responsplaybooks för automatiska respektive manuella åtgärder. För det tredje, konfigurera plattformen att exportera kontext till ticketing och e-post, så SOC-team behåller ända-till-ända spårbarhet. För det fjärde, testa EDR-till-XDR-handoffs och bekräfta telemetrifidelitet. Ett lagerdiagram över XDR-täckning och AI-beslutspunkter klargör vem som agerar och när.

XDR-fördelarna sträcker sig till molnsäkerhet och e-postsäkerhetspår. Plattformen kombinerar endpoint-telemetri, nätverksflöden och hotintelligens för att skapa en bredare bild av företags säkerhetspostur. I implementationer som involverar Darktrace kan säkerhetsteam få insikter i angriparbeteende och snabba innehållsalternativ. Fortfarande bör team validera agentiska AI-beslut genom revisioner och upprätthålla en logg över varje autonomt utfört steg för styrning. För organisationer inom logistik och drift hjälper integration av XDR-insikter med e-postautomation att bibehålla kontinuitet samtidigt som man triagerar hot som kommer via phishing eller komprometterade konton. Se hur AI kan skala fraktkommunikation och bevara kontext i operativa meddelanden AI för speditörskommunikation.

analytiker: automatiseringsbias, noggränsningsbegränsningar och AI som beslutsstöd

Människofaktorer formar hur team tar till sig AI. Automatiseringsbias och bekräftelsebias kan få säkerhetsanalytiker att övertro AI-utdata. Studier visar att automatiseringsbias påverkar en stor andel utövare, och analytiker måste lära sig att betrakta AI som ett beslutsstöd snarare än ett orakel människofaktorer i AI-driven cybersäkerhet. Dessutom fann forskning att många AI-genererade svar innehåller felaktigheter och källproblem, vilket är kritiskt för incidenthantering där förtroende för fakta är viktigt AI-assistentens källhänvisningsfel. Därför bör SOC-ledare lägga till obligatoriska verifieringssteg och konfidenströsklar för varje automatiserat rekommendation.

Träning spelar en stor roll. Team bör köra scenariodrillar, utföra red-team-övningar och kräva att analytiker validerar bevis innan en incident stängs. En praktisk kontroll är att presentera proveniens för varje rekommendation så analytiker kan spåra larm tillbaka till råloggar och AI-modellens tillstånd. Inför även felhanteringsprocedurer som anger vad som ska göras när systemet visar låg konfidens eller inkonsekventa utsagor. Denna process minskar risk och håller människor engagerade i kritiskt tänkande.

Transparens hjälper också. Att visa en sammanfattning av varför ett förslag uppstod, de signaler som stödde det och modellversionen som genererade det bygger förtroende. För analytiskt arbete som använder naturliga språksammanfattningar, märk dem tydligt för att undvika överberoende. Eftersom AI nu används brett måste team balansera hastighet med granskning. Användning av konfidenspoäng och krav på analytikers godkännande för eskalationer minskar blind automation.

Slutligen, skydda mot så kallad shadow AI i teamen. Shadow AI uppstår när individer använder obehöriga generativa AI-verktyg eller genAI-tjänster för snabba svar. Denna praxis kan läcka känslig data och införa inkonsekvent logik i undersökningar. Etablera godkända genAI-verktyg och ett säkert arbetsflöde för alla externa frågor eller modellanrop. Ge analytiker en tydlig väg för att eskalera komplexa ärenden. Kort sagt, AI ska stärka analytikern, inte ersätta omdömet.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

sårbarheter och känsliga data: AI för att övervaka, försvara och skapa nya risker

AI hjälper till att hitta sårbarheter och att skydda känsliga data, och samtidigt medför den dubbelanvändningsrisker. På försvarssidan kan AI som övervakar loggar och web-trafik upptäcka mönster som indikerar försök att utnyttja CVE:er, och sedan trigga åtgärder för att patcha eller isolera berörda arbetsbelastningar. Samtidigt kan illvilliga aktörer distribuera AI-agenter för att automatisera rekognosering, skapa målinriktade phishingmejl och till och med generera malware-varianter. Artiklar om framväxande hot noterar ökningen av automatiserade eller illvilliga AI-anställda som kan utföra insiderlik social ingenjörskonst hotet från illvilliga AI-anställda. Denna dualitet höjer insatserna för hur du hanterar åtkomst till känsliga data.

Integritetsproblem uppstår när AI får tillgång till loggar som innehåller personuppgifter eller driftshandlingar. För att skydda mot läckor, verkställ strikta åtkomstpolicys, använd in-/utfiltrering och föredra on-premises eller privata modellimplementeringar för högkänsliga arbetsbelastningar. Logga även alla AI-åtgärder och frågor så att du kan rekonstruera beslut och identifiera anomal dataegress. För team som hanterar operativa e-postmeddelanden, säkerställ att e-postautomationsplattformar tillämpar datagrundning och styrning över ERP- och dokumentsystem för att förhindra oavsiktlig exponering. Utforska hur e-postautomation bevarar kontext och minskar manuella uppslag i logistikarbetsflöden ERP‑epostautomation för logistik.

Designa kontroller för att upptäcka illvillig AI-aktivitet. Övervaka för anomalösa frågevolymer och ovanliga mönster som kan indikera ett automatiserat upptäcktsverktyg eller en exfiltreringspipeline. Implementera throttles och kvoter på frågor som når stora dataset. Genomför threat hunting med antagandet att angripare kan använda generativ AI för att skapa polymorf phishing och konstruera trovärdiga sociala ingenjörsmeddelanden i skala. Granska också modelldata för hallucinationer eller påståenden utan stöd, eftersom källfel kan vilseleda analytiker och leda till felaktiga åtgärder.

Slutligen, skydda modellerna själva. Modellförgiftning och datapoisning-attacker kan snedvrida inlärningsmodeller och minska detektionsnoggrannheten. Periodisk modellvalidering och kontroller av dataproveniens hjälper till att upptäcka förgiftning tidigt. Behåll signerade modellversioner och en rollback-plan för komprometterade eller degraderade modeller. Tillsammans hjälper dessa steg att skydda känsliga data samtidigt som AI används för att övervaka och skydda system effektivt.

AI-säkerhet och proaktiv cybersäkerhet: styrning, validering och AI i varje steg

Styrning förblir grunden för säker AI-adoption. Implementera modellvalidering, kontinuerlig testning, förklarbarhet och livscykelpolicyer innan bred utrullning. Kräv proveniens- och källkontroller, utför periodiska noggrannhetsrevisioner och använd stegvisa utrullningar med rollback-kriterier. Dessa kontroller ligger i linje med regulatoriska åtaganden som GDPR och EU:s vägledning kring dataminimering och transparens. Inkludera även CISOs i styrningsgranskningar och kräva tydliga incidentplaybooks som täcker modellfel.

Praktiska steg inkluderar förproduktionstestning, runtime-övervakning, incidentplaybooks och definierade rollback-kriterier. Håll till exempel en förproduktion-dry-run som testar AI-modellen mot ett testkorpus som inkluderar kända skadliga samples, bullrig trafik och integritetskänsliga poster. Övervaka sedan drift för drift och noggrannhet, och schemalägg månadsvisa revisioner. Använd förklarbarhetsverktyg för att ge analytiker rationale bakom viktiga beslut. Sådana steg gör AI-drivna cybersäkerhetslösningar reviderbara och pålitliga.

Anamma en checklista för produktionsbruk: bekräfta åtkomstkontroller, implementera indata‑sanering, sätt retentionpolicyer och kräva signerade loggar för varje automatiserat steg. Spåra KPI:er som andel falska positiva, tid till innehållning och procentandel larm upplösta med mänsklig översyn. Förbered också en första 90‑dagars plan för varje AI‑utrullning: baslinjemått, sandlådetester, stegvis aktivering, utbildning och styrningssign-off. Detta tillvägagångssätt hjälper till att leverera proaktiv cybersäkerhet som kan upptäcka både kända och okända hot.

Avslutningsvis, balansera innovation med försiktighet. Avancerad AI och djupinlärning ger nya möjligheter till försvarares verktygslåda, men styrning håller dessa förmågor i linje med din säkerhetspostur. Om du behöver skala operationer utan att öka antalet anställda, utforska att automatisera repetitiva flöden som hantering av operativa e‑postmeddelanden; virtualworkforce.ai visar hur AI‑agenter kan minska handläggningstid och bibehålla kontext i eskalationer, vilket stödjer både produktivitet och säkerhetsmål hur du skalar logistiska operationer utan att anställa. Börja smått, mät effekten och iterera med tydliga styrregler.

FAQ

What is an AI assistant in cybersecurity?

En AI-assistent i cybersäkerhet är en automatiserad agent som hjälper till att övervaka, analysera och prioritera säkerhetshändelser. Den ger beslutsstöd, automatiserar rutinmässiga utredningsuppgifter och lyfter fram högkonfidenslarm för mänsklig granskning.

How do AI systems detect threats in real time?

AI-system tar in telemetri från endpoints, nätverk och moln, applicerar sedan modeller för att upptäcka avvikelser som indikerar kompromettering. De poängsätter händelser, grupperar relaterad aktivitet och höjer realtidslarm så att team kan agera snabbt.

Can AI reduce mean time to detect (MTTD)?

Ja. AI påskyndar triage genom att gruppera larm, sammanfatta bevis och föreslå playbook‑steg, vilket sänker MTTD. Dock måste team validera utdata för att undvika automatiseringsbias och falska positiva.

What is XDR and how does it use AI?

XDR står för extended detection and response och förenar signaler över endpoint, nätverk, moln och e‑post. XDR‑plattformar använder AI‑agenter och beteendemodeller för att korrelera händelser och föreslå innehållningsåtgärder.

Are AI recommendations always accurate?

Nej. Studier visar att AI‑utdata kan innehålla felaktigheter och källfel, så organisationer måste kräva proveniens, konfidenspoäng och mänsklig verifiering. Regelbundna revisioner och validering minskar risken för misstag.

How do you prevent AI from leaking sensitive data?

Begränsa modellåtkomst, använd in-/utfiltrering, föredra on‑premises eller privata modellalternativ för känsliga arbetsbelastningar och logga varje AI‑åtgärd. Datatillgångspolicys och retentionregler minskar också läckrisk.

What is automation bias and how does it affect security analysts?

Automatiseringsbias uppstår när analytiker övertro AI‑utdata och försummar oberoende verifiering. Det kan leda till missade avvikelser; utbildning, konfidenströsklar och obligatoriska verifieringssteg hjälper till att mildra detta.

How should organisations govern AI in security?

Styrning bör inkludera förproduktionstestning, kontinuerlig övervakning, förklarbarhet, provenienskontroller och stegvisa utrullningar. Anpassa dessa kontroller till regulatoriska krav som GDPR och interna efterlevnadsramverk.

Can AI help with email-related security and operations?

Ja. AI kan automatisera e‑posttriage, klassificera avsikt, bifoga kontext och utarbeta svar samtidigt som revisionsspår bevaras. Verktyg som grundar svar i ERP och dokumentsystem kan minska manuella uppslag och säkerhetsexponeringar. För exempel inom logistik‑epostautomation, se denna resurs om AI i fraktlogistikkommunikation.

What are the first steps to deploy an AI assistant safely?

Börja med en liten pilot, definiera KPI:er, utför modellvalidering och kräva människa‑i‑loopen‑godkännanden för åtgärder med stor påverkan. Förbered också rollback‑planer och utbilda analytiker i felhantering och verifieringsprocedurer.

Ready to revolutionize your workplace?

Achieve more with your existing team with Virtual Workforce.