ai cybersecurity: cum detectează asistenții AI amenințările în timp real

AI ajută ECHIPELE DE SECURITATE să detecteze anomalii și amenințări la scară largă, și o face continuu. De exemplu, un asistent AI poate monitoriza jurnalele, corela telemetria și genera o alertă în timp real atunci când tiparele corespund unei semnături cunoscute sau unei amprente comportamentale neobișnuite. Această capacitate este importantă deoarece 77% dintre companii folosesc sau explorează AI în operațiuni, ceea ce explică adoptarea puternică a AI în mediile enterprise Statistica de adopție de 77%. În practică, ingestia telemetriei ghidată de AI, extracția de caracteristici și clasificarea rulează de multe ori mai rapid decât revizuirea manuală. Fluxul pornește de obicei cu telemetrie → un model AI → trierea alertelor → răspuns. Un circuit simplu arată astfel: senzori alimentează date de la endpoint și rețea, modelul AI evaluează anomaliile, sistemul ridică o alertă, iar apoi containment-ul declanșează un playbook. Acest lucru este deosebit de util pentru detectarea amenințărilor în timp real, când minutele contează.

Instrumentele de securitate bazate pe AI alimentează deja multe pipeline-uri de detecție și răspuns. O revizuire a AI agentic menționează că AI agentic se poate adapta la amenințări emergente și poate acționa cu autonomie cognitivă atunci când este configurat să facă acest lucru AI agentic în securitatea cibernetică. Prin urmare, platformele care combină bazele comportamentale cu analiza streaming reduc timpul de persistență și evidențiază comportamente necunoscute. Într-un caz de utilizare scurt, sistemul detectează un tipar de mișcare laterală, emite o alertă, izolează endpointul și escaladează incidentul la SOC pentru revizuire. Acest circuit de containment automatizat economisește timp și reduce eroarea umană.

Arhitecții de securitate trebuie să decidă ce să automatizeze și ce să lase pentru analiști. Pentru monitorizarea în timp real, AI poate filtra zgomotul și prioritiza amenințările astfel încât echipele de securitate să se concentreze pe incidentele cu risc ridicat. În același timp, echipele ar trebui să solicite proveniență și scoruri de încredere pentru fiecare recomandare, pentru că studiile arată că output-urile AI pot include inexactități și eșecuri de atribuire a surselor care contează în contextul securității studiul privind eșecurile de atribuire a surselor. De asemenea, furnizorii oferă acum platforme de cybersecurity alimentate de AI care se integrează cu SIEM, EDR și fluxuri cloud, permițând un workflow rapid de detecție și răspuns în timp ce mențin oamenii în buclă pentru deciziile critice.

Pentru organizațiile care gestionează un volum mare de e‑mailuri, există și aplicații operaționale AI. De exemplu, virtualworkforce.ai folosește agenți AI pentru a automatiza ciclurile de viață ale e‑mailurilor pentru echipele de operațiuni, pentru a direcționa mesajele și pentru a atașa context escalărilor. Aceasta reduce timpul pierdut în triere și ajută echipele să mențină o poziție de securitate mai puternică în comunicații. Pe scurt, ai cybersecurity în acțiune detectează atât amenințările în timp real, cât și optimizează sarcina operațională care altfel ar putea distrage personalul SOC.

security operations: folosirea asistentului AI pentru a accelera detecția și remedierea

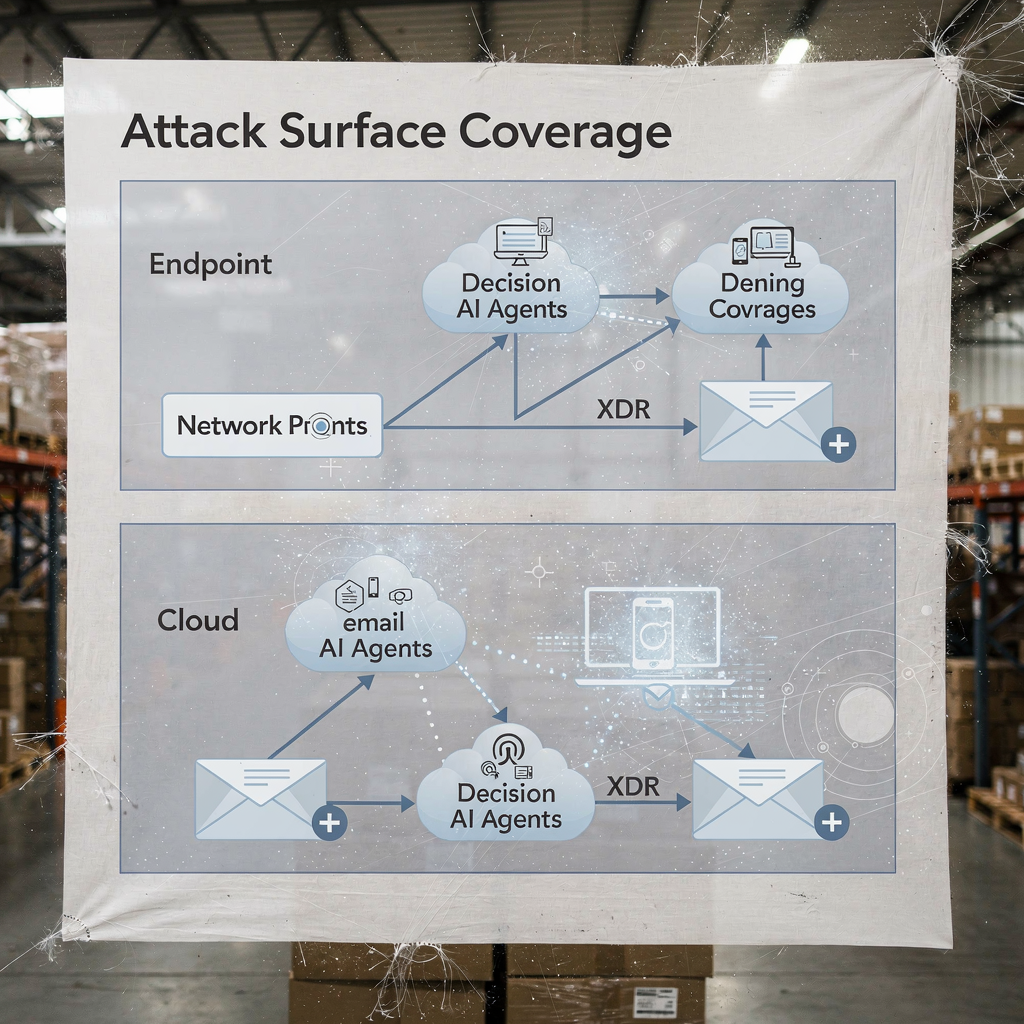

Operațiunile de securitate se bazează pe workflow‑uri rapide și repetabile. AI poate automatiza cronologii de investigație forensică, rula playbook‑uri și accelera remedierea în timp ce SOC păstrează controlul. De exemplu, integrările între XDR și SOAR permit unui motor de sugestii alimentat cu AI să propună pași de containment, iar apoi un inginer îi poate aproba sau suprascrie. Acest amestec de automatizare și supraveghere umană reduce timpul mediu până la detectare și timpul mediu până la remediere. De fapt, automatizarea reduce volumul de muncă al analiștilor și poate tăia ratele de false positive când corelațiile XDR filtrează semnalele zgomotoase.

Cazurile de utilizare arată beneficii practice. Un model AI poate parsa mii de alerte, grupa incidente similare și genera un sumar scurt pentru un analist. Apoi analistul decide dacă să escaladeze. Pentru cazurile uzuale de phishing, sistemul poate cwarantina mesajele și marca endpointurile afectate, iar apoi SOC revizuiește acțiunea automatizată. Această abordare ajută echipele SOC să se concentreze pe investigațiile care necesită judecată umană. De asemenea, automatizarea colectării dovezilor și construirea cronologiilor accelerează investigațiile și reduce riscul de indicatori ratați.

Echipele ar trebui să urmeze o listă de verificare pentru managementul schimbărilor înainte de a permite acțiuni automate. În primul rând, definiți praguri și scoruri de încredere. În al doilea rând, mapați playbook‑urile la roluri și aprobări. În al treilea rând, implementați monitorizare și rollback‑uri. În al patrulea rând, înregistrați fiecare pas automatizat pentru audibilitate. Acești pași ajută la protejarea mediului și la menținerea conformității. Un tablou de bord practic afișează sugestiile AI cu suprascrieri clare; acest lucru simplifică workflow‑ul și păstrează responsabilitatea.

Metricele de urmărit includ alertele triatate pe oră, rata de false positive și timpul până la containment. Aceste KPI‑uri demonstrează îmbunătățiri menținând echipele responsabile. De asemenea, SOC‑ul ar trebui să ruleze periodic teste de tip red‑team și incidente simulate pentru a valida modelul AI și a reduce biasul de automatizare în rândul analiștilor. Cercetările indică faptul că biasul de automatizare afectează o parte mare a profesioniștilor în securitate, motiv pentru care pașii obligatorii de verificare contează factorii umani și biasul de automatizare. În final, echipele ar trebui să documenteze când sistemul folosește AI pentru a escalada automat și când așteaptă aprobarea umană. Această politică clară ajută atât CISOs, cât și respondenții din prima linie.

Când operațiunile voastre includ fluxuri mari de e‑mailuri, luați în considerare combinarea automatizării de securitate cu platforme de automatizare a e‑mailurilor. virtualworkforce.ai ajută echipele să direcționeze și să rezolve e‑mailurile operaționale, reducând contexte zgomotoase care altfel irosesc timpul SOC. Pentru mai multe despre automatizarea corespondenței logistice, vedeți această resursă pe corespondență logistică automatizată.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

xdr and darktrace: exemple de AI agentic în detecția extinsă

Platformele de extended detection and response unifică semnalele din endpoint, rețea, cloud și e‑mail. XDR corelează aceste surse de telemetrie și aplică modele pentru a dezvălui căi de atac complexe. Darktrace oferă modelare comportamentală și funcții de AI agentic care se adaptează la bazele de referință în schimbare. În actualizările recente de produs, Darktrace a subliniat forensica autonomă și răspunsurile adaptive, unde platforma poate lua acțiuni de containment și genera raționamente lizibile de oameni pentru acei pași. Această abordare oferă echipelor o cale mai rapidă către detecție și răspuns pentru amenințările cunoscute și cele noi.

Un scenariu tipic începe cu un comportament anormal la endpoint care nu corespunde unei semnături cunoscute. XDR corelează acea acțiune cu fluxuri de rețea neobișnuite, iar platforma semnalează mișcarea laterală. Apoi o acțiune de containment izolează endpointul, în timp ce forensica automată capturează artefacte. Exemplele AI de la Darktrace arată cum machine learning poate cartografia acțiunile unui atacator prin dispozitive și apoi poate sugera un răspuns care izolează suprafața de atac. Acea secvență ajută la apărarea împotriva ransomware-ului și a propagării laterale.

Integrarea practică necesită o listă de verificare. În primul rând, asigurați‑vă că XDR se leagă de SIEM și SOAR pentru îmbogățirea evenimentelor. În al doilea rând, mapați playbook‑urile de răspuns pentru acțiuni automate versus manuale. În al treilea rând, configurați platforma să exporte context către ticketing și e‑mail, astfel încât echipele SOC să păstreze trasabilitate end‑to‑end. În al patrulea rând, testați handoff‑urile EDR‑to‑XDR și confirmați fidelitatea telemetriei. Un diagram stratificat al acoperirii XDR și al punctelor decizionale AI clarifică cine acționează și când.

Beneficiile XDR se extind la căi de lucru pentru securitatea cloud și securitatea e‑mailurilor. Platforma combină telemetria endpoint, fluxurile de rețea și threat intelligence pentru a crea o imagine mai largă a poziției de securitate a întreprinderii. În implementările care implică Darktrace, echipele de securitate pot vedea perspective asupra comportamentului atacatorului și opțiuni rapide de containment. Totuși, echipele ar trebui să valideze deciziile AI agentic prin audituri și să păstreze un jurnal al fiecărui pas executat autonom pentru guvernanță. Pentru organizațiile din logistică și operațiuni, integrarea insight‑urilor XDR cu automatizarea e‑mailurilor ajută la menținerea continuității în timp ce triatiți amenințările care sosesc prin phishing sau conturi compromise. Vezi cum AI poate scala comunicarea de transport și păstra contextul în mesajele operaționale IA pentru comunicarea cu expeditorii de mărfuri.

analyst: biasul de automatizare, limitele de acuratețe și AI folosit ca ajutor decizional

Factorii umani determină modul în care echipele adoptă AI. Biasul de automatizare și biasul de confirmare pot determina analiștii de securitate să aibă încredere excesivă în output‑urile AI. Studiile arată că biasul de automatizare afectează o mare parte dintre practicieni, iar analiștii trebuie să învețe să trateze AI ca un ajutor decizional, nu ca pe un oracol factorii umani în cybersecurity ghidată de AI. De asemenea, cercetările au constatat că multe răspunsuri generate de AI conțin inexactități și probleme de atribuire a surselor, ceea ce este critic în răspunsul la incidente unde încrederea în fapte contează eșecurile de atribuire ale asistenților AI. Prin urmare, liderii SOC ar trebui să adauge pași obligatorii de verificare și praguri de încredere pentru fiecare recomandare automatizată.

Instruirea joacă un rol major. Echipele ar trebui să ruleze exerciții pe scenarii, să efectueze teste red‑team și să solicite analiștilor să valideze dovezile înainte de a închide un incident. Un control practic este să prezentați proveniența pentru fiecare recomandare, astfel încât analiștii să poată urmări alertele înapoi la jurnalele brute și la stările modelului AI. De asemenea, introduceți proceduri de gestionare a erorilor care specifică ce se face când sistemul afișează încredere scăzută sau output‑uri inconsistente. Acest proces reduce riscul și păstrează implicarea umană în gândirea critică.

Transparența ajută, de asemenea. Prezentarea unui sumar al motivului pentru care a apărut o sugestie, semnalele care au susținut‑o și versiunea modelului care a generat‑o construiesc încredere. Pentru lucrul analitic care folosește rezumate în limbaj natural, etichetați‑le clar pentru a evita supraîncrederea. Deoarece AI este folosit pe scară largă acum, echipele trebuie să echilibreze viteza cu rigoarea. Utilizarea scorurilor de încredere și solicitarea semnării de către un analist pentru escaladări reduc automatizarea oarbă.

În final, feriți‑vă de shadow AI în echipe. Shadow AI apare când indivizii folosesc instrumente genai neautorizate sau servicii gen ai externe pentru răspunsuri rapide. Această practică poate scurge date sensibile și introduce logică inconsistentă în investigații. Stabiliți instrumente genai aprobate și un flux de lucru sigur pentru orice interogare externă sau apel de model. Oferiți analiștilor o cale clară de a escalada cazurile complexe. Pe scurt, AI ar trebui să împuternicească analistul, nu să înlocuiască judecata.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

vulnerabilități și date sensibile: AI pentru monitorizare, apărare și crearea de noi riscuri

AI ajută la găsirea vulnerabilităților și la apărarea datelor sensibile, însă introduce și riscuri cu dublă utilizare. Pe partea defensivă, AI pentru monitorizarea jurnalelor și a traficului web poate detecta tipare care indică încercări de exploatare a CVE‑urilor și apoi poate declanșa remedierea pentru a patch‑ui sau izola workload‑urile afectate. În același timp, actorii malițioși pot desfășura agenți AI pentru a automatiza recon‑ul, a crea phishing țintit și chiar a genera variante de malware. Articole despre amenințările emergente notează apariția angajaților AI automatizați sau malițioși care pot efectua inginerie socială internă amenințarea angajatului AI malițios. Această dualitate ridică mizele privind modul în care gestionați accesul la date sensibile.

Îngrijorările de confidențialitate apar când AI accesează jurnale care conțin PII sau secrete operaționale. Pentru a preveni scurgerile, aplicați politici stricte de acces la date, folosiți filtrare input/output și preferați implementările on‑premises sau modele private pentru workload‑uri cu sensibilitate ridicată. De asemenea, înregistrați toate acțiunile și interogările AI astfel încât să puteți reconstrui deciziile și să identificați orice eșire anormală de date. Pentru echipele care se ocupă de e‑mailuri operaționale, asigurarea că platformele de automatizare a e‑mailurilor aplică ancorare de date și guvernanță în ERP și sursele de documente previne divulgările accidentale. Explorați cum automatizarea e‑mailurilor păstrează contextul și reduce căutările manuale în fluxurile logistice automatizare e‑mail ERP pentru logistică.

Proiectați controale pentru a detecta activitatea AI malițioasă. Monitorizați volumele anormale de interogări și pattern‑urile neobișnuite care pot indica un instrument de descoperire automatizat sau un pipeline de exfiltrare. Implementați limitatoare și cote pentru interogările care accesează seturi mari de date. Efectuați threat hunting presupunând că atacatorii pot folosi AI generativ pentru a crea phishing polimorf și mesaje de inginerie socială plauzibile la scară. De asemenea, revizuiți output‑urile modelelor pentru halucinații sau afirmații nesusținute, deoarece eșecurile de atribuire a surselor pot induce analiștii în eroare și pot expune sistemele la pași de remediere incorecți.

În final, protejați modelele însele. Atacurile de tip model poisoning și data poisoning pot denatura modelele de învățare și reduce acuratețea detecțiilor. Validările periodice ale modelelor și verificările provenancei datelor ajută la detectarea timpurie a încercărilor de poisoning. Mențineți versiuni semnate ale modelelor și un plan de rollback pentru modele compromise sau degradate. Luate împreună, acești pași ajută la apărarea datelor sensibile în timp ce permiteți AI‑ului să monitorizeze și să protejeze sistemele eficient.

securitate AI și cybersecurity proactivă: guvernanță, validare și AI în fiecare etapă

Guvernanța rămâne fundația unei adoptări sigure a AI. Implementați validare a modelelor, testare continuă, explicabilitate și politici de viață‑a produsului înainte de rollout‑uri largi. Solicitați verificări de proveniență și atribuție a surselor, efectuați audituri periodice de acuratețe și folosiți rollout‑uri etapizate cu criterii de rollback. Aceste controale se aliniază cu obligațiile de reglementare precum GDPR și îndrumările UE privind minimizarea datelor și transparența. De asemenea, includeți CISOs în revizuirile de guvernanță și solicitați playbook‑uri clare de incident care acoperă eșecurile modelului.

Pașii practici includ testare pre‑implementare, monitorizare în runtime, playbook‑uri de incident și criterii definite de rollback. De exemplu, organizați o execuție de tip dry run înainte de punerea în producție care verifică modelul AI pe un corpus de test care include mostre cunoscute malițioase, trafic zgomotos și intrări sensibile din punct de vedere al confidențialității. Apoi monitorizați drift‑ul și acuratețea în producție și programați audituri lunare. Folosiți instrumente de explicabilitate pentru a oferi analiștilor rațiunea din spatele deciziilor cheie. Astfel de pași fac soluțiile de cybersecurity alimentate de AI auditable și demne de încredere.

Adoptați o listă de verificare pentru utilizarea în producție: confirmați controalele de acces, implementați sanitizarea inputurilor, stabiliți politici de retenție și solicitați jurnale semnate pentru fiecare acțiune automatizată. Urmăriți KPI‑uri precum rata de false positive, timpul până la containment și procentajul alertelor rezolvate cu supraveghere umană. De asemenea, pregătiți un roadmap pentru primele 90 de zile pentru orice implementare AI: metrici de bază, teste în sandbox, activare etapizată, instruire și semnătura de guvernanță. Această abordare ajută la livrarea unei cybersecurity proactive care poate detecta atât amenințările cunoscute, cât și cele necunoscute.

În final, echilibrați inovația cu prudența. AI avansat și deep learning aduc noi capabilități AI în arsenalul apărătorilor, dar guvernanța menține aceste capabilități aliniate cu postura voastră de securitate. Dacă trebuie să scalați operațiunile fără a adăuga personal, explorați automatizarea fluxurilor repetitive precum gestionarea e‑mailurilor operaționale; virtualworkforce.ai arată cum agenții AI pot reduce timpul de procesare și pot păstra contextul atașat escalărilor, ceea ce susține atât productivitatea, cât și obiectivele de securitate cum să îți extinzi operațiunile logistice fără a angaja personal. Începeți mic, măsurați impactul și iterați cu garduri clare.

FAQ

Ce este un asistent AI în securitatea cibernetică?

Un asistent AI în securitatea cibernetică este un agent automatizat care ajută la monitorizare, analiză și prioritizare a evenimentelor de securitate. Oferă suport decizional, automatizează sarcinile investigative de rutină și scoate în evidență alerte cu încredere ridicată pentru revizuire umană.

Cum detectează sistemele AI amenințările în timp real?

Sistemele AI ingestă telemetrie de la endpointuri, rețea și cloud, apoi aplică modele pentru a detecta anomalii care indică compromitere. Ele evaluează evenimentele, grupează activitățile conexe și ridică alerte în timp real pentru ca echipele să poată acționa rapid.

Poate AI reduce timpul mediu până la detectare (MTTD)?

Da. AI accelerează trierea prin gruparea alertelor, sintetizarea dovezilor și sugerarea pașilor din playbook, ceea ce scade MTTD. Totuși, echipele trebuie să valideze output‑urile pentru a evita biasul de automatizare și false positive‑urile.

Ce este XDR și cum folosește AI?

XDR înseamnă extended detection and response și unifică semnalele din endpoint, rețea, cloud și e‑mail. Platformele XDR folosesc agenți AI și modele comportamentale pentru a corela evenimentele și a sugera acțiuni de containment.

Sunt recomandările AI întotdeauna corecte?

Nu. Studiile arată că output‑urile AI pot include inexactități și eșecuri de atribuire a surselor, astfel încât organizațiile trebuie să solicite proveniență, scoruri de încredere și verificare umană. Auditurile și validările periodice reduc riscul unor acțiuni greșite.

Cum preveniți ca AI să scurgă date sensibile?

Limitați accesul la model, folosiți filtrare input/output, preferați opțiuni on‑premises sau modele private pentru workload‑uri sensibile și înregistrați fiecare acțiune AI. Politicile de acces la date și regulile de retenție reduc, de asemenea, riscul de scurgere.

Ce este biasul de automatizare și cum afectează analiștii de securitate?

Biasul de automatizare apare când analiștii au încredere excesivă în output‑urile AI și neglijează verificarea independentă. Poate cauza trecerea cu vederea a unor anomalii; instruirea, pragurile de încredere și pașii obligatorii de verificare ajută la atenuarea lui.

Cum ar trebui organizațiile să guverneze AI în securitate?

Guvernanța ar trebui să includă testare pre‑implementare, monitorizare continuă, explicabilitate, verificări de proveniență și rollout‑uri etapizate. Aliniați aceste controale cu cerințele de reglementare precum GDPR și cu cadrele interne de conformitate.

Poate AI ajuta la securitatea și operațiunile legate de e‑mail?

Da. AI poate automatiza trierea e‑mailurilor, clasifica intenția, atașa context și redacta răspunsuri păstrând înregistrări de audit. Instrumentele care ancorează răspunsurile în ERP și sisteme de documente pot reduce căutările manuale și expunerea la riscuri. Pentru exemple în automatizarea e‑mailurilor logistice, vedeți această resursă despre inteligența artificială în comunicarea logistice de mărfuri.

Care sunt primii pași pentru a implementa în siguranță un asistent AI?

Începeți cu un pilot mic, definiți KPI‑uri, efectuați validarea modelelor și solicitați aprobări umane în buclă pentru acțiuni cu impact ridicat. De asemenea, pregătiți planuri de rollback și instruiți analiștii în proceduri de gestionare a erorilor și verificare.

Ready to revolutionize your workplace?

Achieve more with your existing team with Virtual Workforce.