Como um copiloto de IA ajuda equipes de QA a automatizar a criação de testes (ia, qa, copiloto, criação de testes)

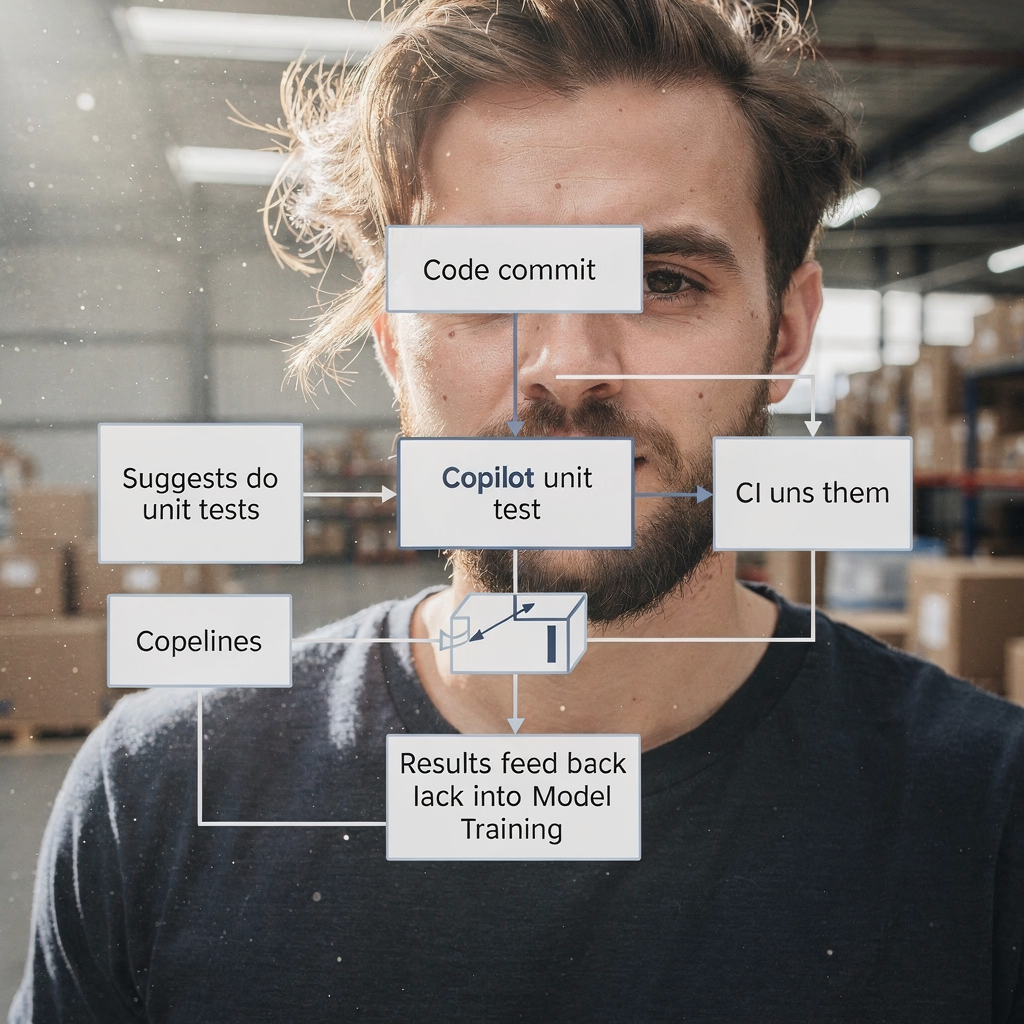

A IA ajuda a acelerar a CRIAÇÃO DE TESTES transformando requisitos, código e fluxos de usuário em rascunhos de testes utilizáveis. Primeiro, um copiloto lê histórias de usuário e diffs de código. Em seguida, ele propõe esboços de casos de teste, testes unitários e passos de UI. Para contexto, a Gartner prevê uma adoção rápida de assistentes de código para engenheiros; até 2028 três quartos dos engenheiros de software corporativos usarão assistentes de código com IA de acordo com reportagens do setor. Além disso, equipes que adotam um copiloto frequentemente reduzem o tempo da história até o teste automatizado.

Por exemplo, a IA pode rascunhar testes unitários semelhantes ao Diffblue, criar fluxos de UI como Testim ou Mabl e propor assertivas visuais semelhantes ao Applitools. Adicionalmente, podem ser produzidos testes em linguagem natural que leiam como critérios de aceitação, similar ao Functionize. Esses outputs variam de trechos curtos de casos de teste a scripts de teste completos. Para testes unitários, use um copiloto de IA para gerar exemplos em JUnit ou Playwright e depois refiná‑los. Para trabalho de UI, peça ao copiloto que exporte os passos para um framework de testes ou para código Playwright. Isso elimina trabalho repetitivo de script.

Meça o impacto com KPIs simples. Acompanhe o tempo até o primeiro teste automatizado e a porcentagem de aumento na cobertura de testes por sprint. Também acompanhe o número de rascunhos de cenários de teste criados por história de usuário. Uma ação rápida é executar um piloto de duas semanas que alimente três a seis histórias de usuário em um copiloto de IA e, então, comparar o rendimento de testes manual versus IA. Esse piloto pode mostrar ganhos de cobertura, revelar lacunas no tratamento de contexto do copiloto e demonstrar com que facilidade as equipes conseguem mapear os testes para o pipeline de CI.

Na prática, integre as sugestões do copiloto em um fluxo de trabalho de PR. Deixe o copiloto propor arquivos de teste no branch da feature. Depois, peça para um engenheiro de QA ou testador revisar os testes propostos. Isso reduz o tempo gasto com boilerplate. Por fim, as equipes entendem que um copiloto de IA acelera a autoria sem substituir o julgamento humano. Para leitura adicional sobre automação de mensagens operacionais e fluxos similares, veja nosso recurso sobre como dimensionar operações logísticas com agentes de IA.

Use ferramentas de teste com IA para automatizar o processo de QA e reduzir a manutenção de testes (ferramentas de teste com ia, automatizar, processo de qa, teste automatizado, self‑healing)

Ferramentas de teste com IA entregam localizadores self‑healing e recursos de identificação de elementos que reduzem dramaticamente a flaky‑ness. Por exemplo, ferramentas como Testim e Mabl adaptam seletores quando o DOM muda. Como resultado, as equipes gastam menos horas consertando scripts de teste frágeis. Além disso, essas ferramentas podem anotar diffs visuais, ajudando as verificações de regressão visual a permanecerem precisas. Use um executor de testes automatizado que suporte self‑healing para que o pipeline de testes permaneça confiável.

No entanto, a IA não elimina a necessidade de guardrails. Reveja testes atualizados automaticamente antes do release e mantenha um humano no loop. Um whitepaper recente afirma: “A IA pode suportar muitos aspectos de QA, mas também introduz riscos críticos que exigem atenção cuidadosa” de acordo com análises do setor. Portanto, mantenha portas de aprovação e integre logs de mudança. Use também telemetria para detectar quando o self‑healing pode ter alterado a intenção do teste.

Para implementar isso, integre a ferramenta de testes ao CI para que as atualizações rodem automaticamente em PRs. Depois, defina uma regra: mudanças self‑healed devem ser revistas dentro da janela de release. Acompanhe a redução de falhas intermitentes e as horas de manutenção por sprint como métricas de sucesso. Use dashboards para expor tendências e detectar regressões cedo. As equipes também podem automatizar o rollback de mudanças automáticas se o testador sinalizar regressões.

Na prática, combine self‑healing com governança leve. Mantenha execuções históricas de teste anonimizadas para treinamento do modelo. Conecte a ferramenta ao seu sistema de gestão de testes para que aprovações e comentários fiquem vinculados. Isso facilita auditar quem aceitou mudanças da IA. Para equipes que gerenciam fluxos pesados de e‑mail ou incidentes ticketizados, nossa plataforma mostra como ancorar ações de IA em dados operacionais e regras; veja nosso guia sobre automatizar e-mails logísticos com Google Workspace e virtualworkforce.ai. Finalmente, aceite que ferramentas de teste com IA reduzem manutenção, mas somente com checagens e balanços em vigor.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

Priorize testes com IA em QA: predição de defeitos, seleção de testes e ciclos de feedback (ia em qa, equipes de qa, ciclos de feedback, métrica, predição de defeitos)

A IA em QA pode prever onde defeitos têm maior probabilidade de aparecer. Usando histórico de commits, telemetria e defeitos passados, modelos de ML ranqueiam módulos de alto risco. Consequentemente, equipes de QA podem rodar suítes focadas nessas áreas em vez de em todo o sistema. Uma abordagem direcionada reduz defeitos escapados e acelera releases. Por exemplo, execute um smoke e uma regressão direcionada em um módulo sinalizado como de alto risco, e rode a regressão completa apenas quando necessário.

Estudos mostram que a predição de defeitos assistida por IA aumenta as taxas de detecção e permite que as equipes concentrem o esforço de teste escasso onde importa. Um relatório do setor destaca ganhos de produtividade com engenharia assistida por IA, ao mesmo tempo em que nota que melhorias de qualidade variam por equipe e configuração o relatório explica. Portanto, trate as saídas do modelo como guias, não como absolutos.

Configure CICLOS DE FEEDBACK contínuos de incidentes de produção de volta ao treinamento do modelo. Alimente telemetria anonimizadas e tags de incidentes no conjunto de treinamento. Depois, re‑treine periodicamente para manter a predição de risco alinhada com mudanças recentes. Acompanhe defeitos escapados em produção, taxa de falsos negativos e a porcentagem de testes ignorados por seleção baseada em risco. Use essas medidas para ajustar limiares e decidir quando expandir a suíte direcionada.

Além disso, envolva engenheiros de QA e equipes de QA ao ajustar modelos. Um engenheiro de QA deve validar sugestões do modelo e rotular falsos positivos. Essa colaboração melhora os modelos de IA. As equipes aprimoram sua habilidade de priorizar problemas mais rápido e entendem padrões que antes ficavam ocultos no ruído. Para organizações que gerenciam automações de e‑mail e processos operacionais, as mesmas ideias de ciclo de feedback ajudam a corrigir classificações incorretas; veja nossa explicação sobre como a virtualworkforce.ai reduz tempo de atendimento e fecha ciclos de feedback virtualworkforce.ai ROI e feedback.

Integre ferramentas de IA com a automação de testes e gestão de testes existentes (integrar ia, ferramenta de teste, ferramentas de qa, framework, automação de testes)

Para integrar IA em uma stack existente, adote padrões pragmáticos. Primeiro, adicione um copiloto de IA como assistente de desenvolvedor ou QA no repositório. Segundo, conecte a plataforma de testes ao seu sistema de gestão de testes e CI/CD. Terceiro, mapeie os outputs da IA para frameworks de teste existentes como Selenium, Playwright ou JUnit. Por exemplo, deixe o copiloto abrir PRs que adicionem testes Playwright e vinculá‑los ao ID do ticket correspondente.

Itens de checklist para integração incluem acesso ao codebase, execuções históricas de teste anonimizadas, telemetria e mapeamento de tags entre seu gerenciamento de testes e os outputs da IA. Esses metadados permitem que a IA recomende cenários de teste relevantes. Além disso, mantenha rastreabilidade: cada caso de teste gerado por IA deve apontar de volta para o requisito e para o PR que o introduziu. Isso melhora a auditabilidade e reduz testes duplicados.

Ganhas rápidos incluem habilitar o copiloto para propor testes como parte das checagens de pull‑request. Por exemplo, quando um PR altera um fluxo de pagamento, peça que a IA sugira cenários de teste relacionados e crie testes para testes funcionais e de regressão. Em seguida, os revisores podem aceitar ou refinar os scripts gerados. Isso mantém o fluxo rápido enquanto preserva a qualidade. Além disso, integre a ferramenta de testes ao dashboard para que stakeholders vejam cobertura e falhas em um só lugar.

Na prática, use um modelo de governança leve. Mantenha um backlog de automação de testes onde as mudanças propostas pela IA vão aterrissar. Depois, atribua um testador para validar. Isso evita deriva não verificada na suíte. Também garanta que seus frameworks de teste sejam compatíveis; por exemplo, setups modernos do Playwright aceitam código gerado com facilidade. Finalmente, ao integrar ferramentas de IA, verifique segurança, políticas de acesso a dados e conformidade. Se quiser ver como agentes de IA podem ser ancorados em dados operacionais, reveja nosso artigo sobre como escalar operações logísticas sem contratar.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

Casos de uso e soluções de QA: quem se beneficia e onde aplicar IA em QA (casos de uso, soluções de QA, QA de software, engenharia de qualidade, testador)

A IA beneficia muitos casos de uso ao longo do ciclo de vida de QA. Para codebases legadas, a IA pode gerar testes unitários para aumentar a cobertura rapidamente. Para suítes de regressão, a IA ajuda a manter testes de UI e API atualizados. Para testes exploratórios, a IA aumenta os testadores propondo casos de borda ou sequências de entrada incomuns. Para regressão visual, a IA ajuda a detectar sutis regressões de layout. Essas são soluções concretas de QA que as equipes podem implantar.

Públicos‑alvo incluem equipes de QA, engenheiros de QA e testadores. Testadores mudam do scripting rotineiro para design de cenários e engenharia de qualidade exploratória. Na prática, o papel do testador torna‑se mais estratégico. A automação de testes passa a ser uma colaboração entre julgamento humano e propostas de IA. Como resultado, as equipes podem focar em melhorar cenários de teste e análise de causa raiz.

Benefícios mensuráveis incluem tempo economizado por release, ganho de cobertura de testes e análise de causa raiz mais rápida. Para um piloto, escolha uma área crítica do produto, como um fluxo de pagamento. Aplique IA para criar testes automatizados nas camadas unit, API e UI. Depois meça os resultados antes e depois: tempo para criar testes, defeitos escapados e tempo de execução da suíte de regressão. Esse ensaio focado fornece ROI e aprendizado claros.

Considere também usar seleções de teste com IA para execuções noturnas a fim de reduzir custos. Note que as equipes ainda precisam avaliar modelos e vigiar vieses. Casos de uso incluem QA de software para sistemas financeiros, fluxos de checkout de e‑commerce e integrações B2B. Essas são áreas onde a precisão importa e onde a IA pode reduzir significativamente trabalho repetitivo. Finalmente, o futuro do QA incluirá mais assistência por IA, mas o papel humano em definir intenção e validar resultados continuará essencial.

Governança, limitações e seleção das principais ferramentas de QA com IA (com IA, ferramentas de IA, principais ferramentas com IA, chatgpt, machine learning, governança)

A IA traz tanto poder quanto riscos, então a governança importa. Limitações incluem viés do modelo, potencial excesso de dependência e a necessidade de manter modelos de ML ao longo do tempo. Um whitepaper alertou que organizações devem abordar preocupações éticas e operacionais ao adotar IA generativa em QA leia a análise. Portanto, implemente etapas de revisão humana, governança de dados e rastreabilidade.

Ao selecionar ferramentas alimentadas por IA, avalie acurácia do modelo, profundidade de integração com CI/CD e gestão de testes, qualidade do self‑healing e explicabilidade. Verifique também segurança e conformidade. Crie um rubric de aquisição de uma página que pontue fornecedores por integração, overhead de manutenção e ROI esperado. Por exemplo, candidatos a avaliar incluem Copilot/GitHub Copilot, Testim, Mabl, Diffblue, Functionize e Applitools. Pontue‑os em quão bem se mapeiam aos seus frameworks, como Playwright ou JUnit, e em como ajudam a manter testes automatizados.

Exija dos fornecedores demonstrações de como lidam com dados e como os modelos re‑treinam. Peça um plano de adoção de 90 dias com métricas de sucesso como ganho de cobertura, velocidade de testes e redução de defeitos escapados. Além disso, inclua um piloto que use um teste de IA em ambiente controlado. Durante o piloto, envolva equipes de QA, equipes de desenvolvimento e revisores de segurança. Essa revisão cross‑functional evita surpresas e garante que a ferramenta permita que as equipes mantenham o controle.

Por fim, tenha cuidado ao usar ferramentas como o chatgpt para ideação e trechos de código, mas separe‑as dos sistemas de produção. Para automação de produção, prefira ferramentas dedicadas de teste com IA que se liguem ao seu gerenciamento de testes e CI. Mantenha um ciclo contínuo de feedback para que incidentes de produção refinem o treinamento do modelo. Essa abordagem de governança garante que a IA torne‑se parte robusta dos seus esforços de gestão de qualidade minimizando riscos.

FAQ

O que é um copiloto de IA para QA?

Um copiloto de IA para QA é um assistente que propõe casos de teste, gera trechos de código e sugere scripts de teste com base em requisitos, código e telemetria. Ele acelera a autoria, mas um revisor humano deve validar os outputs antes do release.

Quão rápido as equipes conseguem ver valor a partir de um piloto de IA?

As equipes costumam ver valor inicial dentro de duas semanas de um piloto focado que alimente algumas histórias de usuário no copiloto. Isso revela economia de tempo, rendimento de rascunhos de testes e melhorias de cobertura.

Ferramentas de teste com IA removem testes flaky automaticamente?

Ferramentas de teste com IA podem reduzir flaky‑ness usando localizadores self‑healing e identificação de elementos mais inteligente. Entretanto, as equipes devem revisar mudanças automáticas e manter guardrails para evitar deriva.

Como priorizo testes com IA?

Use predição de defeitos baseada em ML que ranqueie módulos por risco usando histórico de commits e telemetria. Depois rode suítes direcionadas em áreas de alto risco e alimente incidentes de volta ao treinamento para melhoria contínua.

A IA pode gerar testes unitários para código legado?

Sim, a IA pode gerar testes unitários que aumentem a cobertura para código legado. As equipes devem revisar os testes gerados e integrá‑los ao pipeline de CI para garantir estabilidade.

Que governança é necessária para IA em QA?

Governança requer revisão humana, controles de acesso a dados, logs de auditoria e políticas de re‑treinamento para modelos de IA. Esses elementos reduzem vieses, garantem rastreabilidade e mantêm a qualidade ao longo do tempo.

Quais ferramentas devo avaliar primeiro?

Comece por fornecedores que se integrem ao seu CI e gestão de testes. Considere o Copilot/GitHub Copilot para trechos de código e avalie Testim, Mabl, Diffblue, Functionize e Applitools para automação mais completa.

Como IA e QA tradicional trabalham juntas?

A IA complementa o QA tradicional assumindo tarefas repetitivas, propondo cenários de teste e mantendo suítes atualizadas. Testadores humanos focam em testes exploratórios, validação e design de cenários.

O chatgpt é útil para geração de testes?

O ChatGPT pode idear e rascunhar cenários de teste, mas testes de produção devem vir de ferramentas que se conectem diretamente ao CI e gestão de testes para rastreabilidade e reprodutibilidade.

Como devo medir o sucesso de um rollout de IA em QA?

Meça ganho de cobertura, velocidade de criação de testes, redução de horas de manutenção e defeitos escapados em produção. Use essas métricas para iterar sobre ferramentas e planos de governança.

Ready to revolutionize your workplace?

Achieve more with your existing team with Virtual Workforce.