Come un copilot AI aiuta i team QA ad automatizzare la creazione dei test (ai, qa, copilot, creazione di test)

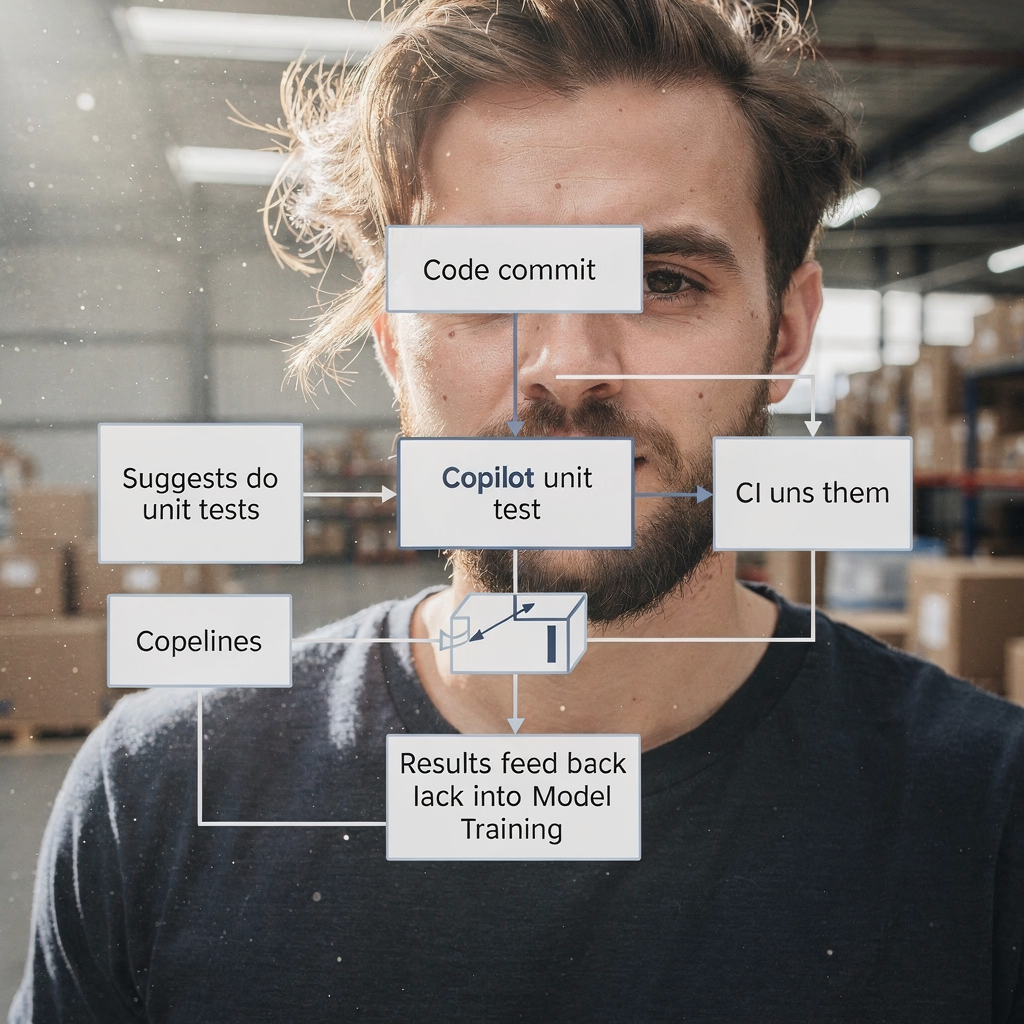

L’AI accelera la CREAZIONE DEI TEST trasformando requisiti, codice e flussi utente in bozze di test utilizzabili. Innanzitutto, un copilot legge user story e diff del codice. Poi propone outline di casi di test, test unitari e passaggi UI. Per contesto, Gartner prevede un rapido aumento dell’adozione di assistenti di codice per gli ingegneri; entro il 2028 tre quarti degli ingegneri del software aziendale useranno assistenti di codice basati su AI secondo i report del settore. Inoltre, i team che adottano un copilot spesso riducono il tempo dalla story al test automatizzato.

Ad esempio, l’AI può redigere test unitari simili a Diffblue, creare flussi UI come Testim o Mabl e proporre assertion visive simili ad Applitools. Inoltre, possono essere prodotti test in linguaggio naturale che leggono come criteri di accettazione, simili a Functionize. Questi output vanno da brevi snippet di casi di test a script di test completi. Per il testing unitario, usa un copilot AI per generare esempi JUnit o Playwright e poi raffinarli. Per il lavoro UI, chiedi al copilot di esportare i passaggi in un framework di testing o in codice Playwright. Questo elimina il lavoro ripetitivo di scripting.

Misura l’impatto con KPI semplici. Monitora il tempo al primo test automatizzato e la percentuale di aumento della copertura dei test per sprint. Traccia anche il numero di bozze di scenario di test create per user story. Un’azione rapida è eseguire un pilota di due settimane che alimenti tre‑sei user story in un copilot AI, e poi confrontare il rendimento dei test manuali rispetto a quelli generati dall’AI. Questo pilota può mostrare guadagni di copertura, rivelare lacune nella gestione del contesto del copilot e mostrare quanto facilmente i team possono mappare i test nella pipeline CI.

Praticamente, integra i suggerimenti del copilot in un workflow di PR. Lascia che il copilot proponga file di test sul branch della feature. Poi un ingegnere QA o un tester rivede i test proposti. Questo riduce il tempo speso sul boilerplate. Infine, i team capiscono che un copilot AI velocizza la scrittura senza sostituire il giudizio umano. Per approfondire l’automazione dei messaggi operativi e workflow simili, vedi la nostra risorsa su come scalare le operazioni logistiche con agenti di intelligenza artificiale.

Usa strumenti di testing AI per automatizzare il processo QA e ridurre la manutenzione dei test (ai testing tools, automate, qa process, automated test, self‑healing)

Gli strumenti di testing AI offrono locator self‑healing e funzionalità di identificazione degli elementi che riducono drasticamente la flakiness. Per esempio, strumenti come Testim e Mabl adattano i selettori quando il DOM cambia. Di conseguenza, i team passano meno ore a correggere script di test fragili. Inoltre, questi strumenti possono annotare le differenze visive, aiutando i controlli di regression visiva a rimanere accurati. Usa un runner di test automatizzato che supporti il self‑healing in modo che la pipeline di testing resti affidabile.

Tuttavia, l’AI non elimina la necessità di guardrail. Revisiona i test aggiornati automaticamente prima del rilascio e mantieni un umano nel loop. Un recente whitepaper afferma: “L’AI può supportare molti aspetti della QA, ma introduce anche rischi critici che richiedono attenzione” secondo l’analisi del settore. Pertanto, mantieni gate di approvazione e integra change log. Usa inoltre la telemetria per rilevare quando il self‑healing potrebbe aver spostato l’intento del test.

Per implementare questo, integra lo strumento di testing nella CI in modo che gli aggiornamenti vengano eseguiti automaticamente sulle PR. Poi stabilisci una regola: le modifiche self‑healed devono essere revisionate entro la finestra di rilascio. Monitora la riduzione dei fallimenti flakies e le ore di manutenzione per sprint come metriche di successo. Usa dashboard per mettere in evidenza le tendenze e scovare regressioni precocemente. I team possono anche automatizzare il rollback delle modifiche automatiche se il tester segnala regressioni.

In pratica, combina il self‑healing con una governance leggera. Conserva esecuzioni storiche dei test anonimizzate per l’addestramento del modello. Collega lo strumento al tuo sistema di gestione dei test così approvazioni e commenti restano collegati. Questo facilita l’audit su chi ha accettato le modifiche AI. Per i team che gestiscono flussi email intensi o incidenti ticketizzati, la nostra piattaforma mostra come ancorare le azioni AI a dati e regole operative; vedi la nostra guida su automatizzare le email logistiche con Google Workspace e virtualworkforce.ai. Infine, accetta che gli strumenti di testing AI riducono la manutenzione, ma solo con controlli e bilanciamenti in atto.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

Prioritizza i test con l’AI in QA: predizione dei difetti, selezione dei test e feedback loop (ai in qa, qa teams, feedback loops, metric, defect prediction)

L’AI in QA può prevedere dove è più probabile che si verifichino difetti. Utilizzando la storia dei commit, la telemetria e i difetti passati, i modelli ML classificano i moduli ad alto rischio. Di conseguenza, i team QA possono eseguire suite focalizzate su quelle aree invece che ovunque. Un approccio mirato riduce i difetti sfuggiti e accelera i rilasci. Per esempio, esegui uno smoke e una regressione mirata su un modulo segnalato ad alto rischio, ed esegui la regressione completa solo se necessario.

Gli studi dimostrano che la predizione dei difetti assistita dall’AI aumenta i tassi di rilevamento e permette ai team di concentrare lo sforzo di testing scarso dove conta. Un report del settore evidenzia i guadagni di produttività dall’ingegneria assistita dall’AI, pur osservando che i miglioramenti della qualità variano per team e configurazione il rapporto spiega. Pertanto, considera le uscite del modello come indicazioni, non come verità assolute.

Imposta FEEDBACK LOOP continui dagli incidenti di produzione al training del modello. Alimenta set di addestramento con telemetria anonimizzata e tag degli incidenti. Poi riaddestra periodicamente per mantenere la predizione del rischio allineata ai cambiamenti recenti. Monitora i difetti sfuggiti in produzione, il tasso di falsi negativi e la percentuale di test saltati tramite selezione basata sul rischio. Usa queste misure per tarare le soglie e decidere quando espandere la suite mirata.

Coinvolgi inoltre gli ingegneri QA e i team QA nella messa a punto dei modelli. Un ingegnere QA dovrebbe validare i suggerimenti del modello e etichettare i falsi positivi. Questa collaborazione migliora i modelli AI. I team migliorano la capacità di triage degli issue più rapidamente e comprendono pattern che prima restavano nascosti nel rumore. Per le organizzazioni che gestiscono email operative e automazioni di processo, le stesse idee di feedback loop aiutano a correggere le false classificazioni; vedi la nostra spiegazione su come virtualworkforce.ai riduce i tempi di gestione e chiude i cicli di feedback.

Integra gli strumenti AI con l’automazione dei test esistente e la gestione dei test (integrate ai, testing tool, qa tools, framework, test automation)

Per integrare l’AI in uno stack esistente, adotta pattern pragmatici. Primo, aggiungi un copilot AI come assistente per sviluppatori o QA nel repository. Secondo, collega la piattaforma di testing al tuo sistema di gestione dei test e alla CI/CD. Terzo, mappa gli output AI ai framework di testing esistenti come Selenium, Playwright o JUnit. Per esempio, lascia che il copilot apra PR che aggiungono test Playwright e li colleghi all’ID del ticket corrispondente.

Gli elementi della checklist per l’integrazione includono accesso al codebase, esecuzioni storiche dei test anonimizzate, telemetria e mappatura dei tag tra il tuo sistema di gestione dei test e gli output AI. Questi metadati permettono all’AI di raccomandare scenari di test rilevanti. Mantieni inoltre la tracciabilità: ogni caso di test generato dall’AI dovrebbe rimandare al requisito e alla PR che lo ha introdotto. Questo migliora l’auditabilità e riduce i test duplicati.

I quick win includono abilitare il copilot a proporre test come parte dei controlli delle pull‑request. Per esempio, quando una PR modifica un flusso di pagamento, fai in modo che l’AI suggerisca scenari di test correlati e crei test per il functional testing e la regression testing. Poi i revisori possono accettare o affinare gli script di test generati. Questo mantiene il workflow veloce pur preservando la qualità. Inoltre, integra lo strumento di testing con la dashboard così gli stakeholder vedono copertura e fallimenti in un unico posto.

Praticamente, usa un modello di governance leggero. Mantieni un backlog di automazione dei test dove atterrano le modifiche proposte dall’AI. Poi assegna un tester per la convalida. Così si evita una deriva incontrollata della suite. Inoltre, assicurati che i tuoi framework di testing siano compatibili; per esempio, le moderne configurazioni Playwright accettano facilmente codice generato. Infine, quando integri strumenti AI, verifica la sicurezza, le policy di accesso ai dati e la conformità. Se vuoi vedere come gli agenti AI possono essere ancorati ai dati operativi, consulta il nostro articolo su come scalare le operazioni logistiche senza assumere personale.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

Casi d’uso e soluzioni QA: chi beneficia e dove applicare l’AI in QA (use cases, qa solutions, software qa, quality engineering, tester)

L’AI avvantaggia molti casi d’uso lungo il ciclo di vita della QA. Per codebase legacy, l’AI può generare test unitari per aumentare rapidamente la copertura. Per le suite di regressione, l’AI aiuta a mantenere aggiornati test UI e API. Per il testing esplorativo, l’AI integra i tester proponendo edge case o sequenze di input non usuali. Per la regression visiva, l’AI aiuta a rilevare sottili regressioni del layout. Queste sono soluzioni QA concrete che i team possono adottare.

I pubblici target includono team QA, ingegneri QA e tester. I tester passano dallo scripting di routine alla progettazione di scenari e all’engineering della qualità esplorativa. Nella pratica, il ruolo del tester diventa più strategico. L’automazione dei test diventa una collaborazione tra giudizio umano e proposte AI. Di conseguenza, i team possono concentrarsi sul miglioramento degli scenari di test e sull’analisi delle cause profonde.

I benefici misurabili includono tempo risparmiato per rilascio, aumento della copertura dei test e analisi delle cause profonde più rapida. Per un pilota, scegli un’area prodotto critica come un flusso di pagamento. Applica l’AI per creare test automatizzati per i livelli unit, API e UI. Poi misura i risultati prima e dopo: tempo per creare i test, difetti sfuggiti e tempo di esecuzione dei test di regressione. Questa prova mirata fornisce ROI e apprendimento chiari.

Considera inoltre l’uso di selezioni di test alimentate dall’AI per i run notturni per ridurre i costi. Nota che i team devono comunque valutare i modelli e vigilare sui bias. I casi d’uso includono QA software per sistemi finanziari, flussi di checkout e‑commerce e integrazioni B2B. Sono aree dove l’accuratezza conta e dove l’AI può ridurre significativamente il lavoro ripetitivo. Infine, il futuro della QA includerà più assistenza AI, ma il ruolo umano nel definire l’intento e nel validare i risultati rimarrà essenziale.

Governance, limitazioni e selezione dei migliori strumenti QA potenziati dall’AI (ai-powered, ai tools, top ai-powered, chatgpt, machine learning, governance)

L’AI introduce sia potenza che rischi, quindi la governance è importante. Le limitazioni includono bias dei modelli, possibile eccessiva dipendenza e la necessità di mantenere i modelli ML nel tempo. Un whitepaper ha avvertito che le organizzazioni devono affrontare questioni etiche e operative quando adottano AI generativa nella QA leggi l’analisi. Pertanto, implementa passaggi di revisione umana, governance dei dati e tracciabilità.

Quando selezioni strumenti AI, valuta l’accuratezza del modello, la profondità di integrazione con CI/CD e gestione dei test, la qualità del self‑healing e l’esplicabilità. Verifica anche la sicurezza e la conformità. Crea una rubrica di procurement in una pagina che valuti i vendor per integrazione, overhead di manutenzione e ROI atteso. Per esempio, candidati da valutare includono Copilot/GitHub Copilot, Testim, Mabl, Diffblue, Functionize e Applitools. Valutali su quanto si integrano nei tuoi framework, come Playwright o JUnit, e su come aiutano a mantenere i test automatizzati.

Richiedi inoltre ai vendor di mostrare come gestiscono i dati e come i modelli vengono riaddestrati. Chiedi un piano di adozione a 90 giorni con metriche di successo come guadagno di copertura, velocità di test e riduzione dei difetti sfuggiti. Includi anche un pilota che utilizzi un test AI in un ambiente controllato. Durante il pilota, coinvolgi team QA, team di sviluppo e revisori di sicurezza. Questa revisione cross‑funzionale evita sorprese e garantisce che lo strumento permetta ai team di mantenere il controllo.

Infine, presta attenzione a strumenti come chatgpt per l’ideazione e gli snippet di codice, ma separali dai sistemi di produzione. Per l’automazione di classe produzione, preferisci strumenti di testing AI dedicati che si colleghino al tuo test management e alla CI per tracciabilità e riproducibilità. Mantieni un feedback loop continuo così gli incidenti di produzione affinano il training dei modelli. Questo approccio di governance garantisce che l’AI diventi parte robusta della gestione della qualità riducendo al minimo i rischi.

FAQ

What is an AI copilot for QA?

Un copilot AI per la QA è un assistente che propone casi di test, genera snippet di codice e suggerisce script di test basati su requisiti, codice e telemetria. Accelera la scrittura, ma un revisore umano dovrebbe convalidare gli output prima del rilascio.

How quickly can teams see value from an AI pilot?

I team spesso vedono valore iniziale entro due settimane da un pilota mirato che alimenta alcune user story nel copilot. Questo rivela risparmi di tempo, resa delle bozze di test e miglioramenti della copertura.

Do AI testing tools remove flaky tests automatically?

Gli strumenti di testing AI possono ridurre la flakiness usando locator self‑healing e identificazione più intelligente degli elementi. Tuttavia, i team devono revisionare le modifiche automatiche e mantenere guardrail per prevenire deriva.

How do I prioritise tests with AI?

Usa la predizione dei difetti basata su ML che classifica i moduli per rischio usando la storia dei commit e la telemetria. Poi esegui suite mirate sulle aree ad alto rischio e alimenta gli incidenti nel training per il miglioramento continuo.

Can AI generate unit tests for legacy code?

Sì, l’AI può generare test unitari per aumentare la copertura su codice legacy. I team dovrebbero revisionare i test generati e integrarli nella pipeline CI per garantirne la stabilità.

What governance is needed for AI in QA?

La governance richiede revisione umana, controlli di accesso ai dati, log di audit e policy di riaddestramento per i modelli AI. Questi elementi riducono il bias, garantiscono tracciabilità e mantengono la qualità nel tempo.

Which tools should I evaluate first?

Inizia con vendor che si integrano con la tua CI e il test management. Considera Copilot/GitHub Copilot per gli snippet e valuta Testim, Mabl, Diffblue, Functionize e Applitools per automazione più completa.

How do AI and traditional QA work together?

L’AI integra la QA tradizionale assumendosi compiti ripetitivi, proponendo scenari di test e mantenendo aggiornate le suite. I tester umani si concentrano su testing esplorativo, convalida e progettazione degli scenari.

Is chatgpt useful for test generation?

ChatGPT può ideare e redigere scenari di test, ma i test di produzione dovrebbero provenire da strumenti che si collegano direttamente a CI e gestione test per tracciabilità e riproducibilità.

How should I measure success for an AI QA rollout?

Misura guadagno di copertura, velocità di test, riduzione delle ore di manutenzione e difetti sfuggiti in produzione. Usa queste metriche per iterare su strumenti e piani di governance.

Ready to revolutionize your workplace?

Achieve more with your existing team with Virtual Workforce.