Hvordan en AI‑copilot hjælper QA‑teams med at automatisere testoprettelse (ai, qa, copilot, testoprettelse)

AI hjælper med at accelerere TESTOPRETTELSE ved at omdanne krav, kode og brugerflows til brugbare testudkast. Først læser en copilot brugerhistorier og kode‑diffs. Dernæst foreslår den skitser til testcases, unit‑tests og UI‑trin. Til orientering forudser Gartner en hurtig udbredelse af kodeassistenter til udviklere; inden 2028 vil tre fjerdedele af virksomheders softwareingeniører bruge AI‑kodeassistenter ifølge branche‑rapportering. Desuden forkorter teams, der tager en copilot i brug, ofte tiden fra story til automatiseret test.

For eksempel kan AI udarbejde unit‑tests svarende til Diffblue, skabe UI‑flows som Testim eller Mabl og foreslå visuelle assertioner à la Applitools. Derudover kan naturligt sprogede tests, der læses som acceptkriterier, produceres, ligesom Functionize. Disse output spænder fra korte testcasesnippets til komplette testskripter. Til unit‑testning kan du bruge en AI‑copilot til at generere JUnit‑ eller Playwright‑eksempler og derefter raffinere dem. Til UI‑arbejde bed copiloten om at eksportere trin til et testframework eller som Playwright‑kode. Det fjerner gentaget scriptarbejde.

Mål effekten med enkle KPI’er. Spor tiden til første automatiserede test og procentvis stigning i testdækning per sprint. Spor også antallet af testscenarieudkast oprettet per brugerhistorie. Et hurtigt handlingsforslag er at køre et to‑ugers pilotprojekt, der fodrer tre til seks brugerhistorier ind i en AI‑copilot, og derefter sammenligne manuel versus AI‑testudbytte. Denne pilot kan vise dækningstilvækst, afsløre huller i copilottens kontekstforståelse og vise, hvor let teams kan mappe tests ind i CI‑pipen.

Praktisk integreres copilottens forslag i en PR‑workflow. Lad copiloten foreslå testfiler på feature‑branch’en. Lad derefter en QA‑ingeniør eller tester gennemgå de foreslåede tests. Det reducerer tiden brugt på boilerplate. Endelig forstår teams, at en AI‑copilot hurtiggør forfatning uden at erstatte menneskelig dømmekraft. For yderligere læsning om automatisering af driftsmeddelelser og lignende workflows, se vores ressource om, hvordan du opskalerer logistikoperationer med AI‑agenter Sådan skalerer du logistikoperationer med AI‑agenter.

Brug AI‑testværktøjer til at automatisere QA‑processen og reducere testvedligeholdelse (ai testværktøjer, automatisere, qa‑proces, automatiseret test, selvhelende)

AI‑testværktøjer leverer selvhelende lokatorer og elementidentifikationsfunktioner, der drastisk reducerer flakiness. For eksempel tilpasser værktøjer som Testim og Mabl selektorer, når DOM’en ændres. Som følge heraf bruger teams færre timer på at rette skrøbelige testskripter. Disse værktøjer kan også annotere visuelle diffs, hvilket hjælper visuelle regressionskontroller med at forblive præcise. Brug en automatiseret testrunner, der understøtter selvhelende funktioner, så testpipen forbliver pålidelig.

Dog fjerner AI ikke behovet for styringsmekanismer. Gennemgå automatisk opdaterede tests før frigivelse og behold et menneske i løkken. Et nyligt whitepaper konstaterer, “AI kan understøtte mange aspekter af QA, men det introducerer også kritiske risici, der kræver omhyggelig opmærksomhed” ifølge brancheanalysen. Derfor oprethold godkendelsesporte og integrer ændringslogs. Brug også telemetry til at opdage, hvornår selvhelende ændringer kan have ændret testintentionen.

For at implementere dette, integrer testværktøjet i CI, så opdateringer kører automatisk på PR’er. Sæt derefter en regel: selvhelende ændringer skal gennemgås inden for frigivelsesvinduet. Mål reduktion i ustabile fejl og vedligeholdelsestimer per sprint som succeskriterier. Brug dashboards til at synliggøre tendenser og fange regressioner tidligt. Teams kan også automatisere rollback af auto‑ændringer, hvis testeren markerer regressioner.

I praksis kombineres selvhelende funktioner med letvægtsstyring. Gem anonymiserede historiske testruns til modeltræning. Forbind værktøjet til dit teststyringssystem, så godkendelser og kommentarer forbliver knyttet. Det gør det lettere at revidere, hvem der accepterede AI‑ændringer. For teams, der håndterer tunge e‑mail‑workflows eller ticket‑sager, viser vores platform, hvordan man forankrer AI‑handlinger i operationelle data og regler; se vores guide om at automatisere logistik‑e‑mails med Google Workspace og virtualworkforce.ai Automatisere logistik‑e‑mails med Google Workspace og virtualworkforce.ai. Endelig accepter, at AI‑testværktøjer reducerer vedligeholdelse, men kun med de rette kontrolmekanismer.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

Prioriter testning med AI i QA: defektforudsigelse, testudvælgelse og feedback‑loops (ai i qa, qa‑teams, feedback‑loops, måling, defektforudsigelse)

AI i QA kan forudsige, hvor fejl sandsynligvis vil opstå. Ved brug af commit‑historik, telemetry og tidligere fejl rangerer ML‑modeller højrisikomoduler. Følgelig kan QA‑teams køre fokuserede testsuiter på disse områder i stedet for overalt. En målrettet tilgang reducerer undslupne fejl og fremskynder frigivelser. For eksempel kør en smoke‑test og en målrettet regression på et modul markeret som højrisiko, og kør fuld regression kun efter behov.

Studier viser, at AI‑assisteret defektforudsigelse øger detektionsrater og lader teams fokusere knappe testressourcer der, hvor det betyder mest. En branche‑rapport fremhæver produktivitetsgevinster fra AI‑assisteret engineering, samtidig med at den bemærker, at kvalitetsforbedringer varierer mellem teams og opsætninger; rapporten forklarer. Derfor bør modeloutput behandles som vejledninger, ikke absolutte sandheder.

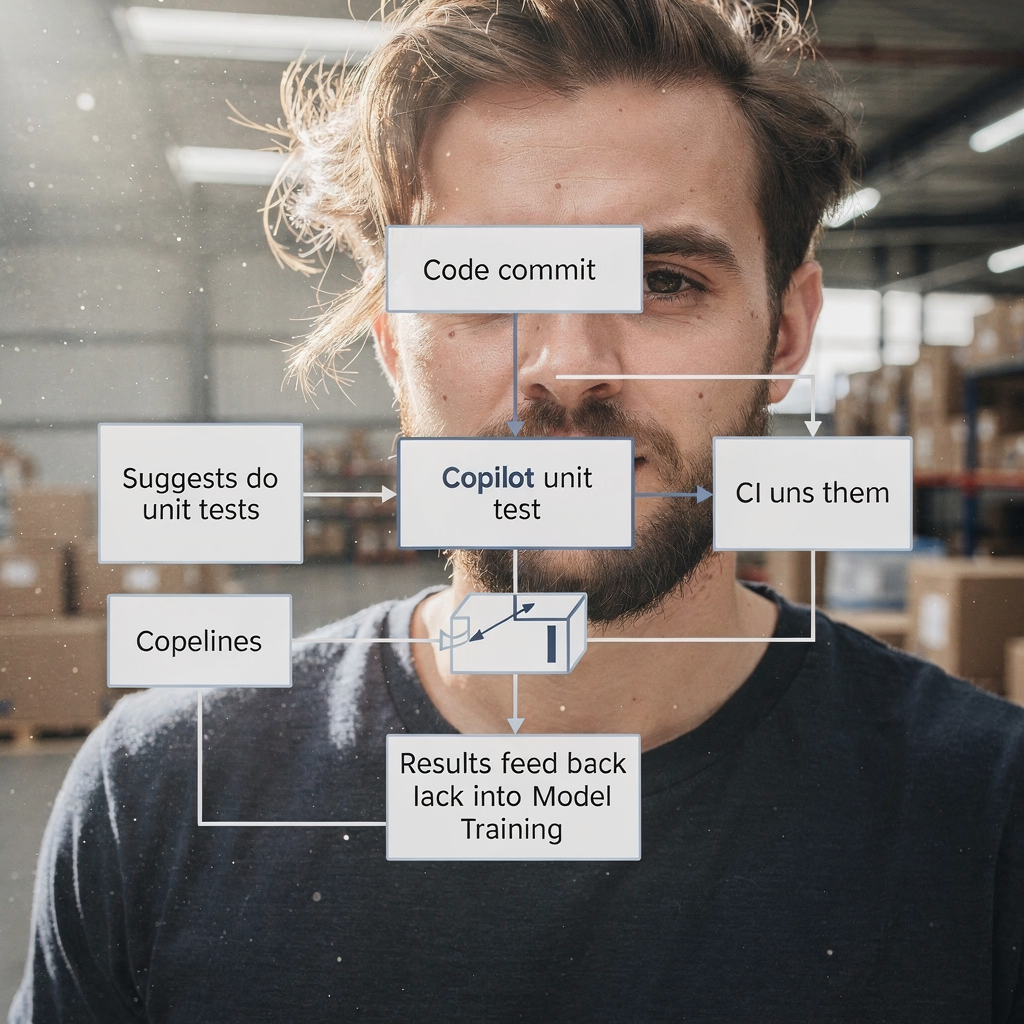

Opret løbende FEEDBACK‑LOOPS fra produktionsincidenter tilbage i modeltræningen. Tilfør anonymiseret telemetry og incident‑tags til træningssættet. Retræn derefter periodisk for at holde risikoforudsigelsen ajour med de seneste ændringer. Spor undslupne fejl i produktion, falsk negativ‑rate og procentdelen af tests sprunget over via risikobaseret udvælgelse. Brug disse målinger til at justere tærskler og til at beslutte, hvornår den målrettede suite skal udvides.

Involver også QA‑ingeniører og QA‑teams, når modeller skal tunes. En QA‑ingeniør bør validere modelforslag og mærke falske positiver. Dette samarbejde forbedrer AI‑modellerne. Teams forbedrer deres evne til at triagere problemer hurtigere, og de forstår mønstre, der tidligere gemte sig i støj. For organisationer, der håndterer operationelle e‑mails og procesautomatiseringer, hjælper de samme feedback‑loop‑ideer med at rette falske klassifikationer; se vores forklaring på, hvordan virtualworkforce.ai reducerer behandlingstid og lukker feedback‑cyklusser virtualworkforce.ai ROI og feedback.

Integrer AI‑værktøjer med eksisterende testautomatisering og teststyring (integrer ai, testing tool, qa‑værktøjer, framework, testautomatisering)

For at integrere AI i en eksisterende stack, anvend pragmatiske mønstre. Først tilføj en AI‑copilot som udvikler‑ eller QA‑assistent i repositoryet. For det andet, forbind testplatformen til dit teststyringssystem og CI/CD. For det tredje, kortlæg AI‑output til eksisterende testframeworks som Selenium, Playwright eller JUnit. For eksempel lad copiloten oprette PR’er, der tilføjer Playwright‑tests og linke dem til den tilsvarende ticket‑ID.

Checklisteelementer til integration inkluderer adgang til kodebasen, anonymiserede historiske testruns, telemetry og tag‑mapping mellem dit teststyringssystem og AI‑output. Disse metadata gør det muligt for AI at anbefale relevante testscenarier. Oprethold også sporbarhed: hver AI‑genereret testcase bør pege tilbage på kravet og den PR, der indførte den. Det forbedrer auditabilitet og mindsker duplikerede tests.

Hurtige gevinster inkluderer at lade copiloten foreslå tests som en del af pull‑request‑checks. For eksempel, når en PR ændrer en betalingsflow, lad AI’en foreslå relaterede testscenarier og oprette tests til funktionel test og regressionstest. Så kan reviewere acceptere eller raffinere de genererede testskripter. Det holder workflow’en hurtig samtidig med at kvalitet bevares. Integrer desuden testværktøjet med dashboardet, så interessenter ser dækning og fejl ét sted.

Praktisk, brug en letvægtsstyringsmodel. Vedligehold en testautomatiseringsbacklog, hvor foreslåede AI‑ændringer lander. Tildel derefter en tester til at validere. Derved undgås ukontrolleret drift i suiten. Sørg også for, at dine testframeworks er kompatible; for eksempel accepterer moderne Playwright‑opsætninger nemt genereret kode. Endelig, når du integrerer AI‑værktøjer, tjek sikkerhed, datapolitikker og compliance. Hvis du vil se, hvordan AI‑agenter kan forankres i operationelle data, gennemgå vores artikel om, hvordan du opskalerer logistikoperationer uden at ansætte personale Sådan opskalerer du logistikoperationer uden at ansætte personale.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

Use cases og QA‑løsninger: hvem profiterer, og hvor anvendes AI i QA (use cases, qa‑løsninger, software‑qa, quality engineering, tester)

AI gavner mange use cases gennem hele QA‑livscyklussen. For legacy‑kodebaser kan AI generere unit‑tests for hurtigt at øge dækningen. For regressionsuiter hjælper AI med at holde UI‑ og API‑tests opdaterede. Til exploratory testing supplerer AI testere ved at foreslå edge cases eller usædvanlige inputsekvenser. Til visuel regression hjælper AI med at detektere subtile layoutregressioner. Dette er konkrete QA‑løsninger, som teams kan implementere.

Målgrupper inkluderer QA‑teams, QA‑ingeniører og testere. Testere bevæger sig fra rutinemæssig scripting til scenariedesign og eksplorativ kvalitetsengineering. I praksis bliver testerens rolle mere strategisk. Testautomatisering bliver et samarbejde mellem menneskelig dømmekraft og AI‑forslag. Som følge heraf kan teams fokusere på at forbedre testscenarier og rodårsagsanalyser.

Målbare fordele inkluderer sparede timer per release, stigning i testdækning og hurtigere rodårsagsanalyser. Til en pilot vælg et kritisk produktområde såsom et betalingsflow. Anvend AI til at skabe automatiserede tests for unit, API og UI‑lag. Mål derefter før‑ og efterresultater: tid til at skabe tests, undslupne fejl og eksekveringstid for regressionstests. Denne fokuserede test giver klar ROI og læring.

Overvej også at bruge AI‑drevne testudvalg til natlige køringer for at reducere omkostninger. Bemærk, at teams stadig skal evaluere modeller og være opmærksomme på bias. Use cases omfatter software‑QA for finansielle systemer, e‑commerce checkout‑flows og B2B‑integrationer. Disse er områder, hvor nøjagtighed betyder noget, og hvor AI kan reducere gentaget arbejde betydeligt. Afslutningsvis vil fremtidens QA indeholde mere AI‑assistance, men den menneskelige rolle i at sætte intention og validere resultater vil forblive essentiel.

Styring, begrænsninger og valg af top AI‑drevne QA‑værktøjer (ai‑drevne, ai‑værktøjer, top ai‑drevne, chatgpt, machine learning, governance)

AI introducerer både potentiale og risici, så styring er vigtig. Begrænsninger inkluderer modelbias, potentiel overafhængighed og behovet for at vedligeholde ML‑modeller over tid. Et whitepaper advarede om, at organisationer må tackle etiske og operationelle bekymringer ved implementering af generativ AI i QA; læs analysen. Derfor implementer menneskelig review, datastyring og sporbarhed.

Når du vælger AI‑drevne værktøjer, vurder modelnøjagtighed, integrationsdybde med CI/CD og teststyring, kvaliteten af selvhelende funktioner og forklarbarhed. Tjek også sikkerhed og compliance. Lav en énsides indkøbsrubrik, der scorer leverandører efter integration, vedligeholdelsesomkostninger og forventet ROI. For eksempel kan kandidater til evaluering inkludere Copilot/GitHub Copilot, Testim, Mabl, Diffblue, Functionize og Applitools. Scor dem på, hvor godt de kan indpasses i dine frameworks, såsom Playwright eller JUnit, og hvordan de hjælper med at vedligeholde automatiserede tests.

Krav også, at leverandører viser, hvordan de håndterer data og hvordan modeller retrænes. Bed om en 90‑dages adoptionsplan med succesmål som dækningstilvækst, test‑velocity og reduktion af undslupne fejl. Inkluder desuden en pilot, der bruger en AI‑test i et kontrolleret miljø. Under piloten involver QA‑teams, udviklingsteams og sikkerhedsreviewere. Denne tværfunktionelle gennemgang undgår overraskelser og sikrer, at værktøjet lader teams bevare kontrol.

Endelig vær opmærksom på værktøjer som ChatGPT til idegenerering og kodeudsnit, men adskil disse fra produktionssystemer. Til produktionsklar automatisering foretræk dedikerede AI‑testværktøjer, der kobler til dit teststyringssystem og CI. Hold en kontinuerlig feedback‑loop, så produktionsincidenter forbedrer modeltræningen. Denne styringsstrategi sikrer, at AI bliver en robust del af din kvalitetsstyring, samtidig med at risiko minimeres.

FAQ

Hvad er en AI‑copilot til QA?

En AI‑copilot til QA er en assistent, der foreslår testcases, genererer kodeudsnit og foreslår testskripter baseret på krav, kode og telemetry. Den fremskynder forfatning, men en menneskelig reviewer bør validere output, før de frigives.

Hvor hurtigt kan teams se værdi fra en AI‑pilot?

Teams oplever ofte første værdi inden for to uger af et fokuseret pilotforløb, der fodrer et par brugerhistorier ind i copiloten. Dette viser tidsbesparelser, antal testudkast og forbedringer i dækningen.

Fjerner AI‑testværktøjer ustabile tests automatisk?

AI‑testværktøjer kan reducere flakiness ved at bruge selvhelende lokatorer og smartere elementidentifikation. Dog skal teams gennemgå automatiske ændringer og opretholde styringsmekanismer for at forhindre drift.

Hvordan prioriterer jeg tests med AI?

Brug ML‑baseret defektforudsigelse, der rangerer moduler efter risiko ved brug af commit‑historik og telemetry. Kør derefter målrettede suites på højrisikoområder og tilfør incidents tilbage i træningen for kontinuerlig forbedring.

Kan AI generere unit‑tests for legacy‑kode?

Ja, AI kan generere unit‑tests, der øger dækningen for legacy‑kode. Teams bør gennemgå genererede tests og integrere dem i CI‑pipen for at sikre stabilitet.

Hvilken styring kræves for AI i QA?

Styring kræver menneskelig gennemgang, adgangskontrol til data, revisionslogfiler og retræningspolitikker for AI‑modeller. Disse elementer reducerer bias, sikrer sporbarhed og opretholder kvalitet over tid.

Hvilke værktøjer bør jeg evaluere først?

Start med leverandører, der integrerer med din CI og teststyring. Overvej Copilot/GitHub Copilot til kodeudsnit, og evaluer Testim, Mabl, Diffblue, Functionize og Applitools til mere omfattende automatisering.

Hvordan arbejder AI og traditionel QA sammen?

AI supplerer traditionel QA ved at tage sig af rutineopgaver, foreslå testscenarier og holde testsuiter ajour. Menneskelige testere fokuserer på exploratory testing, validering og scenariedesign.

Er ChatGPT nyttig til testgenerering?

ChatGPT kan komme med idéer og udkast til testscenarier, men produktionstests bør komme fra værktøjer, der linkes direkte til CI og teststyring for sporbarhed og reproducerbarhed.

Hvordan bør jeg måle succes for en AI‑QA‑udrulning?

Mål dækningstilvækst, test‑velocity, reduktion i vedligeholdelsestimer og undslupne fejl i produktion. Brug disse målinger til at iterere over værktøjer og styringsplaner.

Ready to revolutionize your workplace?

Achieve more with your existing team with Virtual Workforce.