ai kybernetická bezpečnost: jak AI asistenti detekují hrozby v reálném čase

AI pomáhá BEZPEČNOSTNÍM TÝMŮM detekovat anomálie a hrozby v rozsahu a dělá to kontinuálně. Například AI asistent může sledovat logy, korelovat telemetrii a v reálném čase vyvolat upozornění, když vzorce odpovídají známému podpisu nebo neobvyklému behaviorálnímu otisku. Tato schopnost je důležitá, protože 77 % společností AI v provozech buď používá, nebo zkoumá, což vysvětluje silné přijetí AI v podnikovém prostředí statistika adopce 77 %. V praxi probíhá AI-driven ingest telemetrie, extrakce prvků a skórování mnohonásobně rychleji než manuální kontrola. Tok typicky začíná telemetrie → AI model → třídění upozornění → reakce. Jednoduchá smyčka může vypadat takto: senzory dodávají data z endpointů a sítě, AI model skóruje anomálie, systém vyvolá upozornění a poté spuštění obsahovacích akcí spustí playbook. To je obzvlášť užitečné pro detekci hrozeb v reálném čase, kde na minutách záleží.

Nástroje AI pro kybernetickou bezpečnost již pohánějí mnoho pipeline pro detekci a reakci. Přehled agentní AI poznamenává, že agentní AI se může přizpůsobit vznikajícím hrozbám a jednat s kognitivní autonomií, pokud je tak nakonfigurována agentní AI v kybernetické bezpečnosti. Platformy, které kombinují behaviorální baseline s proudovou analýzou, tak snižují dobu pobytu útočníka v síti a zviditelňují neznámé chování. V krátkém use casu systém detekuje vzorec laterálního pohybu, vydá upozornění, izoluje endpoint a eskaluje incident k SOC ke kontrole. Tato automatizovaná smyčka obsahování šetří čas a snižuje lidské chyby.

Bezpečnostní architekti musí rozhodnout, co automatizovat a co ponechat analytikům. Pro monitorování v reálném čase může AI filtrovat šum a prioritizovat hrozby tak, aby pomohla bezpečnostním týmům soustředit se na incidenty s vysokým rizikem. Současně by týmy měly požadovat provenance a skóre důvěry pro každé doporučení, protože studie ukazují, že výstupy AI mohou obsahovat nepřesnosti a chyby ve zdrojování, které jsou v bezpečnostním kontextu důležité studie o chybách ve zdrojování. Dále dodavatelé dnes nabízejí platformy kybernetické bezpečnosti poháněné AI, které se integrují se SIEM, EDR a cloudovými zdroji, což umožňuje rychlý workflow detekce a reakce a zároveň ponechává lidi ve smyčce pro kritická rozhodnutí.

Pro organizace, které řeší velké množství e-mailů, existují také provozní AI aplikace. Například virtualworkforce.ai využívá AI agenty k automatizaci životních cyklů e-mailů pro operační týmy, směrování zpráv a připojování kontextu k eskalacím. To snižuje čas ztracený při třídění a pomáhá týmům udržet silnější bezpečnostní postoj v komunikaci. Stručně řečeno, ai kybernetická bezpečnost v praxi jak detekuje hrozby v reálném čase, tak pomáhá zefektivnit provozní režii, která by jinak mohla odlákat personál SOC.

bezpečnostní operace: použití AI asistenta ke zrychlení detekce a nápravy

Bezpečnostní operace se spoléhají na rychlé, opakovatelné workflow. AI může automatizovat forenzní časové osy, spouštět playbooky a urychlit nápravu, zatímco SOC si zachovává kontrolu. Například integrace mezi XDR a SOAR umožňují motoru návrhů poháněnému AI navrhovat kroky obsazení, které poté inženýr může schválit nebo přepsat. Tato kombinace automatizace a lidského dohledu zkracuje průměrný čas k detekci i průměrný čas k nápravě. Ve skutečnosti automatizace snižuje pracovní zátěž analytiků a může omezit falešné poplachy, když korelace XDR filtrují hlučné signály.

Případy použití ukazují praktické přínosy. AI model může zpracovat tisíce upozornění, seskupit podobné incidenty a vygenerovat krátké shrnutí pro analytika. Poté analytik rozhodne, zda eskalovat. U rutinních phishingových případů může systém karanténovat zprávy a označit postižené endpointy, přičemž SOC poté přezkoumá automatizovanou akci. Tento přístup pomáhá týmům SOC soustředit se na vyšetřování, která vyžadují lidské rozhodnutí. Dále automatizace sběru důkazů a konstrukce časové osy urychluje vyšetřování a snižuje riziko přehlédnutých indikátorů.

Týmy by měly před povolením automatických akcí dodržet checklist pro řízení změn. Nejprve definujte prahy a skóre důvěry. Zadruhé mapujte playbooky na role a schválení. Zatřetí implementujte monitorování a možnosti rollbacku. Zpočátku zaznamenejte každý automatizovaný krok pro auditovatelnost. Tyto kroky pomáhají chránit prostředí a zachovat shodu. Praktický dashboard zobrazuje návrhy AI s jasnými přepsáními; to zjednodušuje workflow a zachovává odpovědnost.

Metriky, které je třeba sledovat, zahrnují počet tříděných upozornění za hodinu, míru falešných poplachů a čas k obsazení. Tyto KPI ukazují zlepšení a zároveň udržují týmy odpovědné. SOC by měl také pravidelně provádět red-team kontroly a simulované incidenty, aby validoval AI model a snížil zaujatost automatizace mezi analytiky. Výzkum naznačuje, že zaujatost automatizace ovlivňuje velkou část bezpečnostních profesionálů, proto jsou povinné ověřovací kroky důležité lidské faktory a zaujatost automatizace. Nakonec by týmy měly dokumentovat, kdy systém používá AI k automatické eskalaci a kdy čeká na lidské schválení. Tato jasná politika pomáhá jak CISO, tak frontline responderům.

Když vaše provozy zahrnují intenzivní práci s e-maily, zvažte kombinaci bezpečnostní automatizace s platformami pro automatizaci e-mailů. virtualworkforce.ai pomáhá týmům směrovat a řešit provozní e-maily, což snižuje hlučný kontext, který by jinak ztrácel čas SOC. Pro více o automatizaci logistických e-mailů a škálování provozních workflow si přečtěte tento zdroj o automatizované logistické korespondenci.

Drowning in emails?

Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

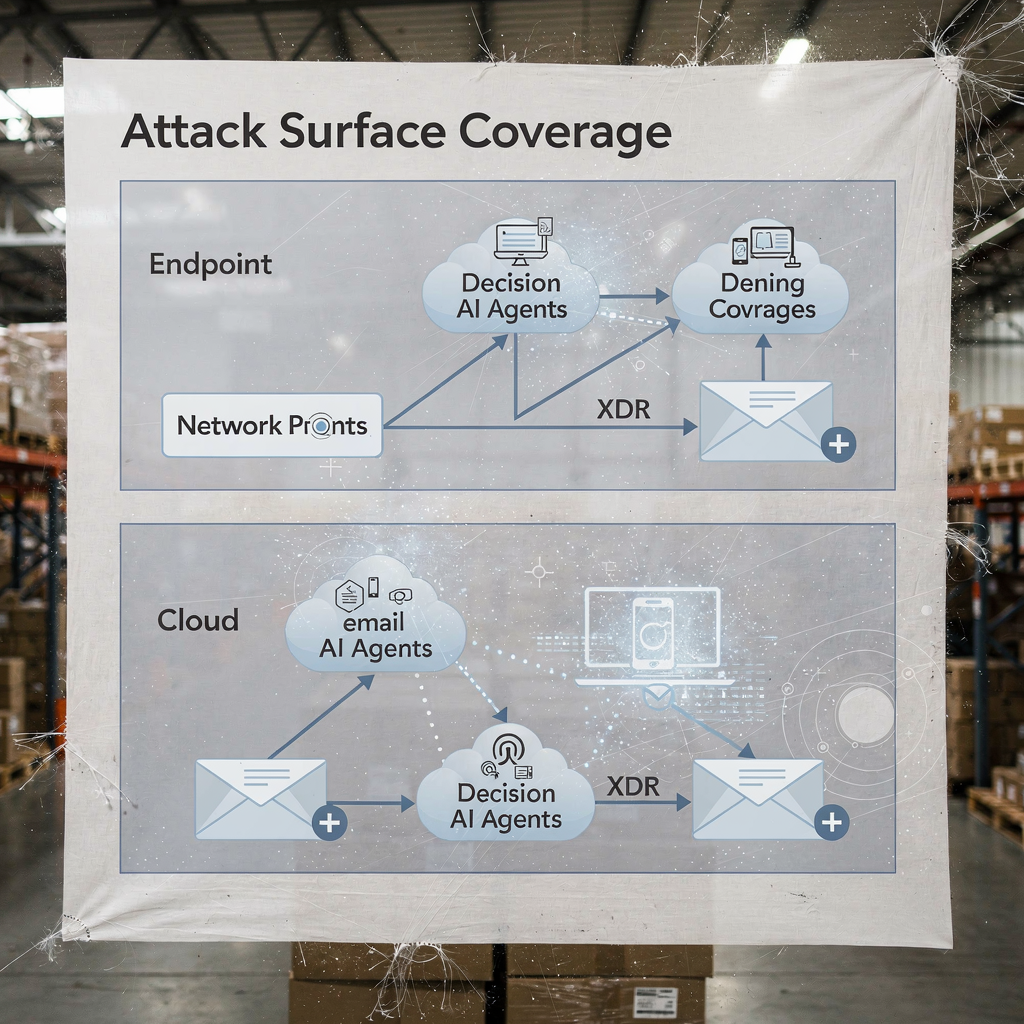

xdr a darktrace: příklady agentní AI v rozšířené detekci

Platformy rozšířené detekce a reakce sjednocují signály z endpointů, sítě, cloudu a e-mailu. XDR koreluje tyto zdroje telemetrie a aplikuje modely k odhalení komplexních cest útoku. Darktrace nabízí behaviorální modelování a funkce agentní AI, které se adaptují na měnící se baseline. V nedávných produktových aktualizacích Darktrace zdůraznil autonomní forenziku a adaptivní reakce, kde může platforma provádět obsahovací akce a generovat lidsky čitelné zdůvodnění těchto kroků. Tento přístup poskytuje týmům rychlejší cestu k detekci a reakci na známé i nové hrozby.

Typický scénář začíná anomalním chováním endpointu, které neodpovídá známému podpisu. XDR toto chování koreluje s neobvyklými síťovými toky a platforma vyznačí laterální pohyb. Poté obsahovací akce izoluje endpoint, zatímco automatizovaná forenzika zachytí artefakty. Příklady AI od Darktrace ukazují, jak strojové učení může mapovat akce útočníka napříč zařízeními a poté navrhnout odpověď, která izoluje povrch útoku. Tato sekvence pomáhá bránit proti ransomwaru a laterální propagaci.

Praktická integrace vyžaduje checklist. Nejprve zajistěte, aby váš XDR byl napojen na SIEM a SOAR pro obohacení událostí. Zadruhé mapujte response playbooky pro automatické versus manuální akce. Zatřetí nakonfigurujte platformu tak, aby exportovala kontext do ticketingu a e-mailu, aby týmy SOC zachovaly end-to-end trasovatelnost. Začtvrté testujte handoffy EDR-do-XDR a potvrďte věrnost telemetrie. Vrstvený diagram pokrytí XDR a rozhodovacích bodů AI objasní, kdo jedná a kdy.

Výhody XDR se rozšiřují i na cloudovou bezpečnost a e-mailové bezpečnostní toky. Platforma kombinuje telemetrii endpointu, síťové toky a threat intelligence, aby vytvořila širší obraz bezpečnostního postavení podniku. V nasazeních zahrnujících Darktrace mohou bezpečnostní týmy vidět poznatky o chování útočníka a rychlé možnosti obsazení. Přesto by týmy měly validovat rozhodnutí agentní AI prostřednictvím auditů a ukládat záznam každého autonomně provedeného kroku pro governance. Pro organizace v logistice a provozu integrace XDR insightů s automatizací e-mailů pomáhá zachovat kontinuitu při třídění hrozeb, které přicházejí prostřednictvím phishingu nebo kompromitovaných účtů. Podívejte se, jak může AI škálovat komunikaci ve frachtu a zachovat kontext v provozních zprávách AI pro komunikaci s frachtovými speditéry.

analytik: zaujatost automatizace, limity přesnosti a AI jako pomoc při rozhodování

Lidské faktory formují, jak týmy přijímají AI. Zaujatost automatizace a potvrzovací zaujatost mohou vést bezpečnostní analytiky k nadměrnému důvěřování výstupům AI. Studie ukazují, že zaujatost automatizace ovlivňuje velkou část praktiků, a analytici se musí naučit vnímat AI jako pomoc při rozhodování, nikoli jako orákulum lidské faktory v AI-řízené kybernetické bezpečnosti. Také výzkum zjistil, že mnoho AI-generovaných odpovědí obsahuje nepřesnosti a problémy se zdroji, což je kritické pro incident response, kde záleží na důvěře v fakta chyby ve zdrojování AI asistentů. Proto by vedoucí SOC měli přidat povinné ověřovací kroky a prahy důvěry ke každému automatizovanému doporučení.

Školení hraje zásadní roli. Týmy by měly provozovat scenáristické cvičení, provádět red-team cvičení a vyžadovat od analytiků ověření důkazů před uzavřením incidentu. Praktickou kontrolou je prezentovat provenance pro každé doporučení, aby analytici mohli vysledovat upozornění zpět k surovým logům a stavům AI modelu. Zaveďte také postupy pro zpracování chyb, které specifikují, co dělat, když systém vykazuje nízkou důvěru nebo nekonzistentní výstupy. Tento proces snižuje riziko a udržuje lidi v kritickém myšlení.

Transparentnost také pomáhá. Prezentování shrnutí, proč návrh vznikl, signálů, které ho podpořily, a verze modelu, která ho vygenerovala, buduje důvěru. Pro analytickou práci využívající přirozené jazykové souhrny je důležité je jasně označit, aby se zabránilo nadměrnému spoléhání se. Protože AI se nyní široce používá, týmy musí balancovat rychlost s pečlivostí. Použití skóre důvěry a požadování podpisu analytika u eskalací snižuje slepou automatizaci.

Nakonec se chraňte před shadow AI v týmech. Shadow AI nastává, když jedinci používají neautorizované genAI nástroje nebo genAI služby pro rychlé odpovědi. Tento postup může unikat citlivá data a zavést nekonzistentní logiku do vyšetřování. Zaveďte schválené genAI nástroje a bezpečný workflow pro jakýkoli externí dotaz nebo volání modelu. Poskytněte analytikům jasnou cestu k eskalaci složitých případů. Stručně řečeno, AI by měla posilovat analytika, nikoli nahrazovat úsudek.

Drowning in emails?

Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

zranitelnosti a citlivá data: AI k monitorování, obraně a vytváření nových rizik

AI pomáhá nacházet zranitelnosti a bránit citlivá data, a přesto přináší rizika dvojího použití. Na obranné straně může AI sledovat logy a webový provoz, detekovat vzorce naznačující pokusy o využití CVE a poté spustit nápravná opatření k opravě či izolaci postižených workloadů. Zároveň mohou škodliví aktéři nasadit AI agenty k automatizaci průzkumu, tvorbě cíleného phishingu a dokonce generování variant malwaru. Články o vznikajících hrozbách poznamenávají nárůst automatizovaných nebo škodlivých AI „zaměstnanců“, kteří mohou provádět insider-like sociální inženýrství hrozba škodlivého AI zaměstnance. Tato dualita zvyšuje sázky na to, jak spravujete přístup k citlivým údajům.

Otázky soukromí se objevují, když AI přistupuje k logům obsahujícím PII nebo provozní tajemství. Aby se zabránilo únikům, vynucujte přísné politiky přístupu k datům, používejte filtrování vstupů/výstupů a upřednostňujte on-premise nebo nasazení privátních modelů pro vysoce citlivé úlohy. Také zaznamenávejte všechny akce a dotazy AI, abyste mohli rekonstruovat rozhodnutí a identifikovat jakýkoli abnormální odtok dat. Pro týmy, které řeší provozní e-maily, zajistí, že platformy pro automatizaci e-mailů aplikují data-grounding a governance napříč ERP a dokumentovými zdroji, že nedojde k náhodnému zveřejnění. Prozkoumejte, jak automatizace e-mailů zachovává kontext a snižuje manuální vyhledávání v logistických workflow ERP e-mailová automatizace pro logistiku.

Návrhněte kontroly k detekci škodlivé AI aktivity. Sledujte abnormální objemy dotazů a neobvyklé vzorce, které mohou naznačovat automatizovaný nástroj pro průzkum nebo pipeline exfiltrace. Implementujte throttly a kvóty na dotazy, které přistupují k velkým datasetům. Provádějte threat hunting s předpokladem, že útočníci mohou využít generativní AI k tvorbě polymorfního phishingu a k masovému vytváření přesvědčivých sociálně-inženýrských zpráv. Rovněž revidujte výstupy modelu kvůli halucinacím nebo nepodloženým tvrzením, protože chyby ve zdrojování mohou mást analytiky a vést k nesprávným nápravným krokům.

Nakonec chraňte samotné modely. Útoky na otrávení modelu a otrávení dat mohou zkreslit učící modely a snížit přesnost detekce. Periodická validace modelu a kontroly provenance dat pomáhají včas odhalit pokusy o otrávení. Uchovávejte podepsané verze modelů a plán rollbacku pro kompromitované nebo degradované modely. Tyto kroky společně pomáhají chránit citlivá data a umožňují AI efektivně monitorovat a chránit systémy.

bezpečnost AI a proaktivní kybernetická bezpečnost: governance, validace a AI v každé fázi

Governance zůstává základem bezpečného nasazení AI. Implementujte validaci modelu, kontinuální testování, vysvětlitelnost a zásady životního cyklu před širokými rollouty. Vyžadujte provenance a kontroly zdrojů, provádějte periodické audity přesnosti a používejte postupné nasazení s kritérii rollbacku. Tyto kontroly jsou v souladu s regulatorními požadavky, jako je GDPR a směrnice EU týkající se minimalizace dat a transparentnosti. Zahrňte také CISO do governance přezkumů a vyžadujte jasné incidentní playbooky, které pokrývají selhání modelů.

Praktické kroky zahrnují testování před nasazením, runtime monitorování, incidentní playbooky a definovaná kritéria rollbacku. Například proveďte dry run před nasazením, který zkontroluje AI model proti testovacímu korpusu obsahujícímu známé škodlivé vzorky, hlučný provoz a citlivé záznamy. Poté monitorujte drift a přesnost v produkci a plánujte měsíční audity. Používejte nástroje vysvětlitelnosti, aby analytikům poskytly odůvodnění klíčových rozhodnutí. Takové kroky dělají řešení kybernetické bezpečnosti poháněná AI auditovatelnými a důvěryhodnými.

Adoptujte checklist pro produkční použití: potvrďte přístupové kontroly, implementujte sanitizaci vstupů, nastavte politiky retence a požadujte podepsané logy každé automatizované akce. Sledujte KPI jako míru falešných poplachů, čas k obsazení a procento upozornění vyřešených s lidským dohledem. Připravte také roadmapu na prvních 90 dnů pro jakékoli nasazení AI: baseline metriky, sandbox testy, postupné zpřístupnění, školení a governance schválení. Tento přístup pomáhá dodat proaktivní kybernetickou bezpečnost, která dokáže detekovat známé i neznámé hrozby.

Nakonec vyvažujte inovaci s opatrností. Pokročilá AI a deep learning přinášejí nové schopnosti obranářským nástrojům, ale governance udržuje tyto schopnosti v souladu s vaším bezpečnostním postojem. Pokud potřebujete škálovat provozy bez navyšování počtu zaměstnanců, zvažte automatizaci opakujících se toků, jako je zpracování provozních e-mailů; virtualworkforce.ai ukazuje, jak AI agenti mohou snížit dobu zpracování a zachovat kontext u eskalací, což podporuje jak produktivitu, tak bezpečnostní cíle jak škálovat logistické operace bez náboru. Začněte malými kroky, měřte dopad a iterujte s jasnými mantinely.

FAQ

Co je AI asistent v kybernetické bezpečnosti?

AI asistent v kybernetické bezpečnosti je automatizovaný agent, který pomáhá monitorovat, analyzovat a prioritizovat bezpečnostní události. Poskytuje podporu při rozhodování, automatizuje rutinní vyšetřovací úkoly a vyzvedává vysoce důvěryhodná upozornění k lidské kontrole.

Jak AI systémy detekují hrozby v reálném čase?

AI systémy ingestují telemetrii z endpointů, sítě a cloudu, poté aplikují modely k detekci anomálií naznačujících kompromitaci. Skórují události, seskupují související aktivity a vyvolávají upozornění v reálném čase, aby týmy mohly rychle zasáhnout.

Může AI snížit průměrný čas k detekci (MTTD)?

Ano. AI urychluje třídění tím, že seskupuje upozornění, shrnuje důkazy a navrhuje kroky playbooku, což snižuje MTTD. Nicméně týmy musí validovat výstupy, aby se předešlo zaujatosti automatizace a falešným poplachům.

Co je XDR a jak využívá AI?

XDR znamená extended detection and response a sjednocuje signály z endpointů, sítě, cloudu a e-mailu. XDR platformy používají AI agenty a behaviorální modely k korelaci událostí a navrhování obsahovacích akcí.

Jsou doporučení AI vždy přesná?

Ne. Studie ukazují, že výstupy AI mohou obsahovat nepřesnosti a chyby ve zdrojování, proto organizace musí požadovat provenance, skóre důvěry a lidskou verifikaci. Pravidelné audity a validace snižují riziko chybných kroků.

Jak zabránit tomu, aby AI unikal citlivá data?

Omezte přístup k modelům, používejte filtrování vstupů/výstupů, upřednostňujte on-premise nebo privátní modely pro citlivé úlohy a zaznamenávejte každou akci AI. Politiky přístupu k datům a pravidla retence také snižují riziko úniku.

Co je zaujatost automatizace a jak ovlivňuje bezpečnostní analytiky?

Zaujatost automatizace nastává, když analytici příliš důvěřují výstupům AI a zanedbávají nezávislé ověření. Může vést k přehlédnutí anomálií; školení, prahy důvěry a povinné ověřovací kroky pomáhají tuto zaujatost zmírnit.

Jak by měly organizace řídit AI v bezpečnosti?

Governance by měla zahrnovat testování před nasazením, kontinuální monitorování, vysvětlitelnost, kontroly provenance a postupné rollouty. Tyto kontroly slaďte s regulatorními požadavky jako GDPR a interními rámci shody.

Může AI pomoci s e-mailovou bezpečností a provozem?

Ano. AI může automatizovat třídění e-mailů, klasifikovat záměr, připojovat kontext a navrhovat odpovědi při zachování auditních stop. Nástroje, které zakládají odpovědi na ERP a dokumentových systémech, mohou snížit manuální vyhledávání a bezpečnostní rizika. Pro příklady v automatizaci logistických e-mailů viz tento zdroj o AI v komunikaci frachtu a logistiky.

Jaké jsou první kroky k bezpečnému nasazení AI asistenta?

Začněte malým pilotem, definujte KPI, proveďte validaci modelu a požadujte lidské schválení pro zásahy s vysokým dopadem. Připravte také rollback plány a školte analytiky na postupy pro zpracování chyb a ověřování.

Drowning in emails?

Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.