Wie ein KI‑Copilot QA‑Teams bei der Automatisierung der Testerstellung unterstützt (AI, QA, Copilot, Testerstellung)

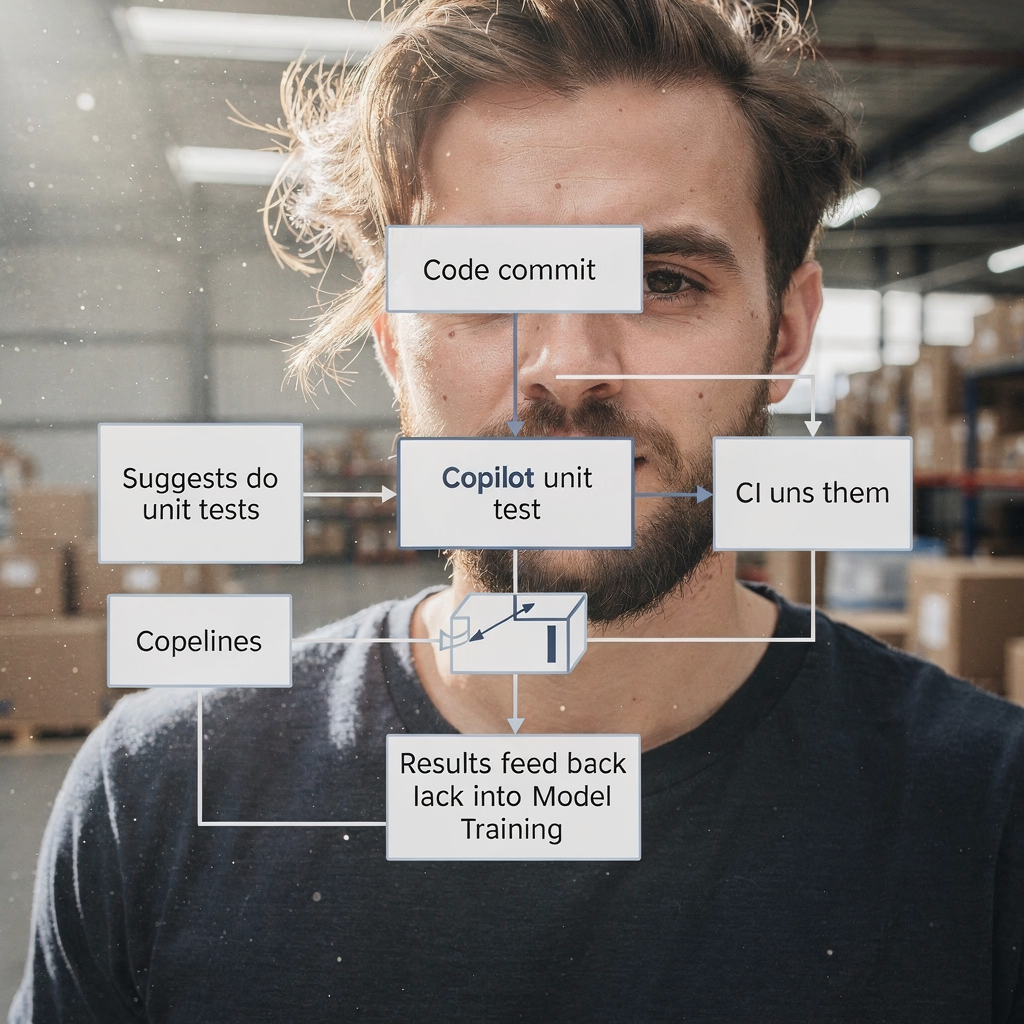

KI beschleunigt die TESTERSTELLUNG, indem Anforderungen, Code und Nutzerflüsse in brauchbare Testentwürfe verwandelt werden. Zunächst liest ein Copilot User Stories und Code‑Diffs. Anschließend schlägt er Testfall‑Gliederungen, Unit‑Tests und UI‑Schritte vor. Zum Kontext: Gartner prognostiziert eine rasche Verbreitung von Code‑Assistenten bei Entwicklern; bis 2028 werden drei Viertel der Enterprise‑Softwareentwickler KI‑Code‑Assistenten nutzen laut Branchenberichten. Außerdem verkürzen Teams, die einen Copilot einführen, oft die Zeit von der Story bis zum automatisierten Test.

Beispielsweise kann KI Unit‑Tests ähnlich wie Diffblue entwerfen, UI‑Flows wie Testim oder Mabl erstellen und visuelle Assertions ähnlich Applitools vorschlagen. Zusätzlich lassen sich natürlichsprachliche Tests erzeugen, die wie Akzeptanzkriterien gelesen werden, ähnlich Functionize. Diese Outputs reichen von kurzen Testfall‑Snippets bis zu vollständigen Testskripten. Für Unit‑Tests nutzen Sie einen KI‑Copilot, um JUnit‑ oder Playwright‑Beispiele zu generieren und diese dann zu verfeinern. Für UI‑Arbeit bitten Sie den Copilot, Schritte in ein Testframework oder in Playwright‑Code zu exportieren. Das beseitigt sich wiederholende Skriptarbeit.

Messen Sie den Einfluss mit einfachen KPIs. Verfolgen Sie die Zeit bis zum ersten automatisierten Test und die prozentuale Erhöhung der Testabdeckung pro Sprint. Erfassen Sie außerdem die Anzahl der Test‑Szenarioentwürfe, die pro User Story erstellt werden. Eine schnelle Maßnahme ist ein zweiwöchiger Pilot, der drei bis sechs User Stories in einen KI‑Copilot einspeist und dann manuellen gegen KI‑generierten Test‑Output vergleicht. Dieser Pilot kann Abdeckungsgewinne zeigen, Lücken in der Kontextverarbeitung des Copilots aufdecken und zeigen, wie leicht Teams Tests in die CI‑Pipeline einbinden können.

Praktisch integrieren Sie die Copilot‑Vorschläge in einen PR‑Workflow. Lassen Sie den Copilot Testdateien im Feature‑Branch vorschlagen. Dann sollte ein QA‑Engineer oder Tester die vorgeschlagenen Tests überprüfen. Das reduziert die Zeit für Boilerplate. Schließlich verstehen Teams, dass ein KI‑Copilot das Verfassen beschleunigt, ohne menschliches Urteilsvermögen zu ersetzen. Für weiterführende Informationen zur Automatisierung operativer Nachrichten und ähnlicher Workflows sehen Sie unsere Ressource dazu, wie man Logistikprozesse mit KI‑Agenten skaliert.

Use ai testing tools to automate qa process and reduce test maintenance (ai testing tools, automate, qa process, automated test, self‑healing)

AI‑Testing‑Tools liefern selbstheilende Locator und Element‑Identifikationsfunktionen, die Flakiness deutlich reduzieren. Zum Beispiel passen Tools wie Testim und Mabl Selektoren an, wenn sich das DOM ändert. Dadurch verbringen Teams weniger Stunden mit der Reparatur brüchiger Testscripte. Außerdem können diese Tools visuelle Diff‑Annotationen vornehmen und so visuelle Regressionsprüfungen präzise halten. Verwenden Sie einen automatisierten Test‑Runner, der Self‑Healing unterstützt, damit die Test‑Pipeline zuverlässig bleibt.

KI beseitigt jedoch nicht die Notwendigkeit von Guardrails. Überprüfen Sie automatisch aktualisierte Tests vor dem Release und halten Sie einen Human‑in‑the‑Loop. Ein aktuelles Whitepaper stellt fest: „AI can support many aspects of QA, but it also introduces critical risks that demand careful attention“ laut Branchenanalyse. Pflegen Sie daher Freigabetore und integrieren Sie Change‑Logs. Nutzen Sie Telemetrie, um zu erkennen, wenn Self‑Healing die Testintention verschoben haben könnte.

Zur Implementierung integrieren Sie das Testtool in CI, sodass Updates automatisch bei PRs ausgeführt werden. Legen Sie dann eine Regel fest: Selbstgeheilte Änderungen müssen innerhalb des Release‑Fensters überprüft werden. Verfolgen Sie die Reduktion flaky Fehler und die Wartungsstunden pro Sprint als Erfolgskennzahlen. Nutzen Sie Dashboards, um Trends sichtbar zu machen und Regressionen früh zu erkennen. Teams können außerdem die automatische Rücksetzung von Auto‑Änderungen automatisieren, wenn Tester Regressionen melden.

In der Praxis kombinieren Sie Self‑Healing mit leichtgewichtiger Governance. Bewahren Sie anonymisierte historische Testläufe für das Modelltraining auf. Verbinden Sie das Tool mit Ihrem Testmanagement‑System, sodass Genehmigungen und Kommentare verknüpft bleiben. Das erleichtert Audits darüber, wer KI‑Änderungen akzeptiert hat. Für Teams, die umfangreiche E‑Mail‑Workflows oder getrackte Vorfälle verwalten, zeigt unsere Plattform, wie man KI‑Aktionen in operative Daten und Regeln einbettet; siehe unseren Leitfaden Logistik‑E‑Mails mit Google Workspace und virtualworkforce.ai automatisieren. Akzeptieren Sie schließlich, dass KI‑Testing‑Tools die Wartung reduzieren — jedoch nur mit geeigneten Kontrollen.

Drowning in emails?

Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

Prioritise testing with ai in qa: defect prediction, test selection and feedback loops (ai in qa, qa teams, feedback loops, metric, defect prediction)

KI in QA kann vorhersagen, wo Defekte am wahrscheinlichsten auftreten. Mithilfe von Commit‑History, Telemetrie und vergangenen Defekten bewerten ML‑Modelle Module nach Risiko. Folglich können QA‑Teams fokussierte Test‑Suiten in diesen Bereichen ausführen statt überall. Ein gezielter Ansatz reduziert entweichende Defekte und beschleunigt Releases. Beispielsweise führen Sie einen Smoke‑ und gezielten Regressionstest für ein als hochriskant eingestuftes Modul durch und einen vollständigen Regressionstest nur bei Bedarf.

Studien zeigen, dass KI‑gestützte Defektvorhersage die Erkennungsraten erhöht und es Teams ermöglicht, knappe Testressourcen dort einzusetzen, wo sie am meisten bringen. Ein Branchenbericht hebt Produktivitätsgewinne durch KI‑assistiertes Engineering hervor, weist jedoch darauf hin, dass Qualitätsverbesserungen je nach Team und Setup variieren der Bericht erklärt. Behandeln Sie Modell‑Ergebnisse daher als Orientierungshilfe, nicht als absolute Wahrheit.

Richten Sie kontinuierliche FEEDBACK‑LOOPS von Produktionsvorfällen zurück in das Modelltraining ein. Speisen Sie anonymisierte Telemetrie und Incident‑Tags in den Trainingsdatensatz. Trainieren Sie dann periodisch nach, um die Risiko‑Vorhersage an aktuelle Änderungen anzupassen. Verfolgen Sie entwichene Defekte in Produktion, die False‑Negative‑Rate und den Prozentsatz der durch risikobasierte Selektion übersprungenen Tests. Nutzen Sie diese Metriken, um Schwellenwerte zu justieren und zu entscheiden, wann die gezielte Suite ausgeweitet werden soll.

Binden Sie außerdem QA‑Engineers und QA‑Teams in das Tuning der Modelle ein. Ein QA‑Engineer sollte Modellvorschläge validieren und False‑Positives kennzeichnen. Diese Zusammenarbeit verbessert die KI‑Modelle. Teams verbessern dadurch ihre Fähigkeit, Probleme schneller zu triagieren, und erkennen Muster, die vorher im Rauschen verborgen waren. Für Organisationen, die operative E‑Mails und Prozessautomatisierungen managen, helfen dieselben Feedback‑Loop‑Ideen, Fehlklassifikationen zu beheben; siehe unsere Erklärung, wie virtualworkforce.ai Handling‑Zeit reduziert und Feedback‑Zyklen schließt.

Integrate ai tools with existing test automation and test management (integrate ai, testing tool, qa tools, framework, test automation)

Um KI in den bestehenden Stack zu integrieren, übernehmen Sie pragmatische Muster. Fügen Sie zuerst einen KI‑Copilot als Entwickler‑ oder QA‑Assistent im Repository hinzu. Verbinden Sie zweitens die Testplattform mit Ihrem Testmanagement‑System und CI/CD. Drittens mappen Sie KI‑Outputs auf bestehende Testframeworks wie Selenium, Playwright oder JUnit. Lassen Sie den Copilot etwa PRs öffnen, die Playwright‑Tests hinzufügen und mit der entsprechenden Ticket‑ID verknüpfen.

Checklisten‑Punkte für die Integration beinhalten Zugang zum Codebase, anonymisierte historische Testläufe, Telemetrie und Tag‑Mapping zwischen Ihrem Testmanagement und KI‑Outputs. Diese Metadaten erlauben es der KI, relevante Testszenarien vorzuschlagen. Stellen Sie außerdem Traceability sicher: Jeder KI‑generierte Testfall sollte auf die Anforderung und den PR verweisen, der ihn eingeführt hat. Das verbessert die Auditierbarkeit und reduziert doppelte Tests.

Schnelle Erfolge sind möglich, indem der Copilot Tests als Teil von Pull‑Request‑Checks vorschlägt. Wenn ein PR beispielsweise einen Zahlungsflow ändert, lassen Sie die KI verwandte Testszenarien vorschlagen und Tests für funktionale und Regressionstests erstellen. Dann können Reviewer die generierten Testskripte akzeptieren oder verfeinern. So bleibt der Workflow schnell und die Qualität erhalten. Zusätzlich integrieren Sie das Testtool in das Dashboard, sodass Stakeholder Abdeckung und Fehler an einem Ort sehen.

Praktisch nutzen Sie ein leichtgewichtiges Governance‑Modell. Pflegen Sie ein Testautomatisierungs‑Backlog, in dem vorgeschlagene KI‑Änderungen landen. Weisen Sie dann einen Tester zur Validierung zu. So vermeiden Sie ungeprüfte Drift im Suite. Stellen Sie außerdem sicher, dass Ihre Testframeworks kompatibel sind; moderne Playwright‑Setups akzeptieren generierten Code beispielsweise leicht. Prüfen Sie beim Integrieren von KI‑Tools Sicherheit, Datenzugriffsrichtlinien und Compliance. Wenn Sie sehen möchten, wie KI‑Agenten in operative Daten eingebettet werden können, lesen Sie unseren Artikel wie man Logistikprozesse ohne Neueinstellungen skaliert.

Drowning in emails?

Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

Use cases and QA solutions: who benefits and where to apply ai qa (use cases, qa solutions, software qa, quality engineering, tester)

KI bringt Vorteile für viele Anwendungsfälle entlang des QA‑Lebenszyklus. Für Legacy‑Codebasen kann KI Unit‑Tests erzeugen, um schnell die Coverage zu erhöhen. Für Regression‑Suiten hilft KI, UI‑ und API‑Tests aktuell zu halten. Für Exploratory Testing ergänzt KI Tester, indem sie Edge‑Cases oder ungewöhnliche Eingabesequenzen vorschlägt. Für visuelle Regression hilft KI, subtile Layout‑Regressionen zu erkennen. Das sind konkrete QA‑Lösungen, die Teams einsetzen können.

Zielgruppen sind QA‑Teams, QA‑Engineers und Tester. Tester verlagern ihre Arbeit vom Routine‑Scripting hin zu Szenario‑Design und explorativer Qualitätsarbeit. Praktisch wird die Rolle des Testers strategischer. Testautomatisierung wird zu einer Zusammenarbeit zwischen menschlichem Urteil und KI‑Vorschlägen. Als Ergebnis können Teams ihre Energie auf die Verbesserung von Testszenarien und Root‑Cause‑Analysen konzentrieren.

Messbare Vorteile sind eingesparte Zeit pro Release, Zugewinn an Testabdeckung und schnellere Root‑Cause‑Analysen. Für einen Pilot wählen Sie einen kritischen Produktbereich wie einen Zahlungsflow. Setzen Sie KI ein, um automatisierte Tests für Unit, API und UI‑Layer zu erstellen. Messen Sie danach Vorher‑Nachher‑Ergebnisse: Zeit zur Testerstellung, entwichene Defekte und Ausführungszeit der Regressionstests. Dieser fokussierte Versuch liefert klares ROI und Lernergebnisse.

Erwägen Sie außerdem, KI‑gestützte Testauswahl für nächtliche Läufe zu nutzen, um Kosten zu senken. Beachten Sie, dass Teams Modelle weiterhin evaluieren und auf Bias achten müssen. Einsatzgebiete sind unter anderem Software‑QA für Finanzsysteme, E‑Commerce‑Checkout‑Flows und B2B‑Integrationen. Das sind Bereiche, in denen Genauigkeit zählt und KI repetitive Arbeit merklich reduzieren kann. Abschließend wird die Zukunft der QA mehr KI‑Unterstützung umfassen, doch die menschliche Rolle bei der Setzung der Intention und Validierung der Ergebnisse bleibt zentral.

Governance, limitations and selecting top ai-powered qa tools (ai-powered, ai tools, top ai-powered, chatgpt, machine learning, governance)

KI bringt sowohl Kraft als auch Risiken mit sich, daher ist Governance wichtig. Einschränkungen umfassen Modell‑Bias, potenzielle Überabhängigkeit und die Notwendigkeit, ML‑Modelle über die Zeit zu pflegen. Ein Whitepaper warnte, dass Organisationen ethische und operative Fragen adressieren müssen, wenn sie generative KI in QA einführen lesen Sie die Analyse. Implementieren Sie daher menschliche Überprüfungs‑Schritte, Daten‑Governance und Nachvollziehbarkeit.

Bei der Auswahl KI‑gestützter Tools bewerten Sie Modellgenauigkeit, Integrationsgrad mit CI/CD und Testmanagement, Self‑Healing‑Qualität und Erklärbarkeit. Prüfen Sie außerdem Sicherheit und Compliance. Erstellen Sie ein einseitiges Beschaffungs‑Rubrik, das Anbieter nach Integration, Wartungsaufwand und erwartetem ROI bewertet. Kandidaten zum Evaluieren sind beispielsweise Copilot/GitHub Copilot, Testim, Mabl, Diffblue, Functionize und Applitools. Bewerten Sie, wie gut sie in Ihre Frameworks wie Playwright oder JUnit passen und wie sie helfen, automatisierte Tests wartbar zu halten.

Fordern Sie von Anbietern außerdem darzulegen, wie sie mit Daten umgehen und wie Modelle nachtrainiert werden. Bitten Sie um einen 90‑Tage‑Adoptionsplan mit Erfolgskennzahlen wie Coverage‑Zuwachs, Test‑Velocity und Reduktion entwichener Defekte. Schließen Sie zudem einen Pilot ein, der einen AI‑Test in einer kontrollierten Umgebung einsetzt. Binden Sie während des Piloten QA‑Teams, Entwicklungsteams und Security‑Reviewer ein. Diese funktionsübergreifende Prüfung vermeidet Überraschungen und stellt sicher, dass das Tool Teams die Kontrolle lässt.

Schließlich seien Sie vorsichtig mit Tools wie chatgpt für Ideation und Code‑Snippets, trennen Sie diese aber von Produktionssystemen. Für produktionsreife Automatisierung bevorzugen Sie dedizierte KI‑Testing‑Tools, die an Ihr Testmanagement und CI angebunden sind. Halten Sie einen kontinuierlichen Feedback‑Loop, sodass Produktionsvorfälle das Modelltraining verfeinern. Dieser Governance‑Ansatz stellt sicher, dass KI ein belastbarer Teil Ihres Qualitätsmanagements wird und gleichzeitig Risiken minimiert werden.

FAQ

What is an AI copilot for QA?

Ein KI‑Copilot für QA ist ein Assistent, der Testfälle vorschlägt, Code‑Snippets generiert und Testskripte basierend auf Anforderungen, Code und Telemetrie empfiehlt. Er beschleunigt das Erstellen, aber ein menschlicher Prüfer sollte die Outputs vor dem Release validieren.

How quickly can teams see value from an AI pilot?

Teams sehen oft innerhalb von zwei Wochen ersten Nutzen nach einem fokussierten Pilot, der wenige User Stories in den Copilot einspeist. Das offenbart Zeitersparnis, die Anzahl erzeugter Testentwürfe und Verbesserungen der Abdeckung.

Do AI testing tools remove flaky tests automatically?

AI‑Testing‑Tools können Flakiness reduzieren, indem sie selbstheilende Locator und intelligentere Elementidentifikation verwenden. Teams müssen jedoch Auto‑Änderungen überprüfen und Guardrails beibehalten, um Drift zu vermeiden.

How do I prioritise tests with AI?

Nutzen Sie ML‑basierte Defektvorhersage, die Module nach Risiko anhand von Commit‑History und Telemetrie priorisiert. Führen Sie dann gezielte Suiten in Hochrisikobereichen aus und speisen Vorfälle zurück ins Training für kontinuierliche Verbesserung.

Can AI generate unit tests for legacy code?

Ja, KI kann Unit‑Tests für Legacy‑Code generieren, um Coverage zu erhöhen. Teams sollten generierte Tests prüfen und in die CI‑Pipeline integrieren, um Stabilität zu gewährleisten.

What governance is needed for AI in QA?

Governance erfordert menschliche Überprüfung, Datenzugriffs‑Kontrollen, Audit‑Logs und Nachtrainings‑Richtlinien für KI‑Modelle. Diese Elemente reduzieren Bias, sichern Nachvollziehbarkeit und erhalten Qualität über die Zeit.

Which tools should I evaluate first?

Beginnen Sie mit Anbietern, die sich in Ihr CI und Testmanagement integrieren. Ziehen Sie Copilot/GitHub Copilot für Snippets in Betracht und evaluieren Sie Testim, Mabl, Diffblue, Functionize und Applitools für umfassendere Automatisierung.

How do AI and traditional QA work together?

KI ergänzt traditionelle QA, indem sie repetitive Aufgaben übernimmt, Testszenarien vorschlägt und Suiten aktuell hält. Menschliche Tester konzentrieren sich auf Exploratory Testing, Validierung und Szenario‑Design.

Is chatgpt useful for test generation?

ChatGPT eignet sich für Ideation und das Erstellen von Testentwürfen, doch Produktions‑Tests sollten von Tools stammen, die direkt an CI und Testmanagement angebunden sind, um Nachvollziehbarkeit und Reproduzierbarkeit zu gewährleisten.

How should I measure success for an AI QA rollout?

Messen Sie Coverage‑Zuwachs, Test‑Velocity, Reduktion der Wartungsstunden und entwichene Defekte in Produktion. Verwenden Sie diese Kennzahlen, um Tooling und Governance iterativ zu verbessern.

Drowning in emails?

Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.