Cómo un copiloto de IA ayuda a los equipos de QA a automatizar la creación de pruebas (ia, qa, copiloto, creación de pruebas)

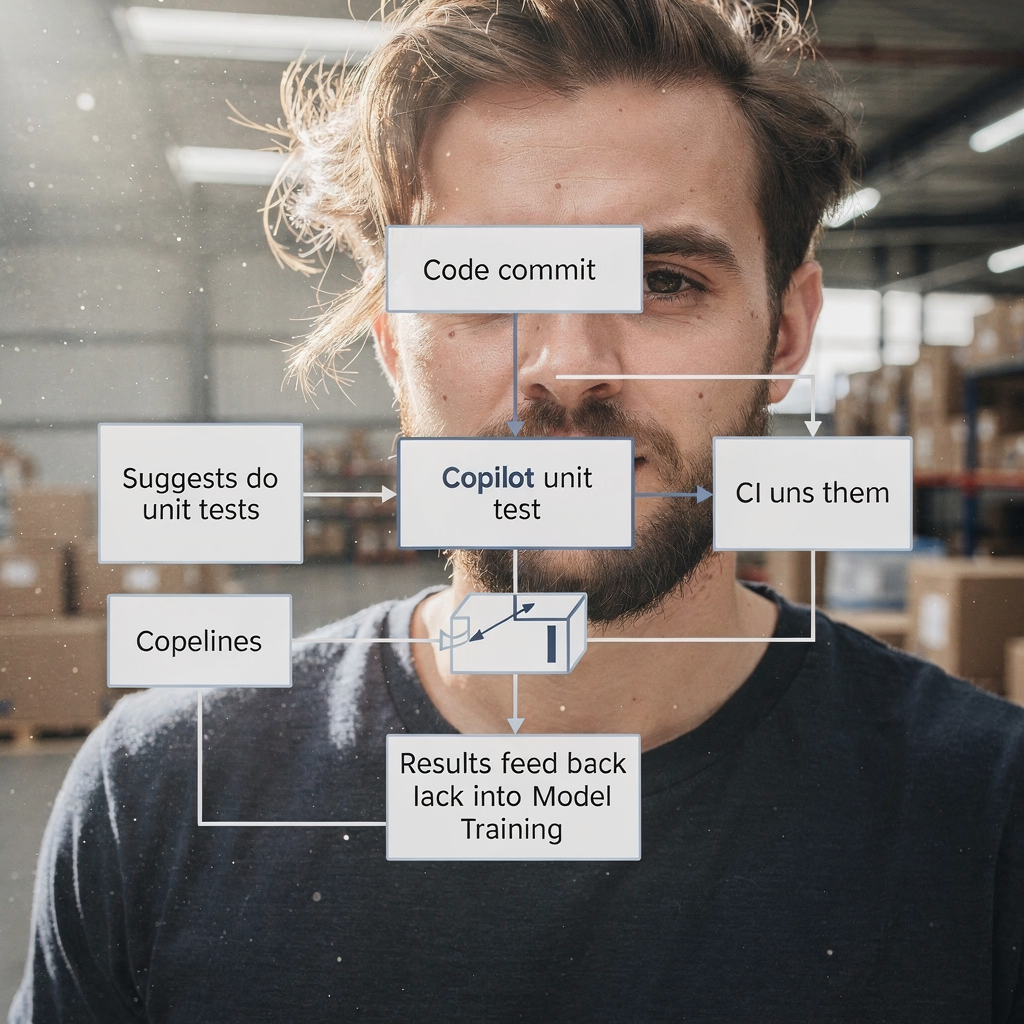

La IA ayuda a acelerar la CREACIÓN DE PRUEBAS convirtiendo requisitos, código y flujos de usuario en borradores de prueba utilizables. Primero, un copiloto lee historias de usuario y diffs de código. A continuación, propone esquemas de casos de prueba, pruebas unitarias y pasos de interfaz de usuario. Para contexto, Gartner pronostica una adopción rápida de asistentes de código para ingenieros; para 2028 tres cuartas partes de los ingenieros de software empresariales usarán asistentes de código con IA según reportes de la industria. Además, los equipos que adoptan un copiloto suelen acortar el tiempo desde la historia hasta la prueba automatizada.

Por ejemplo, la IA puede redactar pruebas unitarias similares a Diffblue, crear flujos de UI como Testim o Mabl, y proponer aserciones visuales parecidas a Applitools. Además, pueden producirse pruebas en lenguaje natural que se lean como criterios de aceptación, similar a Functionize. Estos resultados van desde fragmentos cortos de casos de prueba hasta scripts completos. Para pruebas unitarias, use un copiloto de IA para generar ejemplos en JUnit o Playwright y luego afínelos. Para trabajo de UI, pida al copiloto que exporte los pasos a un framework de pruebas o a código Playwright. Esto elimina el trabajo repetitivo de scripting.

Mida el impacto con KPIs sencillos. Haga seguimiento del tiempo hasta la primera prueba automatizada y del porcentaje de aumento de la cobertura de pruebas por sprint. También rastree el número de borradores de escenarios de prueba creados por historia de usuario. Una acción rápida es ejecutar un piloto de dos semanas que alimente tres a seis historias de usuario en un copiloto de IA y luego comparar el rendimiento manual frente al generado por IA. Este piloto puede mostrar ganancias de cobertura, revelar brechas en el manejo del contexto por parte del copiloto y mostrar lo fácil que es para los equipos mapear las pruebas en la canalización de CI.

En la práctica, integre las sugerencias del copiloto en un flujo de trabajo de PR. Deje que el copiloto proponga archivos de prueba en la rama de la funcionalidad. Después, un ingeniero de QA o un tester revisa las pruebas propuestas. Esto reduce el tiempo dedicado al código repetitivo. Finalmente, los equipos entienden que un copiloto de IA acelera la redacción sin reemplazar el juicio humano. Para más lecturas sobre la automatización de mensajes operativos y flujos similares, vea nuestro recurso sobre cómo escalar operaciones logísticas con agentes de IA.

Use ai testing tools to automate qa process and reduce test maintenance (ai testing tools, automate, qa process, automated test, self‑healing)

Las herramientas de testing con IA ofrecen localizadores auto‑reparables y funciones de identificación de elementos que reducen drásticamente la inestabilidad. Por ejemplo, herramientas como Testim y Mabl adaptan los selectores cuando cambia el DOM. Como resultado, los equipos dedican menos horas a arreglar scripts de prueba frágiles. Además, estas herramientas pueden anotar diffs visuales, ayudando a que las comprobaciones de regresión visual se mantengan precisas. Use un ejecutor de pruebas automatizado que soporte auto‑reparación para que la canalización de pruebas siga siendo fiable.

Sin embargo, la IA no elimina la necesidad de salvaguardas. Revise las pruebas actualizadas automáticamente antes del lanzamiento y mantenga a un humano en el bucle. Un whitepaper reciente afirma: «La IA puede apoyar muchos aspectos de QA, pero también introduce riesgos críticos que demandan atención cuidadosa» según análisis del sector. Por lo tanto, mantenga puertas de aprobación e integre registros de cambios. Además, use telemetría para detectar cuando la auto‑reparación pueda haber alterado la intención de la prueba.

Para implementar esto, integre la herramienta de testing en CI de modo que las actualizaciones se ejecuten automáticamente en los PR. Luego establezca una regla: los cambios auto‑reparados deben revisarse dentro de la ventana de lanzamiento. Rastree la reducción de fallos intermitentes y de horas de mantenimiento por sprint como métricas de éxito. Use paneles para exponer tendencias y detectar regresiones temprano. Los equipos también pueden automatizar la reversión de cambios automáticos si el tester marca regresiones.

En la práctica, combine la auto‑reparación con una gobernanza ligera. Conserve ejecuciones de prueba históricas anonimizada para el entrenamiento del modelo. Conecte la herramienta a su sistema de gestión de pruebas para que las aprobaciones y los comentarios queden vinculados. Esto facilita auditar quién aceptó los cambios de la IA. Para equipos que gestionan flujos de correo pesado o incidentes con tickets, nuestra plataforma muestra cómo fundamentar las acciones de la IA en datos operativos y reglas; vea nuestra guía sobre automatizar correos logísticos con Google Workspace y virtualworkforce.ai. Finalmente, acepte que las herramientas de testing con IA reducen el mantenimiento, pero solo con controles y balances en su lugar.

Drowning in emails?

Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

Prioritise testing with ai in qa: defect prediction, test selection and feedback loops (ai in qa, qa teams, feedback loops, metric, defect prediction)

La IA en QA puede predecir dónde es más probable que aparezcan defectos. Usando historial de commits, telemetría y defectos pasados, modelos de ML ordenan los módulos de mayor riesgo. En consecuencia, los equipos de QA pueden ejecutar suites focalizadas en esas áreas en lugar de probarlo todo. Un enfoque dirigido reduce defectos en producción y acelera los lanzamientos. Por ejemplo, ejecute smoke y regresiones dirigidas en un módulo marcado como de alto riesgo, y haga la regresión completa solo cuando sea necesario.

Los estudios muestran que la predicción de defectos asistida por IA incrementa las tasas de detección y permite a los equipos enfocar el esfuerzo de pruebas escaso donde importa. Un informe del sector destaca ganancias de productividad por la ingeniería asistida por IA, aunque señala que las mejoras de calidad varían según el equipo y la configuración el informe explica. Por lo tanto, trate las salidas del modelo como guías, no como absolutos.

Configure bucles de RETROALIMENTACIÓN continuos desde incidentes en producción hacia el entrenamiento del modelo. Alimente telemetría anonimizada y etiquetas de incidentes al conjunto de entrenamiento. Luego reentrene periódicamente para mantener la predicción de riesgo alineada con los cambios recientes. Rastree defectos escapados en producción, tasa de falsos negativos y el porcentaje de pruebas omitidas mediante selección basada en riesgo. Use estas medidas para ajustar umbrales y decidir cuándo ampliar la suite dirigida.

Además, involucre a los ingenieros de QA y a los equipos de qa al afinar modelos. Un ingeniero de QA debe validar las sugerencias del modelo y etiquetar falsos positivos. Esta colaboración mejora los modelos de IA. Los equipos mejoran su capacidad para priorizar incidencias más rápido, y comprenden patrones que antes se ocultaban en el ruido. Para organizaciones que gestionan correo operativo y automatizaciones de procesos, las mismas ideas de bucle de retroalimentación ayudan a corregir clasificaciones erróneas; vea nuestra explicación sobre cómo virtualworkforce.ai reduce el tiempo de gestión y cierra ciclos de retroalimentación.

Integrate ai tools with existing test automation and test management (integrate ai, testing tool, qa tools, framework, test automation)

Para integrar la IA en una pila existente, adopte patrones pragmáticos. Primero, añada un copiloto de IA como asistente de desarrollador o QA en el repositorio. Segundo, conecte la plataforma de testing a su sistema de gestión de pruebas y a CI/CD. Tercero, mapee las salidas de la IA a frameworks de prueba existentes como Selenium, Playwright o JUnit. Por ejemplo, deje que el copiloto abra PRs que añadan pruebas Playwright y las vinculen al ID del ticket correspondiente.

Los elementos de la lista de verificación para la integración incluyen acceso al código base, ejecuciones de prueba históricas anonimizada, telemetría y mapeo de etiquetas entre su gestión de pruebas y las salidas de la IA. Estos metadatos permiten que la IA recomiende escenarios de prueba relevantes. Además, mantenga la trazabilidad: cada caso de prueba generado por IA debe apuntar al requisito y al PR que lo introdujo. Esto mejora la auditabilidad y reduce pruebas duplicadas.

Victorias rápidas incluyen habilitar que el copiloto proponga pruebas como parte de las comprobaciones de pull‑request. Por ejemplo, cuando un PR cambia un flujo de pago, haga que la IA sugiera escenarios de prueba relacionados y cree pruebas para pruebas funcionales y de regresión. Luego, los revisores pueden aceptar o refinar los scripts generados. Esto mantiene el flujo rápido y preserva la calidad. Además, integre la herramienta de testing con el panel para que las partes interesadas vean cobertura y fallos en un solo lugar.

En la práctica, use un modelo de gobernanza ligero. Mantenga un backlog de automatización de pruebas donde aterricen los cambios propuestos por la IA. Luego asigne a un tester para validar. Hacer esto evita desviaciones descontroladas en la suite. Además, asegúrese de que sus frameworks de testing sean compatibles; por ejemplo, las configuraciones modernas de Playwright aceptan código generado con facilidad. Finalmente, cuando integre herramientas de IA, verifique seguridad, políticas de acceso a datos y cumplimiento. Si desea ver cómo los agentes de IA pueden fundamentarse en datos operativos, revise nuestro artículo sobre cómo escalar operaciones logísticas sin contratar personal.

Drowning in emails?

Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

Use cases and QA solutions: who benefits and where to apply ai qa (use cases, qa solutions, software qa, quality engineering, tester)

La IA beneficia muchos casos de uso a lo largo del ciclo de vida de QA. Para bases de código heredadas, la IA puede generar pruebas unitarias para aumentar la cobertura rápidamente. Para suites de regresión, la IA ayuda a mantener pruebas de UI y API actualizadas. Para testing exploratorio, la IA aumenta a los testers proponiendo casos límite o secuencias de entrada inusuales. Para regresión visual, la IA ayuda a detectar regresiones sutiles en el diseño. Estas son soluciones de QA concretas que los equipos pueden desplegar.

Los públicos objetivo incluyen equipos de qa, ingenieros de QA y testers. Los testers pasan de la escritura rutinaria de scripts al diseño de escenarios y a la ingeniería de calidad exploratoria. En la práctica, el rol del tester se vuelve más estratégico. La automatización de pruebas se convierte en una colaboración entre el juicio humano y las propuestas de la IA. Como resultado, los equipos pueden concentrarse en mejorar escenarios de prueba y en el análisis de la causa raíz.

Los beneficios medibles incluyen tiempo ahorrado por lanzamiento, ganancia de cobertura de pruebas y análisis de causa raíz más rápido. Para un piloto, elija un área crítica del producto como un flujo de pago. Aplique IA para crear pruebas automatizadas en capas unitarias, API y UI. Luego mida los resultados antes y después: tiempo para crear pruebas, defectos escapados y tiempo de ejecución de pruebas de regresión. Esta prueba focalizada proporciona un ROI y aprendizajes claros.

También considere usar selecciones de pruebas impulsadas por IA para ejecuciones nocturnas y así reducir costos. Tenga en cuenta que los equipos aún deben evaluar modelos y vigilar sesgos. Casos de uso incluyen QA de software para sistemas financieros, flujos de pago de comercio electrónico e integraciones B2B. Estas son áreas donde la precisión importa y donde la IA puede reducir significativamente el trabajo repetitivo. Finalmente, el futuro de QA incluirá más asistencia de IA, pero el papel humano en definir la intención y validar resultados seguirá siendo esencial.

Governance, limitations and selecting top ai-powered qa tools (ai-powered, ai tools, top ai-powered, chatgpt, machine learning, governance)

La IA introduce tanto poder como riesgos, por lo que la gobernanza importa. Las limitaciones incluyen sesgos del modelo, posible dependencia excesiva y la necesidad de mantener modelos de ML con el tiempo. Un whitepaper advirtió que las organizaciones deben abordar preocupaciones éticas y operacionales al adoptar IA generativa en QA lea el análisis. Por lo tanto, implemente pasos de revisión humana, gobernanza de datos y trazabilidad.

Al seleccionar herramientas potenciadas por IA, evalúe la precisión del modelo, la profundidad de integración con CI/CD y la gestión de pruebas, la calidad de la auto‑reparación y la explicabilidad. También verifique seguridad y cumplimiento. Cree una rúbrica de adquisiciones de una página que puntúe a los proveedores por integración, sobrecarga de mantenimiento y ROI esperado. Por ejemplo, candidatos a evaluar incluyen Copilot/GitHub Copilot, Testim, Mabl, Diffblue, Functionize y Applitools. Puntúelos según qué tan bien se integran en sus frameworks, como Playwright o JUnit, y cómo ayudan a mantener las pruebas automatizadas.

También exija a los proveedores que muestren cómo manejan los datos y cómo reentrenan los modelos. Solicite un plan de adopción de 90 días con métricas de éxito como ganancia de cobertura, velocidad de pruebas y reducción de defectos escapados. Además, incluya un piloto que use una prueba de IA en un entorno controlado. Durante el piloto, involucre a equipos de QA, equipos de desarrollo y revisores de seguridad. Esta revisión cross‑funcional evita sorpresas y asegura que la herramienta permita a los equipos mantener el control.

Finalmente, tenga en cuenta herramientas como chatgpt para ideación y fragmentos de código, pero sepárelas de los sistemas de producción. Para automatización de grado productivo, prefiera herramientas de testing con IA dedicadas que se vinculen a su gestión de pruebas y CI. Mantenga un bucle continuo de retroalimentación para que los incidentes de producción refinjen el entrenamiento del modelo. Este enfoque de gobernanza asegura que la IA se convierta en una parte sólida de sus esfuerzos de gestión de calidad minimizando el riesgo.

Preguntas frecuentes

¿Qué es un copiloto de IA para QA?

Un copiloto de IA para QA es un asistente que propone casos de prueba, genera fragmentos de código y sugiere scripts de prueba basados en requisitos, código y telemetría. Acelera la redacción, pero un revisor humano debe validar las salidas antes del lanzamiento.

¿Con qué rapidez pueden los equipos ver valor desde un piloto de IA?

Los equipos suelen ver valor inicial dentro de dos semanas de un piloto focalizado que alimente unas pocas historias de usuario en el copiloto. Esto revela ahorro de tiempo, rendimiento de borradores de prueba y mejoras de cobertura.

¿Las herramientas de testing con IA eliminan automáticamente las pruebas inestables?

Las herramientas de testing con IA pueden reducir la inestabilidad usando localizadores auto‑reparables e identificación más inteligente de elementos. Sin embargo, los equipos deben revisar los cambios automáticos y mantener salvaguardas para evitar deriva.

¿Cómo priorizo las pruebas con IA?

Use predicción de defectos basada en ML que ordene módulos por riesgo usando historial de commits y telemetría. Luego ejecute suites dirigidas en áreas de alto riesgo y alimente incidentes de vuelta al entrenamiento para mejora continua.

¿La IA puede generar pruebas unitarias para código legado?

Sí, la IA puede generar pruebas unitarias que aumenten la cobertura para código legado. Los equipos deben revisar las pruebas generadas e integrarlas en la canalización de CI para asegurar estabilidad.

¿Qué gobernanza se necesita para la IA en QA?

La gobernanza requiere revisión humana, controles de acceso a datos, registros de auditoría y políticas de reentrenamiento para modelos de IA. Estos elementos reducen sesgos, aseguran trazabilidad y mantienen la calidad con el tiempo.

¿Qué herramientas debería evaluar primero?

Comience con proveedores que se integren con su CI y gestión de pruebas. Considere Copilot/GitHub Copilot para fragmentos y evalúe Testim, Mabl, Diffblue, Functionize y Applitools para una automatización más completa.

¿Cómo trabajan juntas la IA y QA tradicional?

La IA aumenta a QA tradicional asumiendo tareas repetitivas, proponiendo escenarios de prueba y manteniendo suites actualizadas. Los testers humanos se enfocan en testing exploratorio, validación y diseño de escenarios.

¿Es útil chatgpt para generar pruebas?

ChatGPT puede idear y redactar escenarios de prueba, pero las pruebas de producción deben provenir de herramientas que se vinculen directamente a CI y gestión de pruebas para trazabilidad y reproducibilidad.

¿Cómo debo medir el éxito de un despliegue de IA en QA?

Mida ganancia de cobertura, velocidad de pruebas, reducción de horas de mantenimiento y defectos escapados en producción. Use estas métricas para iterar sobre herramientas y planes de gobernanza.

Drowning in emails?

Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.