ai cybersecurity: come gli assistenti AI rilevano le minacce in tempo reale

L’AI aiuta i TEAM DI SICUREZZA a rilevare anomalie e minacce su larga scala, e lo fa in modo continuo. Ad esempio, un assistente AI può monitorare i log, correlare la telemetria e generare un avviso in tempo reale quando i pattern corrispondono a una firma nota o a un’impronta comportamentale insolita. Questa capacità è importante perché il 77% delle aziende sta già usando o esplorando l’AI nelle operazioni, il che spiega la forte adozione dell’AI negli ambienti aziendali statistica del 77% di adozione. In pratica, l’ingestione di telemetria guidata dall’AI, l’estrazione delle feature e la valutazione girano molte volte più velocemente rispetto alla revisione manuale. Il flusso tipico inizia con telemetria → un modello AI → triage degli avvisi → risposta. Un semplice ciclo potrebbe essere questo: i sensori alimentano dati endpoint e di rete, il modello AI valuta le anomalie, il sistema genera un avviso e quindi la contenimento attiva un playbook. Questo è particolarmente utile per il rilevamento delle minacce in tempo reale, dove i minuti contano.

Gli strumenti di cybersecurity basati su AI già alimentano molte pipeline di detection e response. Una review sull’Agentic AI osserva che l’AI agentica può adattarsi alle minacce emergenti e agire con autonomia cognitiva quando configurata per farlo AI agentica nella cybersecurity. Pertanto, le piattaforme che combinano baseline comportamentali con analisi in streaming riducono il dwell time e mettono in evidenza comportamenti sconosciuti. In un breve caso d’uso, il sistema rileva un pattern di movimento laterale, emette un avviso, isola l’endpoint e scala l’incidente al SOC per la revisione. Quel ciclo di contenimento automatizzato fa risparmiare tempo e riduce l’errore umano.

Gli architetti della sicurezza devono decidere cosa automatizzare e cosa lasciare agli analisti. Per il monitoraggio in tempo reale, l’AI può filtrare il rumore e dare priorità alle minacce in modo che i team di sicurezza possano concentrarsi sugli incidenti ad alto rischio. Allo stesso tempo, i team dovrebbero richiedere provenienza e punteggi di confidenza per ogni raccomandazione, perché gli studi mostrano che le uscite dell’AI possono includere inesattezze e fallimenti di sourcing che contano in un contesto di sicurezza studio sui fallimenti di sourcing. Inoltre, i vendor ora offrono piattaforme di cybersecurity potenziate dall’AI che si integrano con SIEM, EDR e feed cloud, permettendo un workflow di detection e response rapido mantenendo gli umani nel loop per decisioni critiche.

Per le organizzazioni che gestiscono un alto carico di email, esistono anche applicazioni operative dell’AI. Ad esempio, virtualworkforce.ai usa agenti AI per automatizzare il ciclo di vita delle email per i team operativi, instradare i messaggi e allegare il contesto alle escalation. Questo riduce il tempo perso nel triage e aiuta i team a mantenere una postura di sicurezza più solida nelle comunicazioni. In breve, la ai cybersecurity in azione sia rileva le minacce in tempo reale sia aiuta a snellire l’overhead operativo che altrimenti può distrarre il personale del SOC.

security operations: usare un assistente AI per accelerare rilevamento e risoluzione

Le security operations si basano su workflow rapidi e ripetibili. L’AI può automatizzare timeline forensi, eseguire playbook e accelerare la risoluzione mentre il SOC mantiene il controllo. Ad esempio, le integrazioni tra XDR e SOAR consentono a un motore di suggerimenti potenziato dall’AI di proporre step di contenimento, e poi un ingegnere può approvarli o sovrascriverli. Questa combinazione di automazione e supervisione umana riduce il mean time to detect e il mean time to remediate. Infatti, l’automazione riduce il carico degli analisti e può diminuire i falsi positivi quando le correlazioni XDR filtrano segnali rumorosi.

I casi d’uso mostrano benefici pratici. Un modello AI può analizzare migliaia di avvisi, raggruppare incidenti simili e generare un breve riepilogo per un analista. Poi l’analista decide se scalare l’incidente. Per i casi di phishing di routine, il sistema può mettere in quarantena i messaggi e marcare gli endpoint interessati, e poi il SOC revisiona l’azione automatizzata. Questo approccio aiuta i team SOC a concentrarsi sulle indagini che richiedono giudizio umano. Inoltre, l’automazione della raccolta delle evidenze e della costruzione della timeline accelera le indagini e riduce il rischio di indicatori mancati.

I team dovrebbero seguire una checklist di change-management prima di abilitare azioni automatiche. Primo, definire soglie e punteggi di confidenza. Secondo, mappare i playbook ai ruoli e alle approvazioni. Terzo, implementare monitoraggio e rollback. Quarto, registrare ogni step automatizzato per l’auditabilità. Questi passaggi aiutano a salvaguardare l’ambiente e mantenere la conformità. Una dashboard pratica mostra i suggerimenti dell’AI con override chiari; questo snellisce il workflow e preserva la responsabilità.

Le metriche da monitorare includono avvisi triageati per ora, tasso di falsi positivi e tempo alla contenimento. Questi KPI dimostrano miglioramenti mantenendo i team responsabili. Inoltre, il SOC dovrebbe eseguire controlli periodici di red-team e incidenti simulati per convalidare il modello AI e ridurre il bias di automazione tra gli analisti. La ricerca indica che il bias di automazione colpisce una larga quota di professionisti della sicurezza, motivo per cui i passaggi di verifica obbligatori sono importanti fattori umani e bias di automazione. Infine, i team dovrebbero documentare quando il sistema usa l’AI per scalare automaticamente e quando attende l’approvazione umana. Questa politica chiara aiuta sia i CISO sia i responder di primo livello.

Quando le vostre operazioni includono flussi email intensi, considerate di combinare l’automazione della sicurezza con piattaforme di automazione email. virtualworkforce.ai aiuta i team a instradare e risolvere email operative, riducendo i contesti rumorosi che altrimenti sprecano tempo del SOC. Per saperne di più sull’automazione della corrispondenza logistica, vedi questa risorsa sulla corrispondenza logistica automatizzata.

Drowning in emails?

Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

xdr e darktrace: esempi di AI agentica nel rilevamento esteso

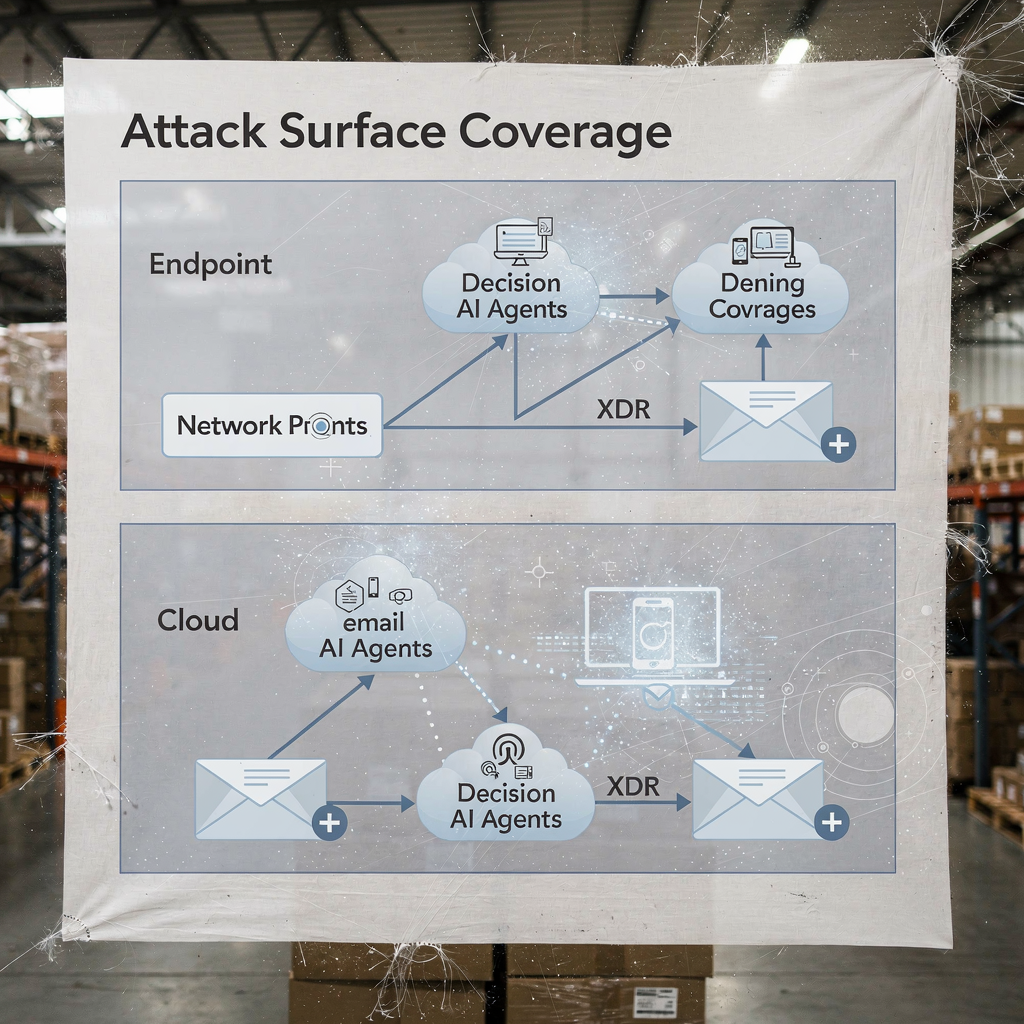

Le piattaforme di extended detection and response unificano segnali da endpoint, rete, cloud e email. L’XDR correla queste sorgenti di telemetria e applica modelli per rivelare percorsi di attacco complessi. Darktrace offre modellazione comportamentale e funzionalità di AI agentica che si adattano a baseline in cambiamento. Nei recenti aggiornamenti di prodotto, Darktrace ha enfatizzato forensics autonome e risposte adattive, in cui la piattaforma può intraprendere azioni di contenimento e generare ragionamenti leggibili dall’uomo per quei passi. Questo approccio dà ai team una via più rapida per rilevare e rispondere sia a minacce note sia a minacce nuove.

Uno scenario tipico inizia con un comportamento anomalo dell’endpoint che non corrisponde a una firma nota. L’XDR correla quell’azione con flussi di rete insoliti, e la piattaforma segnala movimento laterale. Poi un’azione di contenimento isola l’endpoint, mentre l’analisi forense automatizzata cattura artefatti. Gli esempi di AI di Darktrace mostrano come il machine learning può mappare le azioni di un attaccante attraverso i dispositivi e poi suggerire una risposta che isoli la superficie di attacco. Quella sequenza aiuta a difendersi da ransomware e propagazione laterale.

L’integrazione pratica richiede una checklist. Primo, assicurarsi che il vostro XDR si colleghi a SIEM e SOAR per l’enrichment degli eventi. Secondo, mappare i playbook di risposta per azioni automatiche rispetto a quelle manuali. Terzo, configurare la piattaforma per esportare il contesto a ticketing e email, così i team SOC mantengono tracciabilità end-to-end. Quarto, testare i passaggi EDR-to-XDR e confermare la fedeltà della telemetria. Un diagramma stratificato della copertura XDR e dei punti decisionali AI chiarisce chi agisce e quando.

I benefici dell’XDR si estendono alla sicurezza cloud e alla sicurezza email. La piattaforma combina telemetria endpoint, flussi di rete e threat intelligence per creare un quadro più ampio della postura di sicurezza aziendale. Nelle implementazioni che coinvolgono Darktrace, i team di sicurezza possono vedere approfondimenti sul comportamento dell’attaccante e opzioni di contenimento rapide. Tuttavia, i team dovrebbero convalidare le decisioni dell’AI agentica tramite audit e mantenere un log di ogni passo eseguito autonomamente per governance. Per le organizzazioni nel settore logistico e operativo, integrare gli insight XDR con l’automazione email aiuta a mantenere la continuità mentre si triagiano le minacce che arrivano via phishing o account compromessi. Vedi come l’AI può scalare la comunicazione delle spedizioni e preservare il contesto nei messaggi operativi IA per la comunicazione con gli spedizionieri.

analista: bias di automazione, limiti di accuratezza e l’AI come supporto decisionale

I fattori umani plasmano il modo in cui i team adottano l’AI. Il bias di automazione e il bias di conferma possono portare gli analisti della sicurezza a sovrafidarsi delle uscite dell’AI. Gli studi mostrano che il bias di automazione colpisce una larga frazione di praticanti, e gli analisti devono imparare a trattare l’AI come un supporto decisionale piuttosto che come un oracolo fattori umani nella cybersecurity guidata dall’AI. Inoltre, la ricerca ha rilevato che molte risposte generate dall’AI contengono inesattezze e problemi di sourcing, il che è critico per la risposta agli incidenti dove la fiducia nei fatti conta fallimenti di sourcing degli assistenti AI. Pertanto, i leader del SOC dovrebbero aggiungere passaggi di verifica obbligatori e soglie di confidenza a ogni raccomandazione automatizzata.

La formazione gioca un ruolo importante. I team dovrebbero eseguire esercitazioni scenari, attività di red-team e richiedere agli analisti di convalidare le evidenze prima di chiudere un incidente. Un controllo pratico è presentare la provenienza per ogni raccomandazione in modo che gli analisti possano ricondurre gli avvisi ai log grezzi e agli stati del modello AI. Inoltre, introdurre procedure di gestione degli errori che specifichino cosa fare quando il sistema mostra bassa confidenza o uscite incoerenti. Questo processo riduce il rischio e mantiene gli umani impegnati nel pensiero critico.

La trasparenza aiuta anche. Presentare un riepilogo del perché è emerso un suggerimento, i segnali che lo hanno supportato e la versione del modello che lo ha generato costruisce fiducia. Per il lavoro analitico che usa riassunti in linguaggio naturale, etichettarli chiaramente evita la sovra-affidabilità. Poiché l’AI è ora ampiamente usata, i team devono bilanciare velocità e scrutinio. L’uso di punteggi di confidenza e la richiesta di una firma dell’analista per le escalation riducono l’automazione cieca.

Infine, proteggersi dallo shadow AI nei team. Lo shadow AI si verifica quando gli individui usano strumenti genAI non autorizzati o servizi gen AI per risposte rapide. Questa pratica può far trapelare dati sensibili e introdurre logiche incoerenti nelle indagini. Stabilire strumenti genAI approvati e un workflow sicuro per ogni query o chiamata modello esterna. Fornire agli analisti una via chiara per scalare i casi complessi. In breve, l’AI dovrebbe potenziare l’analista, non sostituire il giudizio.

Drowning in emails?

Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

vulnerabilità e dati sensibili: l’AI per monitorare, difendere e creare nuovi rischi

L’AI aiuta a trovare vulnerabilità e a difendere i dati sensibili, eppure introduce rischi di doppio uso. Sul lato difensivo, l’AI per monitorare i log e il traffico web può rilevare pattern che indicano tentativi di sfruttamento di CVE, e quindi attivare la remediation per patchare o isolare i workload interessati. Allo stesso tempo, attori malintenzionati possono distribuire agenti AI per automatizzare il reconnaissance, creare phishing mirati e persino generare varianti di malware. Articoli sulle minacce emergenti segnalano l’aumento di impiegati AI automatizzati o malevoli che possono svolgere social engineering interno simile a un insider minaccia degli impiegati AI malevoli. Quella dualità aumenta la posta in gioco su come gestire l’accesso ai dati sensibili.

Le preoccupazioni sulla privacy emergono quando l’AI accede a log che contengono PII o segreti operativi. Per proteggersi dalle fughe, applicare rigide politiche di accesso ai dati, usare filtraggio in input/output e preferire deployment on-premise o modelli privati per workload ad alta sensibilità. Inoltre, registrare tutte le azioni e le query dell’AI così da poter ricostruire le decisioni e identificare eventuali egressi di dati anomali. Per i team che gestiscono email operative, assicurarsi che le piattaforme di automazione email applichino data-grounding e governance attraverso ERP e fonti documentali per prevenire divulgazioni accidentali. Esplora come l’automazione email preserva il contesto e riduce le ricerche manuali nei workflow logistici automazione email ERP per la logistica.

Progettare controlli per rilevare attività AI malevole. Monitorare volumi di query anomali e pattern insoliti che possono indicare uno strumento di discovery automatizzato o una pipeline di esfiltrazione. Implementare throttling e quote sulle query che accedono a grandi dataset. Condurre threat hunting assumendo che gli attaccanti possano sfruttare l’AI generativa per creare phishing polimorfico e messaggi di social engineering plausibili su scala. Inoltre, rivedere le uscite del modello per allucinazioni o affermazioni non supportate, perché i fallimenti di sourcing possono fuorviare gli analisti e esporre i sistemi a passi di remediation errati.

Infine, proteggere i modelli stessi. Attacchi di model poisoning e data poisoning possono alterare i modelli di apprendimento e ridurre l’accuratezza della detection. La convalida periodica dei modelli e i controlli di provenienza dei dati aiutano a rilevare precocemente tentativi di avvelenamento. Mantenere versioni firmate dei modelli e un piano di rollback per modelli compromessi o degradati. Presi insieme, questi passaggi aiutano a difendere i dati sensibili consentendo all’AI di monitorare e proteggere i sistemi in modo efficace.

sicurezza AI e cybersecurity proattiva: governance, validazione e AI a ogni fase

La governance rimane la base per un’adozione sicura dell’AI. Implementare validazione del modello, test continui, spiegabilità e politiche di lifecycle prima dei rollout estesi. Richiedere controlli di provenienza e sourcing, eseguire audit periodici di accuratezza e usare rollout graduali con criteri di rollback. Questi controlli si allineano con obblighi normativi come il GDPR e le linee guida UE su minimizzazione dei dati e trasparenza. Inoltre, includere i CISO nelle revisioni di governance e richiedere playbook di incidente chiari che coprano i fallimenti del modello.

Passaggi pratici includono test pre-deployment, monitoraggio runtime, playbook di incidente e criteri di rollback definiti. Ad esempio, tenere una dry run pre-distribuzione che metta il modello AI contro un corpus di test che includa campioni maligni noti, traffico rumoroso e voci sensibili alla privacy. Poi monitorare drift e accuratezza in produzione e pianificare audit mensili. Usare strumenti di spiegabilità per fornire agli analisti il razionale dietro decisioni chiave. Tali passaggi rendono le soluzioni di cybersecurity potenziate dall’AI verificabili e affidabili.

Adottare una checklist per l’uso in produzione: confermare i controlli di accesso, implementare sanitizzazione degli input, impostare politiche di retention e richiedere log firmati di ogni azione automatizzata. Monitorare KPI come tasso di falsi positivi, tempo alla contenimento e percentuale di avvisi risolti con supervisione umana. Inoltre, preparare una roadmap per i primi 90 giorni di qualsiasi deploy AI: metriche baseline, trial in sandbox, abilitazione graduale, formazione e approvazione della governance. Questo approccio aiuta a fornire una cybersecurity proattiva che può rilevare sia minacce note sia minacce sconosciute.

Infine, bilanciare innovazione e cautela. L’AI avanzata e il deep learning portano nuove capacità agli strumenti dei difensori, ma la governance mantiene queste capacità allineate con la vostra postura di sicurezza. Se avete bisogno di scalare le operazioni senza aumentare l’organico, esplorate l’automazione dei flussi ripetitivi come la gestione delle email operative; virtualworkforce.ai mostra come gli agenti AI possono ridurre i tempi di gestione e mantenere il contesto allegato alle escalation, supportando sia la produttività sia gli obiettivi di sicurezza. Iniziate in piccolo, misurate l’impatto e iterate con chiare regole di governo.

FAQ

What is an AI assistant in cybersecurity?

Un assistente AI nella cybersecurity è un agente automatizzato che aiuta a monitorare, analizzare e prioritizzare gli eventi di sicurezza. Fornisce supporto decisionale, automatizza attività investigative di routine e mette in evidenza avvisi ad alta confidenza per la revisione umana.

How do AI systems detect threats in real time?

I sistemi AI ingeriscono telemetria da endpoint, rete e cloud, poi applicano modelli per rilevare anomalie che indicano compromissione. Valutano gli eventi, raggruppano attività correlate e generano avvisi in tempo reale così i team possono agire rapidamente.

Can AI reduce mean time to detect (MTTD)?

Sì. L’AI accelera il triage raggruppando avvisi, riassumendo le evidenze e suggerendo step di playbook, il che riduce l’MTTD. Tuttavia, i team devono convalidare le uscite per evitare bias di automazione e falsi positivi.

What is XDR and how does it use AI?

XDR sta per extended detection and response e unifica segnali da endpoint, rete, cloud e email. Le piattaforme XDR usano agenti AI e modelli comportamentali per correlare eventi e suggerire azioni di contenimento.

Are AI recommendations always accurate?

No. Gli studi mostrano che le raccomandazioni dell’AI possono includere inesattezze e fallimenti di sourcing, quindi le organizzazioni devono richiedere provenienza, punteggi di confidenza e verifica umana. Audit regolari e convalide riducono il rischio di azioni errate.

How do you prevent AI from leaking sensitive data?

Limitare l’accesso ai modelli, usare filtraggio in input/output, preferire opzioni on-premise o modelli privati per workload sensibili e registrare ogni azione dell’AI. Politiche di accesso ai dati e regole di retention riducono anche il rischio di fuga di dati.

What is automation bias and how does it affect security analysts?

Il bias di automazione si verifica quando gli analisti si fidano eccessivamente delle uscite dell’AI e trascurano la verifica indipendente. Può causare anomalie non rilevate; formazione, soglie di confidenza e passaggi di verifica obbligatori aiutano a mitigarlo.

How should organisations govern AI in security?

La governance dovrebbe includere test pre-deployment, monitoraggio continuo, spiegabilità, controlli di provenienza e rollout graduali. Allineate questi controlli con requisiti normativi come il GDPR e i framework di compliance interni.

Can AI help with email-related security and operations?

Sì. L’AI può automatizzare il triage delle email, classificare l’intento, allegare il contesto e redigere risposte preservando i tracciati di audit. Strumenti che ancorano le risposte a ERP e sistemi documentali possono ridurre le ricerche manuali e le esposizioni di sicurezza. Per esempi sull’automazione delle email nella logistica, vedi questa risorsa su IA nella comunicazione per la logistica delle merci.

What are the first steps to deploy an AI assistant safely?

Iniziate con un piccolo pilot, definite i KPI, eseguite la validazione del modello e richiedete approvazioni human-in-the-loop per azioni ad alto impatto. Preparate anche piani di rollback e formate gli analisti su gestione degli errori e procedure di verifica.

Drowning in emails?

Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.