Hoe een AI-copilot QA-teams helpt testcreatie te automatiseren (ai, qa, copilot, testcreatie)

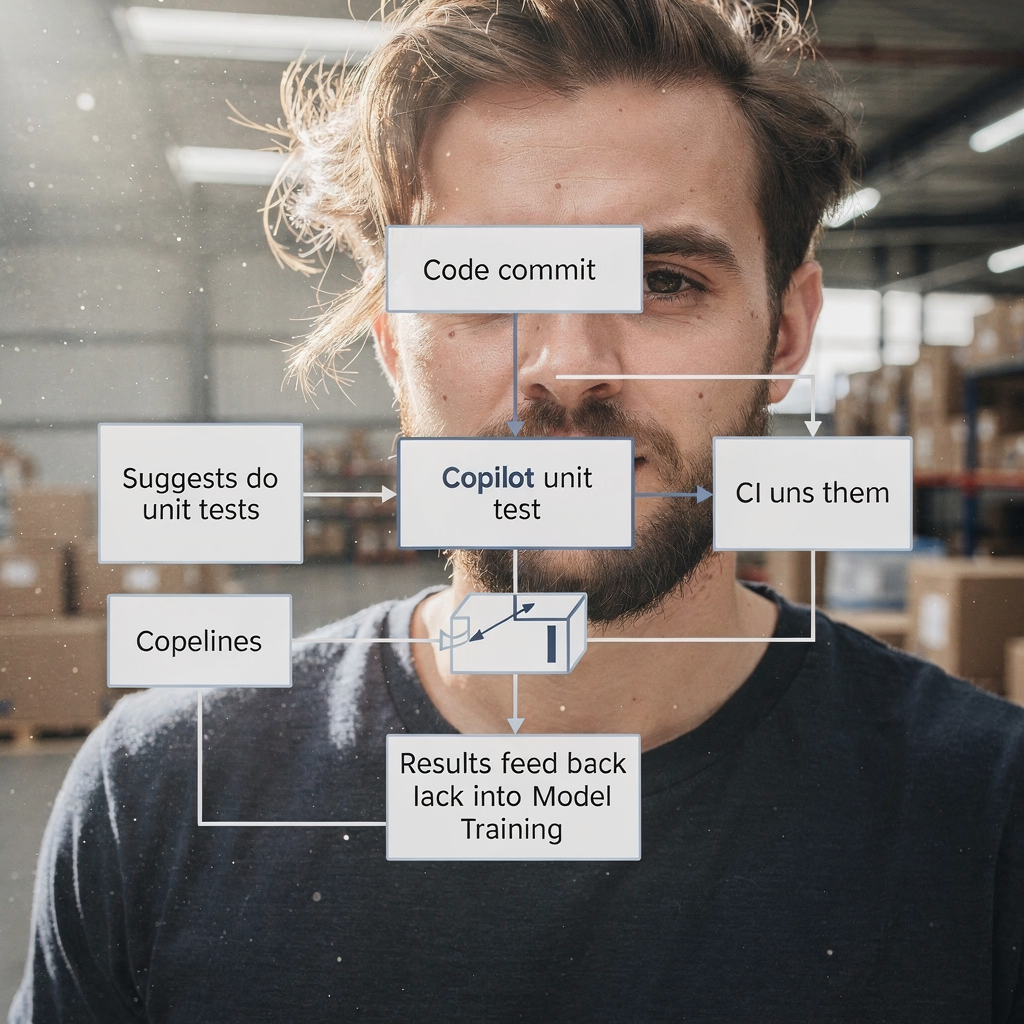

AI versnelt de TESTCREATIE door requirements, code en gebruikersflows om te zetten in bruikbare testconcepten. Eerst leest een copilot user stories en code‑diffs. Vervolgens stelt hij testcaseramers, unittests en UI‑stappen voor. Ter context voorspelt Gartner een snelle adoptie van codeassistenten voor engineers; tegen 2028 zal driekwart van de enterprise software‑engineers AI‑codeassistenten gebruiken volgens brancheverslaggeving. Ook verkorten teams die een copilot inzetten vaak de tijd van story naar geautomatiseerde test.

AI kan bijvoorbeeld unittests opstellen vergelijkbaar met Diffblue, UI‑flows maken zoals Testim of Mabl, en visuele assertions voorstellen zoals Applitools. Daarnaast kunnen tests in natuurlijke taal worden geproduceerd die lezen als acceptatiecriteria, vergelijkbaar met Functionize. Deze outputs variëren van korte testcasetoevoegsels tot volledige testscripts. Voor unit‑testen gebruikt u een AI‑copilot om JUnit‑ of Playwright‑voorbeelden te genereren en deze vervolgens te verfijnen. Voor UI‑werk vraagt u de copilot om de stappen te exporteren naar een testframework of naar Playwright‑code. Dit scheelt repetitief scripteringswerk.

Meet de impact met eenvoudige KPI’s. Houd de tijd tot de eerste geautomatiseerde test bij en het percentage toename in testdekking per sprint. Houd ook het aantal testscenarioconcepten per user story bij. Een snelle actie is een twee‑weekse pilot waarbij drie tot zes user stories aan een AI‑copilot worden gevoed, en vervolgens de manuele versus AI‑testopbrengst te vergelijken. Deze pilot kan dekkingstoenames aantonen, lacunes in de contextafhandeling van de copilot blootleggen en laten zien hoe makkelijk teams tests in de CI‑pipeline kunnen plaatsen.

In de praktijk integreert u de suggesties van de copilot in een PR‑workflow. Laat de copilot testbestanden voorstellen op de featurebranch. Laat daarna een QA‑engineer of tester de voorgestelde tests reviewen. Dit vermindert de tijd die aan boilerplate wordt besteed. Tot slot beseffen teams dat een AI‑copilot het schrijven versnelt zonder menselijk oordeel te vervangen. Voor meer informatie over het automatiseren van operationele berichten en soortgelijke workflows, zie onze bron over hoe logistieke operaties met AI‑agenten op te schalen.

Gebruik AI‑testtools om het QA‑proces te automatiseren en testonderhoud te verminderen (ai testtools, automatiseren, QA proces, geautomatiseerde test, zelfherstellend)

AI‑testtools bieden zelfherstellende locators en functies voor elementidentificatie die flaky tests drastisch verminderen. Bijvoorbeeld passen tools zoals Testim en Mabl selectors aan wanneer de DOM verandert. Als gevolg besteden teams minder uren aan het repareren van breekbare testscripts. Ook kunnen deze tools visuele diffs annoteren, wat helpt om visual regression checks accuraat te houden. Gebruik een geautomatiseerde testrunner die zelfherstel ondersteunt zodat de testpipeline betrouwbaar blijft.

Echter, AI haalt de noodzaak van waarborgen niet weg. Review automatisch bijgewerkte tests voordat ze vrijgegeven worden en houd een mens in de lus. Een recente whitepaper stelt: “AI can support many aspects of QA, but it also introduces critical risks that demand careful attention” volgens brancheanalyse. Onderhoud daarom goedkeuringspoorten en integreer changelogs. Gebruik ook telemetry om te detecteren wanneer zelfherstel de intentie van een test heeft verschoven.

Om dit te implementeren, integreert u de testingtool in CI zodat updates automatisch op PR’s draaien. Stel vervolgens een regel in: zelfherstelde wijzigingen moeten binnen het releasevenster worden beoordeeld. Volg vermindering in flaky failures en onderhoudsuren per sprint als succesmetrics. Gebruik dashboards om trends zichtbaar te maken en regressies vroeg te signaleren. Teams kunnen ook rollback van automatische wijzigingen automatiseren als een tester regressies meldt.

In de praktijk combineert u zelfherstel met lichte governance. Bewaar geanonimiseerde historische testruns voor modeltraining. Koppel de tool aan uw testmanagementsysteem zodat goedkeuringen en opmerkingen gekoppeld blijven. Zo wordt het makkelijker te auditen wie AI‑wijzigingen heeft geaccepteerd. Voor teams die veel met e‑mailworkflows of getickette incidenten werken, laat ons platform zien hoe AI‑acties in operationele data en regels geworteld kunnen worden; zie onze gids over het automatiseren van logistieke e-mails met Google Workspace en virtualworkforce.ai. Accepteer tenslotte dat AI‑testtools onderhoud verminderen, maar alleen met checks en balances.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

Prioriteer testen met AI in QA: defectvoorspelling, testselectie en feedbackloops (ai in qa, QA‑teams, feedbackloops, metriek, defectvoorspelling)

AI in QA kan voorspellen waar defects het meest waarschijnlijk optreden. Met behulp van commitgeschiedenis, telemetry en eerdere defects rangschikken ML‑modellen risicovolle modules. Als gevolg kunnen QA‑teams gerichte suites draaien op die gebieden in plaats van overal te testen. Een doelgerichte aanpak vermindert ontsnapte defects en versnelt releases. Bijvoorbeeld: voer een smoke en gerichte regression uit op een module die als hoog risico is aangemerkt, en voer alleen indien nodig een volledige regression uit.

Studies tonen aan dat AI‑ondersteunde defectvoorspelling detectieratio’s verhoogt en teams in staat stelt schaarse testinspanning te richten waar het ertoe doet. Een industrieel rapport belicht productiviteitswinst door AI‑ondersteund engineering, en merkt op dat kwaliteitsverbeteringen per team en setup variëren het rapport legt uit. Behandel modeloutput daarom als richtlijn, niet als absolute waarheid.

Zet continue FEEDBACKLOOPS op van productie‑incidenten terug naar modeltraining. Voer geanonimiseerde telemetry en incidenttags in de trainingsset. Retrain vervolgens periodiek om risicovoorspelling afgestemd te houden op recente wijzigingen. Volg ontsnapte defects in productie, false negative rate, en het percentage tests dat wordt overgeslagen via risicogebaseerde selectie. Gebruik deze maatstaven om drempels bij te stellen en te beslissen wanneer het gerichte testpakket moet worden uitgebreid.

Betrek ook QA‑engineers en QA‑teams bij het afstemmen van modellen. Een QA‑engineer zou modelvoorstellen moeten valideren en false positives labelen. Deze samenwerking verbetert de AI‑modellen. Teams verbeteren hun vermogen om issues sneller te triageren, en teams krijgen inzicht in patronen die eerder in de ruis verborgen waren. Voor organisaties die operationele e‑mail- en procesautomatiseringen beheren, helpen dezelfde feedbackloopideeën bij het corrigeren van foutieve classificaties; zie onze uitleg over hoe virtualworkforce.ai handelingstijd vermindert en feedbackcycli sluit.

Integreer AI‑tools met bestaande testautomatisering en testmanagement (integrate ai, testing tool, qa tools, framework, test automation)

Om AI in een bestaande stack te integreren, hanteer pragmatische patronen. Voeg eerst een AI‑copilot toe als ontwikkelaar of QA‑assistent in de repository. Koppel vervolgens het testingplatform aan uw testmanagementsysteem en CI/CD. Breng AI‑outputs in kaart met bestaande testframeworks zoals Selenium, Playwright of JUnit. Laat de copilot bijvoorbeeld PR’s openen die Playwright‑tests toevoegen en link deze aan het bijbehorende ticket‑ID.

Checklistitems voor integratie zijn toegang tot de codebase, geanonimiseerde historische testruns, telemetry en tagmapping tussen uw testmanagement en AI‑outputs. Deze metadata stelt de AI in staat relevante testscenario’s aan te bevelen. Zorg ook voor traceerbaarheid: elke AI‑gegenereerde testcase moet terugverwijzen naar het requirement en de PR die het introduceerde. Dit verbetert auditbaarheid en vermindert dubbele tests.

Snelle winsten zijn onder andere het inschakelen van de copilot om tests voor te stellen als onderdeel van pull‑request checks. Bijvoorbeeld: wanneer een PR een betaalflow wijzigt, laat de AI gerelateerde testscenario’s voorstellen en tests aanmaken voor functionele en regressietests. Reviewers kunnen de gegenereerde testscripts vervolgens accepteren of verfijnen. Dit houdt de workflow snel terwijl de kwaliteit behouden blijft. Integreer daarnaast de testingtool met het dashboard zodat stakeholders dekking en failures op één plek zien.

In de praktijk gebruikt u een lichte governance‑aanpak. Houd een testautomatiseringsbacklog bij waar voorgestelde AI‑wijzigingen landen. Wijs daarna een tester toe om te valideren. Zo voorkomt u ongeregistreerde drift in de suite. Zorg er ook voor dat uw testframeworks compatibel zijn; moderne Playwright‑setups accepteren bijvoorbeeld eenvoudig gegenereerde code. Tot slot, wanneer u AI‑tools integreert, controleer security, data‑toegangsbeleid en compliance. Als u wilt zien hoe AI‑agenten in operationele data kunnen worden verankerd, bekijk dan ons artikel over hoe logistieke operaties zonder personeel op te schalen.

Drowning in emails? Here’s your way out

Save hours every day as AI Agents draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

Use cases and QA solutions: who benefits and where to apply ai qa (use cases, qa solutions, software qa, quality engineering, tester)

AI brengt voordelen voor veel use cases in de QA‑levenscyclus. Voor legacy‑codebases kan AI unittests genereren om snel coverage te vergroten. Voor regressiesuites helpt AI UI‑ en API‑tests actueel te houden. Voor exploratory testing ondersteunt AI testers door edgecases of ongewone inputsequenties voor te stellen. Voor visual regression helpt AI subtiele lay‑outregressies te detecteren. Dit zijn concrete QA‑oplossingen die teams kunnen inzetten.

Doelgroepen zijn onder meer QA‑teams, QA‑engineers en testers. Testers verschuiven van routinematig scripten naar scenarioontwerp en verkennende quality engineering. In de praktijk wordt de rol van de tester strategischer. Testautomatisering wordt een samenwerking tussen menselijk oordeel en AI‑voorstellen. Daardoor kunnen teams zich richten op het verbeteren van testscenario’s en root‑cause analysis.

Meetbare voordelen zijn onder andere tijdsbesparing per release, toename in testdekking en snellere root‑causeanalyse. Voor een pilot kiest u een kritisch productgebied zoals een betaalflow. Pas AI toe om geautomatiseerde tests voor unit, API en UI‑lagen te creëren. Meet vervolgens resultaten vóór en ná: tijd om tests te maken, ontsnapte defects en regressietestuitvoeringstijd. Deze gerichte proef levert duidelijke ROI en leerpunten op.

Overweeg ook AI‑gestuurde testselecties voor nachtelijke runs om kosten te verlagen. Let erop dat teams modellen moeten evalueren en moeten letten op bias. Use cases omvatten software QA voor financiële systemen, e‑commerce checkout‑flows en B2B‑integraties. Dit zijn gebieden waar nauwkeurigheid telt en waar AI repetitief werk substantieel kan verminderen. Ten slotte zal de toekomst van QA meer AI‑assistentie bevatten, maar blijft de menselijke rol in het bepalen van intentie en valideren van uitkomsten essentieel.

Governance, limitations and selecting top ai-powered qa tools (ai-powered, ai tools, top ai-powered, chatgpt, machine learning, governance)

AI brengt zowel kracht als risico’s, dus governance is belangrijk. Beperkingen omvatten modelbias, mogelijke over‑afhankelijkheid en de noodzaak om ML‑modellen in de loop van de tijd te onderhouden. Een whitepaper waarschuwde dat organisaties ethische en operationele zorgen moeten adresseren bij het adopteren van generatieve AI in QA lees de analyse. Implementeer daarom menselijke reviewstappen, datagovernance en traceerbaarheid.

Bij het selecteren van AI‑tools evalueert u modelaccuratesse, integratiediepte met CI/CD en testmanagement, kwaliteit van zelfherstel en uitlegbaarheid. Controleer ook security en compliance. Maak een eendelige inkooprubriek die leveranciers scoort op integratie, onderhoudslast en verwachte ROI. Kandidaten om te evalueren zijn bijvoorbeeld Copilot/GitHub Copilot, Testim, Mabl, Diffblue, Functionize en Applitools. Beoordeel hoe goed ze in uw frameworks zoals Playwright of JUnit passen en hoe ze helpen geautomatiseerde tests te onderhouden.

Vraag leveranciers ook hoe ze met data omgaan en hoe modellen retrainen. Vraag om een 90‑daags adoptieplan met succesmetrics zoals dekkingstoename, testvelocity en vermindering van ontsnapte defects. Neem bovendien een pilot op waarbij een AI‑test in een gecontroleerde omgeving wordt ingezet. Betrek tijdens de pilot QA‑teams, developmentteams en security‑reviewers. Deze cross‑functionele review voorkomt verrassingen en zorgt dat de tool teams controle laat behouden.

Tenslotte: wees terughoudend met tools zoals ChatGPT voor ideevorming en codefragmenten, maar scheid deze van productiesystemen. Voor productieklare automatisering geeft de voorkeur aan dedicated AI‑testtools die koppelen met uw testmanagement en CI. Houd een continue feedbackloop zodat productieincidenten modeltraining verfijnen. Deze governance‑aanpak zorgt ervoor dat AI een robuust onderdeel van uw kwaliteitsmanagement wordt, met minimale risico’s.

FAQ

What is an AI copilot for QA?

Een AI‑copilot voor QA is een assistent die testcases voorstelt, codefragmenten genereert en testscriptvoorstellen doet op basis van requirements, code en telemetry. Hij versnelt het authoren, maar een menselijke reviewer moet outputs valideren voordat ze worden vrijgegeven.

How quickly can teams see value from an AI pilot?

Teams zien vaak binnen twee weken al eerste waarde van een gerichte pilot waarin een paar user stories in de copilot gevoed worden. Dit toont tijdsbesparing, draft‑testopbrengst en dekkingverbeteringen.

Do AI testing tools remove flaky tests automatically?

AI‑testtools kunnen flaky tests verminderen door zelfherstellende locators en slimmer elementidentificatie te gebruiken. Teams moeten echter auto‑wijzigingen reviewen en waarborgen behouden om drift te voorkomen.

How do I prioritise tests with AI?

Gebruik ML‑gebaseerde defectvoorspelling die modules rangschikt op risico met commitgeschiedenis en telemetry. Draai vervolgens gerichte suites op hoogrisicogebieden en voer incidenten terug in de training voor continue verbetering.

Can AI generate unit tests for legacy code?

Ja, AI kan unittests genereren die de coverage van legacycode vergroten. Teams moeten gegenereerde tests reviewen en in de CI‑pipeline integreren om stabiliteit te waarborgen.

What governance is needed for AI in QA?

Governance vereist menselijke review, toegangscontroles voor data, auditlogs en retrain‑beleid voor AI‑modellen. Deze elementen verminderen bias, zorgen voor traceerbaarheid en behouden kwaliteit over tijd.

Which tools should I evaluate first?

Begin met leveranciers die integreren met uw CI en testmanagement. Overweeg Copilot/GitHub Copilot voor codefragmenten en evalueer Testim, Mabl, Diffblue, Functionize en Applitools voor uitgebreidere automatisering.

How do AI and traditional QA work together?

AI ondersteunt traditionele QA door repetitieve taken over te nemen, testscenario’s voor te stellen en suites actueel te houden. Menselijke testers richten zich op exploratory testing, validatie en scenario‑ontwerp.

Is chatgpt useful for test generation?

ChatGPT kan ideevorming doen en testscenario’s opstellen, maar productietests moeten voortkomen uit tools die direct koppelen aan CI en testmanagement voor traceerbaarheid en reproduceerbaarheid.

How should I measure success for an AI QA rollout?

Meet dekkingstoename, testvelocity, vermindering in onderhoudsuren en ontsnapte defects in productie. Gebruik deze metrics om tooling en governance iteratief te verbeteren.

Ready to revolutionize your workplace?

Achieve more with your existing team with Virtual Workforce.