Hur en AI‑copilot hjälper QA‑team att automatisera testskapande (ai, qa, copilot, test creation)

AI hjälper till att snabba upp TESTSKAPANDET genom att förvandla krav, kod och användarflöden till användbara testutkast. Först läser en copilot användarberättelser och koddiffar. Därefter föreslår den testfallsöversikter, enhetstester och UI‑steg. Som kontext förutspår Gartner en snabb ökning av användningen av kodassistenter för utvecklare; till 2028 kommer tre fjärdedelar av företagsmjukvaruingenjörer att använda AI‑kodassistenter enligt branschrapportering. Dessutom förkortar team som tar till sig en copilot ofta tiden från story till automatiserat test.

Till exempel kan AI utarbeta enhetstester liknande Diffblue, skapa UI‑flöden som Testim eller Mabl och föreslå visuella assertioner i stil med Applitools. Dessutom kan naturligt‑språkiga tester som läses som acceptanskriterier produceras, liknande Functionize. Dessa resultat sträcker sig från korta testfallssnuttar till fullständiga testskript. För enhetstestning, använd en AI‑copilot för att generera JUnit‑ eller Playwright‑exempel och förfina dem sedan. För UI‑arbete, be copiloten exportera steg till ett testramverk eller till Playwright‑kod. Detta tar bort repetitivt skriptarbete.

Mät effekten med enkla KPI:er. Följ tiden till första automatiserade testet och procentuell ökning i testtäckning per sprint. Följ även antalet testscenarioutkast som skapas per user story. Ett snabbt åtgärdssteg är att köra en två‑veckors pilot som matar in tre till sex user stories i en AI‑copilot och sedan jämföra manuellt mot AI‑genererat testutfall. Denna pilot kan visa täckningsvinster, avslöja luckor i copilots kontexthantering och visa hur enkelt team kan mappa tester in i CI‑pipen.

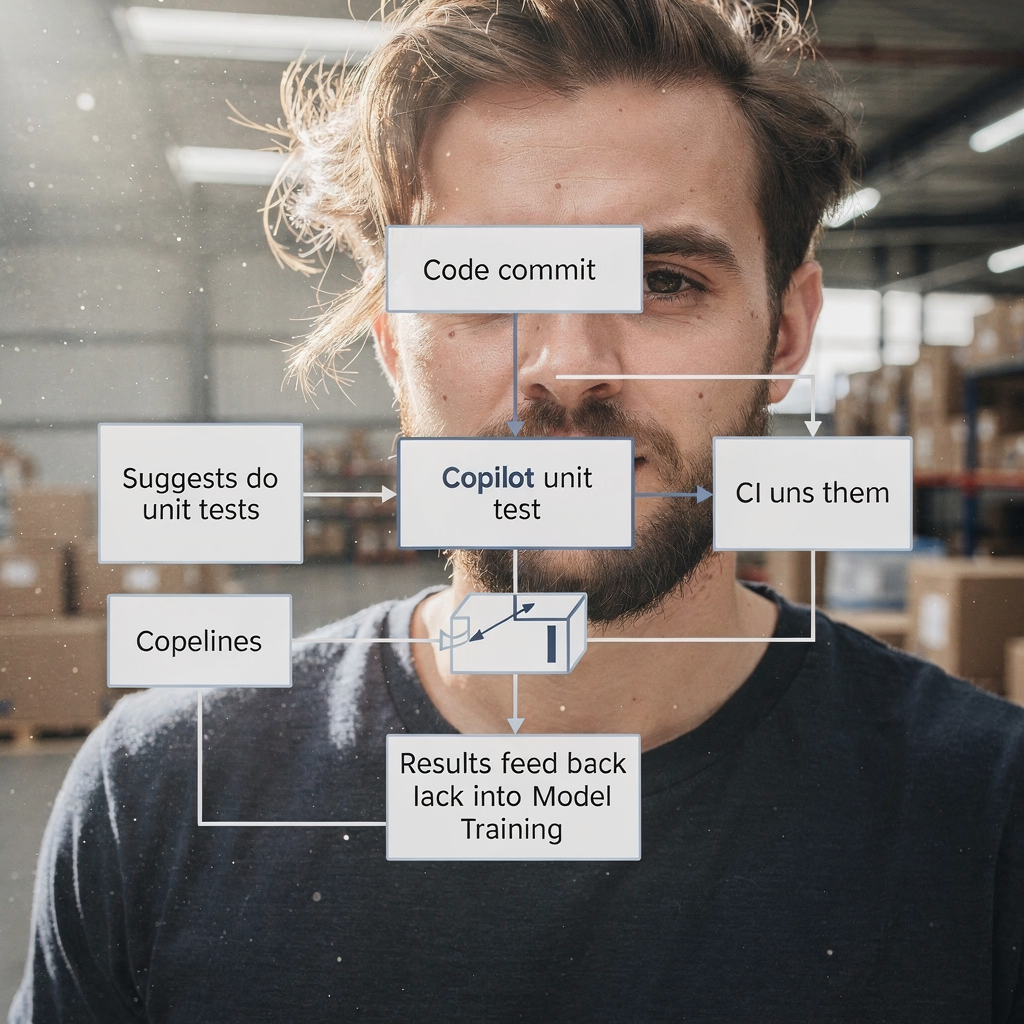

Praktiskt, integrera copilots förslag i en PR‑workflow. Låt copiloten föreslå testfiler på feature‑branchen. Låt sedan en QA‑ingenjör eller testare granska de föreslagna testerna. Detta minskar tiden som läggs på boilerplate. Slutligen förstår team att en AI‑copilot påskyndar författandet utan att ersätta mänskligt omdöme. För vidare läsning om automatisering av operativa meddelanden och liknande arbetsflöden, se vår resurs om hur man skalar logistiska operationer med AI‑agenter hur man skalar logistiska operationer med AI‑agenter.

Använd ai‑testverktyg för att automatisera QA‑processen och minska testunderhållet (ai testing tools, automate, qa process, automated test, self‑healing)

AI‑testverktyg erbjuder självhelande locatorer och funktioner för elementidentifiering som dramatiskt minskar flakiness. Till exempel anpassar verktyg som Testim och Mabl selektorer när DOM:en förändras. Som ett resultat lägger teamen färre timmar på att åtgärda spröda testskript. Dessa verktyg kan också annotera visuella diffs, vilket hjälper visuella regressionskontroller att förbli korrekta. Använd en automatiserad testrunner som stödjer självhelning så att teströret förblir pålitligt.

AI tar dock inte bort behovet av styrning. Granska auto‑uppdaterade tester innan release och behåll en människa i loopen. Ett aktuellt whitepaper säger, ”AI can support many aspects of QA, but it also introduces critical risks that demand careful attention” enligt branschanalys. Därför bör ni behålla godkännandegates och integrera ändringsloggar. Använd även telemetry för att upptäcka när självhelning eventuellt har flyttat testintentionen.

För att genomföra detta, integrera testverktyget i CI så att uppdateringar körs automatiskt på PR:er. Sätt sedan en regel: självhelade ändringar måste granskas inom releasefönstret. Följ minskning i flakiga fel och underhållstimmar per sprint som framgångsmått. Använd dashboards för att visa trender och fånga regressioner tidigt. Team kan också automatisera rollback av auto‑ändringar om testaren flaggar regressioner.

I praktiken, kombinera självhelning med lättviktig styrning. Spara anonymiserade historiska testruns för modellträning. Koppla verktyget till ert testhanteringssystem så att godkännanden och kommentarer förblir länkade. Detta gör det enklare att granska vem som accepterade AI‑ändringar. För team som hanterar tunga e‑postarbetsflöden eller ärendetrafik visar vår plattform hur man grundar AI‑åtgärder i operativa data och regler; se vår guide om att automatisera logistiska e‑postmeddelanden med Google Workspace automatisera logistiska e‑postmeddelanden med Google Workspace och virtualworkforce.ai. Slutligen, acceptera att AI‑testverktyg minskar underhåll, men bara med rätt kontroller och balanser på plats.

Drowning in emails?

Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

Prioritera testning med AI i QA: defektprediktion, testurval och feedbackloopar (ai in qa, qa teams, feedback loops, metric, defect prediction)

AI i QA kan förutspå var fel mest sannolikt kommer att uppstå. Genom att använda commit‑historik, telemetry och tidigare fel rankar ML‑modeller moduler med hög risk. Följaktligen kan QA‑team köra fokuserade testsviter på dessa områden istället för överallt. Ett riktat angreppssätt minskar antalet undanglidna fel i produktion och snabbar upp releaser. Till exempel, kör en smoke och riktad regression på en modul som flaggats som hög risk, och kör full regression endast vid behov.

Studier visar att AI‑assisterad defektprediktion ökar upptäcktsgraden och låter team fokusera begränsade testresurser där det är mest betydelsefullt. En branschrapport framhåller produktivitetsvinster från AI‑assisterad utveckling, samtidigt som den noterar att kvalitetsförbättringar varierar beroende på team och setup rapporten förklarar. Behandla därför modellutdata som vägledande, inte absoluta sanningar.

Sätt upp kontinuerliga FEEDBACKLOOPAR från produktionsincidenter tillbaka in i modellträningen. Mata anonymiserad telemetry och incidenttaggar in i träningsdata. Träna sedan om periodiskt för att hålla riskprediktionen i takt med senaste förändringarna. Följ undanglidna fel i produktion, falsk negativ‑grad och andelen tester som hoppats över via riskbaserat urval. Använd dessa mått för att stämma av trösklar och för att avgöra när den riktade sviten bör utvidgas.

Involvera även QA‑ingenjörer och QA‑team när modeller ska trimmas. En QA‑ingenjör bör validera modelförslag och märka upp falska positiva. Detta samarbete förbättrar AI‑modellerna. Teamen blir bättre på att triagera problem snabbare och förstår mönster som tidigare doldes i brus. För organisationer som hanterar operativa e‑postflöden och processautomatiseringar hjälper samma feedbackloopsidéer att åtgärda felaktiga klassificeringar; se vår förklaring om hur virtualworkforce.ai minskar handläggningstid och stänger feedbackcykler virtualworkforce.ai ROI och feedback.

Integrera AI‑verktyg med befintlig testautomatisering och testhantering (integrate ai, testing tool, qa tools, framework, test automation)

För att integrera AI i en befintlig stack, anta pragmatiska mönster. Först, lägg till en AI‑copilot som utvecklar‑ eller QA‑assistent i repositoryt. För det andra, koppla testplattformen till ert testhanteringssystem och CI/CD. För det tredje, mappa AI‑utdata till befintliga testramverk som Selenium, Playwright eller JUnit. Till exempel, låt copiloten öppna PR:er som lägger till Playwright‑tester och länka dem till motsvarande ärende‑ID.

Checklista för integration inkluderar åtkomst till kodbasen, anonymiserade historiska testruns, telemetry och taggmappning mellan ert testhanteringssystem och AI‑utdata. Denna metadata gör det möjligt för AI att rekommendera relevanta testscenarier. Behåll även spårbarhet: varje AI‑genererat testfall bör peka tillbaka till kravet och PR:en som introducerade det. Detta förbättrar auditability och minskar duplicerade tester.

Snabba vinster inkluderar att låta copiloten föreslå tester som en del av pull‑request‑kontroller. Till exempel, när en PR ändrar ett betalflöde, låt AI föreslå relaterade testscenarier och skapa tester för funktionell testning och regressionstestning. Sedan kan granskare acceptera eller förfina de genererade testskripten. Detta håller arbetsflödet snabbt samtidigt som kvaliteten bevaras. Integrera även testverktyget med dashboarden så att intressenter ser täckning och fel på ett ställe.

Praktiskt, använd en lättviktsstyrmodell. Ha en backlog för testautomation där föreslagna AI‑ändringar landar. Tilldela sedan en testare att validera. Detta förhindrar okontrollerad drift i testsviten. Se också till att era testramverk är kompatibla; till exempel accepterar moderna Playwright‑uppsättningar genererad kod enkelt. Slutligen, när ni integrerar AI‑verktyg, kontrollera säkerhet, dataåtkomstpolicyer och efterlevnad. Om du vill se hur AI‑agenter kan förankras i operativa data, granska vår artikel om hur du skalar logistiska operationer utan att anställa så skalar du logistiska operationer utan att anställa.

Drowning in emails?

Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.

Användningsfall och QA‑lösningar: vem drar nytta och var man kan tillämpa AI i QA (use cases, qa solutions, software qa, quality engineering, tester)

AI gynnar många användningsfall över QA‑livscykeln. För legacy‑kodbaser kan AI generera enhetstester för att snabbt öka täckningen. För regressionssviter hjälper AI till att hålla UI‑ och API‑tester uppdaterade. För utforskande testning kompletterar AI testare genom att föreslå edge cases eller ovanliga indatasekvenser. För visuell regression hjälper AI till att upptäcka subtila layoutregressioner. Dessa är konkreta QA‑lösningar som team kan driftsätta.

Målgrupper inkluderar QA‑team, QA‑ingenjörer och testare. Testare går från rutinmässig skriptning till scenarioskapande och utforskande kvalitetsteknik. I praktiken blir testarrollen mer strategisk. Testautomation blir ett samarbete mellan mänskligt omdöme och AI‑förslag. Som ett resultat kan team fokusera på att förbättra testscenarier och rotorsaksanalys.

Mätbara fördelar inkluderar sparad tid per release, ökad testtäckning och snabbare rotorsaksanalys. För en pilot, välj ett kritiskt produktområde såsom ett betalflöde. Använd AI för att skapa automatiserade tester för enhet, API och UI‑lager. Mät sedan före‑ och efterutfall: tid att skapa tester, undanglidna fel och regressionstestkörningstid. Denna fokuserade provkörning ger tydlig ROI och lärande.

Överväg också att använda AI‑drivna testval för nattliga körningar för att minska kostnader. Notera att team fortfarande måste utvärdera modeller och se upp för bias. Användningsområden inkluderar mjukvaru‑QA för finansiella system, e‑handelscheckoutflöden och B2B‑integrationer. Dessa är områden där noggrannhet betyder mycket och där AI kan minska repetitivt arbete avsevärt. Slutligen kommer framtidens QA att innehålla mer AI‑stöd, men den mänskliga rollen i att sätta intention och validera resultat kommer att förbli avgörande.

Styrning, begränsningar och val av topp AI‑drivna QA‑verktyg (ai-powered, ai tools, top ai-powered, chatgpt, machine learning, governance)

AI medför både kraft och risker, så styrning är viktigt. Begränsningar inkluderar modellbias, potentiell överberoende och behovet av att underhålla ML‑modeller över tid. Ett whitepaper varnade för att organisationer måste hantera etiska och operativa frågor när de inför generativ AI i QA läs analysen. Implementera därför mänskliga granskningssteg, datastyrning och spårbarhet.

När du väljer AI‑drivna verktyg, utvärdera modellens noggrannhet, integrationsdjup med CI/CD och testhantering, självhelningens kvalitet och förklarbarhet. Kontrollera också säkerhet och regelefterlevnad. Skapa en ett‑sidig upphandlingsmatris som poängsätter leverantörer utifrån integration, underhållsarbete och förväntad ROI. Till exempel kan kandidater att utvärdera inkludera Copilot/GitHub Copilot, Testim, Mabl, Diffblue, Functionize och Applitools. Poängsätt dem utifrån hur väl de passar in i era ramverk, såsom Playwright eller JUnit, och hur de hjälper till att underhålla automatiserade tester.

Kräv också att leverantörer visar hur de hanterar data och hur modeller retränas. Be om en 90‑dagars adoptionsplan med framgångsmått som täckningsökning, test‑velocity och minskning av undanglidna fel. Inkludera dessutom en pilot som använder ett AI‑test i en kontrollerad miljö. Under piloten, involvera QA‑team, utvecklingsteam och säkerhetsgranskare. Denna tvärfunktionella granskning undviker överraskningar och säkerställer att verktyget låter teamen behålla kontrollen.

Var slutligen medveten om verktyg som chatgpt för idéer och kodsnuttar, men separera dessa från produktionssystem. För produktionsklar automation, föredra dedikerade AI‑testverktyg som länkar till ert testhanteringssystem och CI för spårbarhet och reproducerbarhet. Behåll en kontinuerlig feedbackloop så att produktionsincidenter förfinar modellträningen. Detta styrningssätt säkerställer att AI blir en robust del av ert kvalitetsarbete samtidigt som riskerna minimeras.

FAQ

Vad är en AI‑copilot för QA?

En AI‑copilot för QA är en assistent som föreslår testfall, genererar kodsnuttar och föreslår testskript baserat på krav, kod och telemetry. Den snabbar upp författandet, men en mänsklig granskare bör validera utdata innan release.

Hur snabbt kan team se värde från en AI‑pilot?

Team ser ofta initialt värde inom två veckor av en fokuserad pilot som matar några user stories till copiloten. Detta visar tidsbesparingar, utkast‑testyield och täckningsförbättringar.

Tar AI‑testverktyg automatiskt bort flakiga tester?

AI‑testverktyg kan minska flakiness genom att använda självhelande locatorer och smartare elementidentifiering. Dock måste teamen granska auto‑ändringar och behålla styrning för att förhindra drift.

Hur prioriterar jag tester med AI?

Använd ML‑baserad defektprediktion som rankar moduler efter risk med hjälp av commit‑historik och telemetry. Kör sedan riktade sviter på hög‑riskområden och mata incidenter tillbaka till träningen för kontinuerlig förbättring.

Kan AI generera enhetstester för legacy‑kod?

Ja, AI kan generera enhetstester som ökar täckningen för legacy‑kod. Team bör granska genererade tester och integrera dem i CI‑pipen för att säkerställa stabilitet.

Vilken styrning behövs för AI i QA?

Styrning kräver mänsklig granskning, dataåtkomstkontroller, auditloggar och reträningspolicyer för AI‑modeller. Dessa element minskar bias, säkerställer spårbarhet och bibehåller kvalitet över tid.

Vilka verktyg bör jag utvärdera först?

Börja med leverantörer som integrerar med er CI och testhantering. Överväg Copilot/GitHub Copilot för kodsnuttar, och utvärdera Testim, Mabl, Diffblue, Functionize och Applitools för mer omfattande automation.

Hur samarbetar AI och traditionell QA?

AI kompletterar traditionell QA genom att ta hand om repetitiva uppgifter, föreslå testscenarier och hålla sviter uppdaterade. Mänskliga testare fokuserar på utforskande testning, validering och scenarioskapande.

Är ChatGPT användbart för testgenerering?

ChatGPT kan hjälpa till med idéer och utkast till testscenarier, men produktionsprovade tester bör komma från verktyg som länkar direkt till CI och testhantering för spårbarhet och reproducerbarhet.

Hur bör jag mäta framgång för en AI‑QA‑utrullning?

Mät täckningsökning, test‑velocity, minskning i underhållstimmar och undanglidna fel i produktion. Använd dessa mått för att iterera över verktyg och styrningsplaner.

Drowning in emails?

Here’s your way out

Save hours every day as AI Agents label and draft emails directly in Outlook or Gmail, giving your team more time to focus on high-value work.